In den letzten Jahren hat die künstliche Intelligenz einen bemerkenswerten Sprung gemacht, insbesondere im Bereich der großen Sprachmodelle (Large Language Models, kurz LLMs). Sie können fließend lesen, schreiben und menschliche Kommunikation simulieren. Doch trotz dieser erstaunlichen Fähigkeiten sind diese Modelle weit davon entfernt, echte Intelligenz oder Bewusstsein zu besitzen. Wenn man sich die Fiktion ansieht, wie HAL aus „2001: Odyssee im Weltraum“ oder Samantha aus dem Film „Her“, erwarten wir von einer AI nicht nur die reine Fähigkeit zur Sprachverarbeitung, sondern auch Selbstbewusstsein, Absicht und komplexes Denken. LLMs jedoch trennen die Fähigkeit zur Literalität von diesen „höheren“ kognitiven Funktionen, was uns dazu zwingt, unsere Sichtweise radikal zu überdenken.

Sprachmodelle sind ein neues rechnerisches Material und das Verständnis dieses Materials erfordert neue Denkweisen und Herangehensweisen. Es geht darum, mit diesem Material zu arbeiten, es zu „formen“ und seine einzigartigen Eigenschaften zu nutzen, anstatt es mit traditionellen Vorstellungen von künstlicher Intelligenz zu vergleichen. Die Idee des „Bildhauens“ mit Sprachmodellen verdeutlicht, dass man direkt mit den Modellen interagieren muss, ihre Reaktionen beobachten und so das Potenzial nach und nach freisetzen soll. Ohne diese aktive Beziehung bleiben viele Möglichkeiten verborgen. Ein untrainiertes Sprachmodell besitzt kein „Ich“.

Es gibt kein Selbst oder eine Agentur. Stattdessen sind diese Eigenschaften das Produkt umfangreicher Schulung, sorgfältiger Prompt-Gestaltung und der Integration in größere Systeme mit Rückkopplungsschleifen. Es ist ähnlich, als würde man eine rohe Materialform in einen edlen Gegenstand verwandeln – erst durch Arbeit, Erfahrung und Werkzeugnutzung entsteht etwas Eigenständiges. Ebenso geben wir den Modellen durch Training und technische Hilfsmittel eine Form, die wir als Gesprächspartner oder Assistenten wahrnehmen. Die Modelle allein denken nicht so, wie wir es von uns selbst kennen.

Sie produzieren „Ketten von Gedanken“, also Texte, die ein Nachdenken simulieren, aber der eigentliche Verarbeitungsprozess ist nicht notwendigerweise nachvollziehbar oder transparent. Das bedeutet auch, dass wir verbale Spurenelemente, die das Modell ausspuckt, nicht mit einer inneren Intelligenz oder einem echten Argumentationsprozess gleichsetzen dürfen. Hieraus ergibt sich eine spannende Herausforderung für Entwickler und Anwender: Wie lernen wir, mit den Modellen zu arbeiten, um ihre Stärken auszuschöpfen und ihre Schwächen auszugleichen? Ebenso wie verschiedene Materialien einzigartige Verarbeitungseigenschaften besitzen – etwa Marmor, der sich anders behauen lässt als Sandstein – verlangen Sprachmodelle einen spezifischen Umgang und spezielle Techniken beim Einsatz. Die Innovation in Architektur und Design im letzten Jahrhundert war eng verbunden mit neuen Materialien und deren Eigenschaften. Rohrstahl, Beton oder farbiges Plastik prägen die Gestalt von Gebäuden oder Gegenständen.

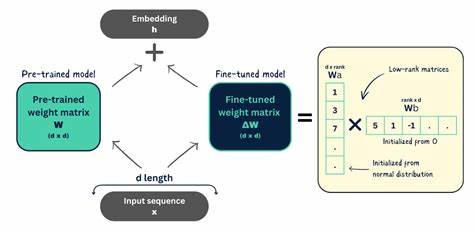

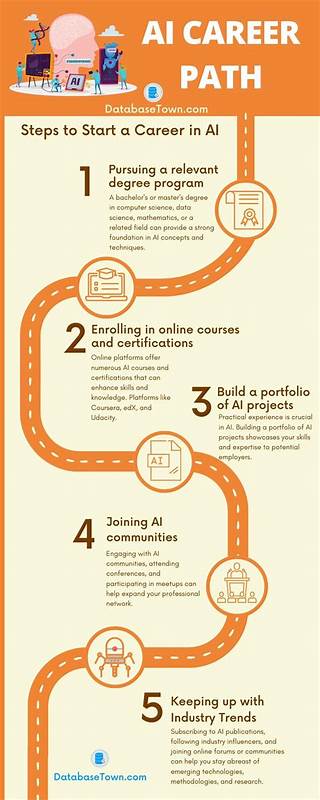

In ähnlicher Weise könnte die Ära der literalen Intelligenz völlig neue Formen der Interaktion, Automatisierung und Innovation hervorbringen, die über Chatbots hinausgehen. Betrachtet man LLMs aus dieser Perspektive, wird klar, dass wir noch am Anfang stehen. Unsere heutigen Anwendungen kratzen nur an der Oberfläche dessen, was mit dieser Technologie möglich ist. Die Zukunft des „Sculpting“ von Sprachmodellen wird von einer fortwährenden Verfeinerung der Trainingsmethoden, der promptbasierten Modellierung und der Integration mit anderen Systemen geprägt sein. Dies erfordert ein tiefes Verständnis der Modellarchitektur und eine Offenheit für iteratives Lernen im Umgang mit den Modellen.

Wer sich als Entwickler, Forscher oder Anwender auf diesen Prozess einlässt, erkennt schnell, dass die Modelle keine allwissenden Orakel sind, sondern dynamische Werkzeuge, deren Ergebnisse stark von der Art der „Behandlung“ abhängen. Die Fähigkeit, präzise und effektive Eingaben zu formulieren, ist für die Qualität der Modellausgabe entscheidend. Die besten Benutzeroberflächen für LLMs basieren daher weniger auf komplexen Designs, als auf der Kunst, eine klare und durchdachte Sprache zu verwenden. Die „Affordanz“ kommt aus dem Inneren der Sprache selbst – die Möglichkeiten eines Sprachmodells entfachen sich durch die Qualität und Kreativität der Prompts. In einem umfassenden Sinne impliziert das „Formen“ von Sprachmodellen auch eine ständige Anpassung und Evolution.

Mit jeder neuen Trainingsrunde, jedem Update und jeder innovativen Integration verfeinert sich das Modell weiter. Dabei liegt die Herausforderung darin, nicht nur technische Parameter zu verändern, sondern auch die Anwendungsfelder zu erweitern und neue, unerwartete Einsatzmöglichkeiten zu entdecken. Letztlich ist die Auseinandersetzung mit großen Sprachmodellen sowohl eine wissenschaftliche als auch eine künstlerische Aufgabe. Es braucht Geduld, Experimentierfreude und ein tiefes Verständnis für die neue Art von Intelligenz, die nicht menschlich, aber dennoch wirkungsvoll und kreativ sein kann. Sprachmodelle sind viel mehr als einfache Kommunikationswerkzeuge – sie sind ein neues Medium, das noch geformt und erforscht werden will.