In der heutigen Zeit, in der Künstliche Intelligenz und insbesondere Large Language Models (LLMs) einen immer bedeutenderen Platz in Softwarearchitekturen und Anwendungen einnehmen, wächst auch der Bedarf an effizienten Agenten-Runtimes. NanoAgent ist ein bemerkenswertes neues Framework, das genau hier ansetzt – und zwar mit einem Ansatz, der auf pure TypeScript-Implementierung und völligen Verzicht auf externe Laufzeitabhängigkeiten setzt. Mit nur rund 1.000 Codezeilen bietet NanoAgent eine schlanke Plattform, um KI-Agenten zuverlässig, transparent und erweiterbar zu betreiben. Dieses minimalistische, aber zugleich leistungsfähige Framework könnte sich als neue Referenz für den Bau von Agenten-Ökosystemen etablieren.

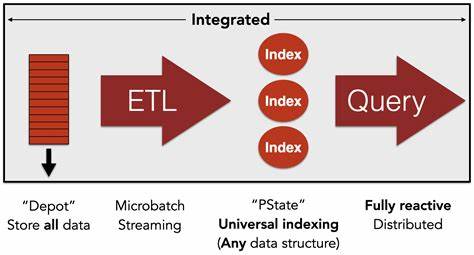

NanoAgent konzentriert sich auf den Kern eines jeden KI-Agenten: die Steuerungsschleife, die Eingaben verarbeitet, Modelle ansteuert, Werkzeuge aufruft und den Zustand des Agenten verwaltet. Die Verantwortung für externe Funktionen wie Retrieval-Augmented Generation (RAG), Vektorsuche, Datenbankverbindungen oder Cloud-Integration wird vollständig an kompatible Werkzeuge ausgelagert. Diese Tools kommunizieren über das Model Context Protocol (MCP), einen offenen Standard, der den Datenaustausch zwischen den einzelnen Komponenten erleichtert und eine modulare Architektur fördert. Die Vision hinter NanoAgent ist simpel und elegant zugleich: Statt eines komplexen Frameworks mit vielen eingebauten Features und Abhängigkeiten soll ein kleiner, auditierbarer Kern entstehen, der als vertrauenswürdige Basis dient. Entwickler sollen jederzeit nachvollziehen können, wie der Agent funktioniert, und dabei auf existierende Chatmodelle wie OpenAI GPT oder lokale Engines wie Ollama zurückgreifen können.

Da NanoAgent ausschließlich in TypeScript entwickelt wurde und keine versteckten Pakete enthält, lassen sich Anpassungen und Erweiterungen leicht realisieren. Ein herausragendes Merkmal von NanoAgent ist die Unterstützung von reinen Funktionen, die den Zustand stets unverändert lassen. Jeder Schritt in der Agenten-Schleife erzeugt eine neue Instanz von AgentState, was die Fehlerdiagnose und das Debugging erheblich vereinfacht. Diese deterministische Ausführung garantiert eine reproduzierbare Agenten-Interaktion, was gerade in professionellen Anwendungen ein entscheidender Vorteil ist. Zusätzlich implementiert NanoAgent integrierte Mechanismen zur Erkennung von Stausituationen: Wenn beispielsweise ein Modell keine Antwort liefert, doppelte Nachrichten erzeugt oder die Werkzeugausgabe fehlt, tritt ein Recovery-Hook in Aktion.

So wird sichergestellt, dass der Agent auch in unerwarteten Situationen stabil bleibt und sich automatisch wieder in einen gesunden Zustand bringt. Die Halting-Gründe wie tool_error, await_user oder done sind klar definiert und unterstützen eine kontrollierte Ablaufsteuerung. Der modulare Aufbau von NanoAgent erlaubt ebenso den Aufbau von Multi-Stage-Workflows. Mithilfe von sogenannten Sequence-Objekten lassen sich komplexe mehrstufige Dialoge oder Wizards realisieren. Dabei bleibt der Zustand konsistent und kann flexibel über verschiedene Stufen hinweg gepflegt und verändert werden.

Die eingebauten JSON-Schema-Tools gewährleisten eine validierte Kommunikation an den Schnittstellen – eine wichtige Voraussetzung für robuste und wartbare Systeme. Für Entwickler und Unternehmen, die auf maximale Performance und geringe Latenzen setzen, bringt NanoAgent native Unterstützung für das JavaScript-Runtime Bun mit. Das erleichtert sowohl schnelle Entwicklungstests als auch den betrieb in Edge-Umgebungen, wo Ressourceneffizienz und Geschwindigkeit entscheidend sind. Zudem bietet Bun als modernes Runtime-System Optionen für nebenläufige und serverseitige Ausführung, was NanoAgent für zukunftsweisende Anwendungsfälle prädestiniert. Der nahtlose Einsatz von NanoAgent mit verschiedenen großen Sprachmodellen ist ein weiterer Pluspunkt.

Auf der einen Seite unterstützt das Framework den Zugriff auf etablierte Cloud-Modelle von OpenAI, einschließlich komfortabler API-Integration. Auf der anderen Seite erlaubt es die Verbindung mit lokalen Modellen, etwa Mistral oder Llama, die zum Beispiel über Ollama betrieben werden – vollkommen unabhängig von Cloud-Abhängigkeiten. So können Anwender flexibel entscheiden, ob sie auf proprietäre Dienste setzen oder Open-Source-Alternativen bevorzugen. Mit seinem minimalen Kern und der schlanken Architektur bietet NanoAgent auch eine zukunftssichere Grundlage für skalierbare Systemlandschaften. Das MCP ermöglicht eine horizontale Skalierung durch entkoppelte, zustandslose Tool-Endpunkte, die über HTTP kommunizieren.

Dadurch lassen sich Tools in beliebigen Programmiersprachen (Go, Python, Rust) realisieren und leistungsfähig auf verschiedensten Infrastrukturumgebungen betreiben – egal ob GPU-Pods in der Cloud oder lokale Edge-Server. Die Verbindung zu solchen externen Tools kann über die MCP-Client- und Server-Komponenten von NanoAgent komfortabel hergestellt werden. Entwickler können Werkzeuge über die API entdecken, abrufen und nahtlos in den Agenten-Workflow einbinden. Dies fördert eine klare Trennung von Kernlogik und externen Diensten, was Wartung, Updates und Erweiterungen massiv vereinfacht. Durch das offene Design hat NanoAgent auch eine hohe Transparenz in Bezug auf Sicherheit und Nachvollziehbarkeit.

Anwender können den gesamten Quellcode in wenigen Stunden durchgehen, einzelne Schritte prüfen und sich von der Sauberkeit des Codes überzeugen. Dieser Aspekt ist besonders relevant für Unternehmen, die KI-Agenten in sensiblen Umgebungen einsetzen und volle Kontrolle über das eingesetzte Framework benötigen. Trotz der technischen Tiefe bleibt NanoAgent auch für Einsteiger und Entwicklerteams mit begrenzten Ressourcen attraktiv. Die einfach gehaltene API und klare Konzepte erlauben einen schnellen Einstieg. Die bereitgestellten Beispiele und Dokumentationen unterstützen den Einstieg und ermöglichen bereits nach kurzer Zeit die Entwicklung produktionsreifer Agentenlösungen.

Aufgrund der agilen und offenen Entwicklung setzt NanoAgent auch auf eine aktive Community und stetige Verbesserung. Das Projekt ist unter der MIT-Lizenz veröffentlicht, was maximale Freiheit bei Nutzung, Anpassung und Verteilung gewährleistet. Zugleich gibt es klare Codierungsrichtlinien, die auf einen schlanken Code und das Vermeiden von unnötigen Abhängigkeiten achten – Qualität vor Quantität. Zusammenfassend lässt sich sagen, dass NanoAgent das Potenzial hat, die Art und Weise zu verändern, wie KI-Agenten entwickelt, betrieben und skaliert werden. Das Framework kombiniert moderne Prinzipien der Softwareentwicklung mit den spezifischen Bedürfnissen von LLM-Anwendungen und schafft so ein Werkzeug, das sowohl technisch als auch praktisch überzeugt.

Die Kombination aus null externen Abhängigkeiten, minimalistischer Codebasis und umfassenden Funktionalitäten macht NanoAgent zu einem spannenden Player im Bereich der KI-Agenten-Technologien. Mit NanoAgent setzen Entwickler nicht nur auf ein modernes, transparentes und effizientes System – sie investieren auch in die Zukunftsfähigkeit ihrer KI-Lösungen. Ob für kleine Prototypen, akademische Projekte oder den produktiven Einsatz in Unternehmen, NanoAgent bietet ein robustes, übersichtliches und wertvolles Fundament für die nächste Generation von Sprachmodell-Agenten.