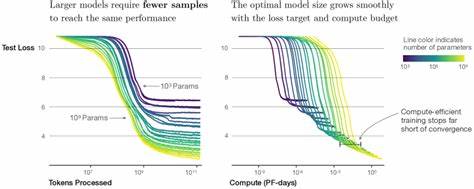

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Künstliche Intelligenz in den letzten Jahren maßgeblich geprägt. Während bisher Neural Scaling Laws wichtige Grundlagen für Wachstum und Leistungsfähigkeit dieser Modelle lieferten, bleibt das Verständnis der tieferliegenden Trainingsdynamiken oft unzureichend und komplex. Hier setzt die innovative Forschung im Bereich der Neural Thermodynamic Laws (NTL) an, welche eine Brücke zwischen klassischer Thermodynamik und moderner KI-Forschung schlägt und damit frische, wissenschaftlich fundierte Perspektiven eröffnet. Das Konzept der Neural Thermodynamic Laws basiert auf einer Analogie zwischen dem Verhalten großer neuronaler Netzwerke und den thermodynamischen Prinzipien, die in der Physik zur Beschreibung von Energieflüssen und Zustandsgleichgewichten genutzt werden. Diese Herangehensweise betrachtet die Trainingsprozesse großer Sprachmodelle als Systeme, in denen quantifizierbare Größen wie Temperatur, Entropie oder Wärmeleitung nicht nur metaphorische Rollen spielen, sondern praktische Aussagen über das Lernverhalten erlauben.

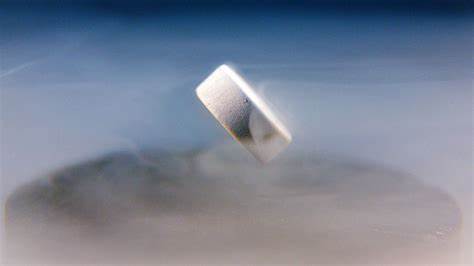

Im Zentrum der NTL-Forschung steht das Bild einer sogenannten „River-Valley Loss Landscape“, die das Verlaufsprofil der Fehlerfunktion beim Training beschreibt. Diese Landschaft gleicht einem Flusstal, in dem sich das Modell auf natürliche Weise in Richtung eines Minimums bewegt, vergleichbar mit Wasser, das sich seinen Weg entlang eines Tales sucht. Unter dieser Annahme zeigen sich thermodynamische Größen und bekannte Gesetze überraschend plastisch als Erklärungsgrundlage. Die Temperatur in diesem Zusammenhang reflektiert eine Art Maß für die Variabilität oder Unsicherheit während der Parameteranpassung. Analog zur physikalischen Temperatur kann sie als Indikator für die Lernstabilität und Anpassungsbereitschaft eines Modells interpretiert werden.

Entropie steht hierbei für die Diversität möglicher Modellzustände, also die Freiheit des Systems sich zu verändern und zu explorieren. Ein höheres Entropieniveau bedeutet mehr Flexibilität bei gleichzeitiger Unsicherheit, woraus sich Rückschlüsse auf die Balance von Exploration und Exploitation schließen lassen. Die Einführung der Wärmeleitfähigkeit in das Modell bietet zudem einen quantitativen Zugang zur Geschwindigkeit von Informations- und Fehlerausgleich im Netzwerk. Wie Wärme in einem physikalischen Medium von einem heißeren zu einem kühleren Bereich fließt, so werden Fehler- und Gewichtsanpassungen auf den verschiedenen Ebenen und Knoten des neuronalen Netzes verteilt. Dieses Prinzip beschreibt den effizienten Transfer von Lerndynamiken und kann helfen, Trainingsprozesse zu optimieren.

Eines der bahnbrechendsten Ergebnisse der NTL-Forschung ist die Bestätigung der klassischen drei Thermodynamischen Gesetze im Kontext des LLM-Trainings. Das erste Gesetz, das Energieerhaltung entspricht, manifestiert sich hier als Erhaltung der Gesamtleistung und Balance der Modellparameter über die Trainingszyklen hinweg. Das zweite Gesetz, welches den Anstieg der Entropie beschreibt, veranschaulicht, warum Modelle im späteren Training stabilere und besser generalisierende Zustände erreichen. Das dritte Gesetz, das die Annäherung an einen Zustand minimaler Entropie bei absoluten Nullpunkten besagt, ist im KI-Kontext äquivalent zur Konvergenz hin zu einem optimalen, energiesparenden Modellzustand. Darüber hinaus bietet das Equipartitionstheorem aus der Thermodynamik, das die Energie gleichmäßig auf alle Freiheitsgrade eines Systems verteilt, eine zusätzliche Erklärung für das Verhältnis von Parameteranpassung und Modellkomplexität.

Dieses Prinzip hilft dabei, die idealen Lernraten zu bestimmen und Über- oder Unteranpassungen zu vermeiden. Die praktischen Implikationen der Neural Thermodynamic Laws sind vielfältig. Durch das Verständnis thermodynamischer Größen kann die Entwicklung neuer Lernratenpläne deutlich verfeinert und an die jeweiligen Phasen des Trainingsablaufs angepasst werden. Beispielsweise ermöglichen adaptive Lernraten, die sich an temperatur- oder entropieähnlichen Messungen orientieren, ein stabileres und effizienteres Training, wodurch Rechenressourcen eingespart und bessere Modellergebnisse erzielt werden können. Ebenso kann das Konzept Wärmeleitung als Ansatz zur Verbesserung der Informationsverteilung innerhalb des Modells genutzt werden.

Verbessert man den Fluss von Gradienten und Fehlerkorrekturen innerhalb des Netzwerks, lassen sich Engpässe bei der Optimierung vermeiden und eine gleichmäßigere Lernleistung etablieren. Dies ist besonders relevant bei sehr tiefen und komplexen Modellen, bei denen einzelne Schichten oder Parametergruppen unterschiedlich stark lernen oder stagnieren. Die Verbindung von physikalischen Gesetzen und künstlicher Intelligenz eröffnen neue Forschungsmöglichkeiten, die weit über den Bereich der Sprachmodelle hinausgehen. Die NTL-Methode kann auf andere KI-Architekturen transferiert werden und bietet ein universelles Framework, um Trainingsprozesse ganzheitlich zu verstehen und systematisch zu verbessern. Zusätzlich trägt diese interdisziplinäre Sichtweise zu einem tieferen Verständnis der Lernmechanismen bei, die bislang vor allem empirisch erforscht wurden.

Zukünftige Forschungsarbeiten werden darauf abzielen, die bisherigen theoretischen Erkenntnisse experimentell in groß angelegten Trainingsszenarien zu validieren und weiter zu optimieren. Die genaue Quantifizierung thermodynamischer Parameter in praktischen Anwendungssituationen, die Integration in bestehende Frameworks sowie die Automatisierung adaptiver Lernstrategien versprechen signifikante Fortschritte. Jenseits der Optimierung stellen Neural Thermodynamic Laws auch einen konzeptionellen Schritt dar, die oft als Blackbox wahrgenommenen neuronalen Netzwerke transparenter und erklärbarer zu machen. Die Implementierung der Neural Thermodynamic Laws markiert einen bedeutenden Schritt in der KI-Entwicklung. Eine wissenschaftlich fundierte und universell anwendbare Beschreibung der Trainingsdynamik macht Fortschritte wie effizientere Lernalgorithmen und robustere Modelle möglich.

Zudem wird die Erforschung thermodynamischer Analogien in der KI eine noch tiefere Verschmelzung von Physik und Informatik fördern und so die Innovationskraft bei der Entwicklung intelligenter Systeme weiter steigern. Zusammenfassend lässt sich sagen, dass die Einführung der Neural Thermodynamic Laws eine neue Ära im Verständnis und Optimieren großer Sprachmodelle einläutet. Neben theoretischen Grundlagen verhelfen diese Prinzipien zu praktischen Werkzeugen, die das Training nicht nur effektiver, sondern auch nachhaltiger gestalten. Die Kombination von klassischer Thermodynamik und modernem maschinellem Lernen zeigt eindrucksvoll, wie interdisziplinäre Ansätze zukünftige Technologien revolutionieren können.