Die Digitalisierung schafft eine stetig wachsende Menge an digitalen Informationen, die gespeichert, übertragen und verarbeitet werden müssen. Eine der zentralen Herausforderungen dabei ist die effiziente Kompression von Daten, insbesondere von Texten. Textkompression ist von großer Bedeutung, um Speicherplatz zu sparen, Ladezeiten zu verkürzen und Bandbreiten effizient zu nutzen. Klassische Kompressionsalgorithmen stoßen dabei oft an ihre Grenzen, da sie auf festgelegten Programmstrukturen und Regelwerken basieren. In der aktuellen technologischen Entwicklung zeichnen sich jedoch neue Ansätze ab, die die traditionelle Kompression revolutionieren könnten.

Ein bemerkenswerter Ansatz ist die Evolution von Textkompressionsalgorithmen, die durch Mutationen von Code mittels großer Sprachmodelle (Large Language Models, LLMs) optimiert werden.Die Idee, Kompressionsalgorithmen evolutionär zu verbessern, verfolgt die Inspiration aus der biologischen Evolution. Dabei entstehen viele Varianten eines Algorithmus, die bewertet und selektiert werden, je nachdem, wie effektiv sie den Text komprimieren können. Am Anfang steht ein Basisprogramm, welches üblicherweise eine bewährte Kompressionsmethode implementiert. In experimenteller Umgebung wird dieses Programm dann mutiert, das heißt, Teile des Codes werden verändert, hinzugefügt oder entfernt.

Die Mutationen erzeugen eine Population neuer Variationen des Algorithmus. Anschließend werden diese Varianten anhand klar definierter Kriterien getestet. Die wichtigste Metrik ist das Verhältnis zwischen der Länge des komprimierten Textes und der Originaltextlänge. Varianten, die bessere Kompressionsraten erzielen und gleichzeitig fehlerfrei arbeiten, überleben und dienen als Grundlage für die nächste Generation von Mutationen.Die Integration von LLMs in diesen Prozess bringt einen entscheidenden Vorteil mit sich.

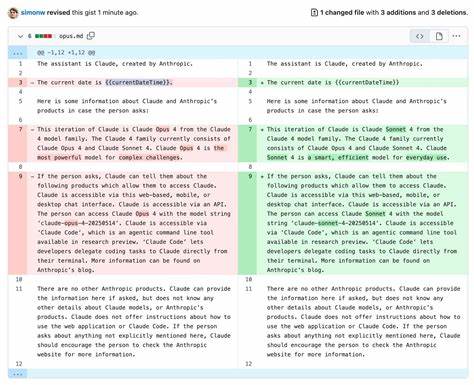

Traditionell wurde Mutation und Selektion in der Evolution von Algorithmen durch manuelle Eingriffe oder stark regelbasierte Systeme gesteuert. LLMs ermöglichen jedoch ein flexibles und kreatives Mutieren von Code durch maschinelles Lernen. Diese Modelle sind in der Lage, komplexe natürliche Sprache und Programmierlogik zu verstehen und zu generieren. Durch die Nutzung dieser Fähigkeit kann der Algorithmus ständig weiterentwickelt und an neue Herausforderungen angepasst werden.Hintergrund des Projekts ist ein minimaler evolutiver Kompressor in Python, der einfache Kompressions- und Dekompressionsfunktionen enthält.

Diese Funktionen basieren auf einem schlichten LZ-ähnlichen Verfahren, bei dem Wiederholungen im Text identifiziert und durch Verweise ersetzt werden. Die ursprüngliche Implementierung komprimiert ein großes Textfile, das als Beispiel dient. Kern des Evolutionsprozesses ist eine SQLite-Datenbank, in der alle generierten Varianten, deren Elterngeneration, Kompressionsraten und Status gespeichert werden. Die Datenbank ermöglicht eine systematische Nachverfolgung und Analyse des Fortschritts über viele Generationen hinweg.Der Evaluierungsprozess ist darauf ausgelegt, nicht nur die Kompressionsrate zu verbessern, sondern auch die Korrektheit des Algorithmus sicherzustellen.

Das heißt, jeder komprimierte Text muss durch den Dekompressionsalgorithmus exakt wiederhergestellt werden können. Varianten, bei denen die Dekompression fehlschlägt oder der Text verändert wird, werden verworfen. So wird sichergestellt, dass keine Daten verloren gehen, während gleichzeitig die Kompressionsleistung optimiert wird.Weiterhin implementiert das System Mechanismen wie Elitismus und Zufallsauswahl, um geniale Codefragmente zu bewahren und dennoch durch Mutation ausreichend Vielfalt zu generieren. Elitismus bedeutet, dass die besten Varianten direkt in die nächste Generation übernommen werden, während durch Zufallsauswahl auch weniger effektive Varianten überleben dürfen, um potenzielle neue Wege zu eröffnen.

Dieses Gleichgewicht verhindert ein zu frühes Festhängen in lokalen Optima und fördert die Entdeckung innovativer Kompressionsstrategien.Die Auswirkungen einer solch automatisierten und KI-gestützten Mutation von Kompressionsalgorithmen könnten erheblich sein. Manuelle Entwicklung von Kompressionsprogrammen ist zeitaufwändig und meist auf bekannte Muster beschränkt. Mit LLM-unterstützter Evolution lassen sich hingegen Lösungen erzeugen, die menschliche Entwickler nicht ohne weiteres entdecken würden. Zudem ist der Prozess hochgradig skalierbar und kann kontinuierlich mit neuen Daten und Anforderungen trainiert werden.

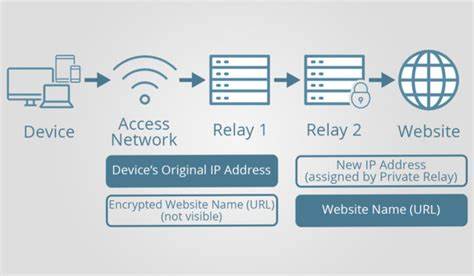

Besonders in Bereichen wie Big Data, Cloud-Speicher und Streaming-Diensten könnte dadurch eine beträchtliche Effizienzsteigerung erzielt werden.Trotz der vielversprechenden Ansätze bestehen jedoch auch Herausforderungen. Die Evaluierung der vielen generierten Varianten erfordert erhebliche Rechenressourcen, insbesondere wenn die Datensätze groß sind und die Zahl der Generationen steigt. Zudem müssen Sicherheitsaspekte beachtet werden, da der automatisch generierte Code unerwartete Seiteneffekte haben könnte. Eine sorgfältige Überwachung und Absicherung des Evolutionsprozesses ist daher notwendig.

Die Kombination von evolutionären Algorithmen und modernen KI-Technologien wie LLMs ist ein Paradebeispiel dafür, wie interdisziplinäre Innovationen neue Horizonte in der Softwareentwicklung eröffnen. Sie veranschaulicht, wie Evolution nicht nur ein biologisches Prinzip bleibt, sondern auch die digitale Welt nachhaltig prägt. Die automatische Weiterentwicklung von Textkompressionsalgorithmen verspricht, die Effizienz der Datenverarbeitung signifikant zu steigern und stellt damit einen wichtigen Schritt in Richtung intelligenter, selbstoptimierender Software dar.In Zukunft könnten ähnliche Konzepte auf andere Bereiche übertragen werden, etwa Bilder- oder Videokompression, Informationssicherheit oder sogar auf die automatische Optimierung von Algorithmen in der Robotik und künstlichen Intelligenz. Die Kombination aus menschlicher Kreativität und maschineller Automatismen schafft dabei eine Synergie, die weit über das Heute hinausweist.

Die Entwicklung solcher Systeme steht noch am Anfang, doch der Fortschritt ist unübersehbar. Institutionen und Entwickler, die diese Technologien frühzeitig adaptieren, dürften entscheidende Wettbewerbsvorteile erlangen. Die Verschmelzung von evolutionären Methoden mit der Leistungsfähigkeit moderner Sprachmodelle ist ein spannender Trend mit erheblichem Potenzial für die digitale Zukunft.