Die Cloud hat die Art und Weise, wie Unternehmen IT-Ressourcen nutzen, revolutioniert. Dank der enormen Flexibilität und der Möglichkeit, Infrastruktur dynamisch an den Bedarf anzupassen, öffnet die Cloud ungeahnte Chancen sowohl für Unternehmen als auch für Entwickler. Doch so groß die Vorteile auch sind, es gibt eine Hürde, die viele Unternehmen beschäftigt – die Balance zwischen Auslastung, Kosten und Zuverlässigkeit, insbesondere bei Anbietern wie AWS. Autoscaling, also das automatische Hoch- und Runterskalieren von Ressourcen basierend auf der tatsächlichen Nachfrage, ist eine der wichtigsten Innovationen, um Kosten zu kontrollieren und gleichzeitig eine hohe Verfügbarkeit zu gewährleisten. Die Grundidee ist einfach: Nutze nur so viele Ressourcen, wie wirklich benötigt werden, und fahre diese bei sinkender Last wieder herunter.

Allerdings offenbart sich in der Praxis ein Dilemma, das oft übersehen wird: viele Unternehmen fahren eine konservative Strategie, die dazu führt, dass ihre Compute-Infrastruktur häufig nur zu 40 bis 60 Prozent ausgelastet ist. Das bedeutet, dass fast die Hälfte der gemieteten Cloud-Ressourcen quasi ungenutzt herumsteht und trotzdem Kosten verursacht. Diese Zurückhaltung ist verständlich, denn Ausfallzeiten können Unternehmen teuer zu stehen kommen, sowohl im Hinblick auf den Umsatz als auch auf die Unternehmensreputation. Daher wird oft eine Sicherheitsmarge eingeplant, die zusätzlichen Pufferkapazitäten einfordert, um plötzliche Lastspitzen zuverlässig bedienen zu können. Doch genau hier liegt das Problem: Die Angst vor unvorhersehbaren Lastanstiegen – und die Ungewissheit, wie schnell neue Ressourcen bereitgestellt werden können – führt dazu, dass viele Cloud-Nutzer im Wesentlichen viele Ressourcen dauerhaft verschwendet vorhalten.

Der Kern der Schwierigkeit liegt in der Variablen r – der Steigerungsrate der Nutzung. Niemand kann mit absoluter Sicherheit vorhersagen, wie sich der Ressourcenbedarf in den nächsten Minuten oder Stunden entwickeln wird. Dabei ist die Zeit t bis zur Bereitstellung neuer Kapazitäten entscheidend, denn diese Schwankungen müssen abgefangen werden, ohne dass es zu Serviceunterbrechungen kommt. Um Risiken zu minimieren, wird also die Zielauslastung U bewusst niedriger gehalten, um so einen größeren Spielraum für die temporäre Überlastung sicherzustellen. Diese Art des Risikomanagements führt zu ineffizienten Auslastungszahlen und unnötig hohen Kosten.

Immerhin zahlen Unternehmen für Ressourcen, die entweder kaum oder gar nicht genutzt werden. Gerade bei AWS können solche ungenutzten Kapazitäten schnell zu einer erheblichen finanziellen Belastung werden, die im Jahresverlauf leicht mehrfach Hunderttausend Euro erreichen kann, abhängig von der Größe und dem Business-Modell des Unternehmens. Hier kommt eine spannende Entwicklung ins Spiel: Künstliche Intelligenz (KI) und maschinelles Lernen bieten das Potenzial, die Unsicherheit rund um die Nutzungsrate r drastisch zu reduzieren. Statt auf konservative Schätzungen und Erfahrungswerte zu setzen, können historische Nutzungsdaten und externe Einflussfaktoren automatisiert und präziser analysiert werden. KI-Modelle sind in der Lage, Muster zu erkennen, saisonale Schwankungen zu berücksichtigen und auf Basis realer Daten fundierte Prognosen über bevorstehende Lastspitzen zu erstellen.

Mit einem solchen Wissen lässt sich die Zielauslastung U weit nach oben setzen, ohne das Risiko einer Überlastung nennenswert zu erhöhen. Dadurch verringert sich der Bedarf an dauerhaft vorgehaltener Reservekapazität, was sich unmittelbar in niedrigeren AWS-Rechnungen niederschlägt. Die Infrastruktur kann deutlich effizienter genutzt werden, Ressourcen werden besser ausgelastet und der Business-Case cloudbasierter IT wird insgesamt attraktiver. Der Nutzen eines solchen KI-gestützten Ansatzes geht aber weit über die reine Kostenersparnis hinaus. Ein zuverlässiger Trend in der Cloud-Entwicklung ist das agile Arbeiten und die kontinuierliche Verbesserung von Produkten und Diensten durch schnelle Iterationen.

Eine präzise Bedarfsprognose erlaubt es technischen Teams, ihre Infrastrukturausrichtung flexibler und dynamischer zu steuern. So kann die IT-Landschaft sich an neue Anforderungen anpassen, ohne dass aus Angst vor unvorhersehbaren Änderungen hohe Sicherheitsmargen in Kauf genommen werden müssen. Trotz der großen Chancen bleibt das Thema jedoch komplex. Datenschutz, Hardware-Latenzen, Knotenverfügbarkeiten und unerwartete externe Ereignisse können Prognosen erschweren. Es ist daher wichtig, KI-Modelle kontinuierlich zu überwachen, zu validieren und bei Bedarf mit neuen Daten nachzuschulen.

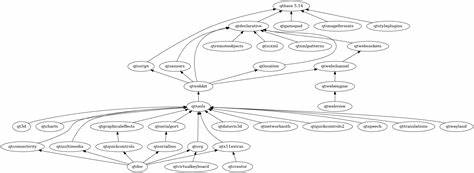

Auch müssen Unternehmen die Implementierung solcher Technologien als ganzheitlichen Prozess verstehen, der technische, organisatorische und kulturelle Aspekte umfasst. Amazon Web Services bietet inzwischen eigene Tools und Services, die Machine Learning nutzen, um die Auslastung effizienter zu gestalten. Ergänzende Technologien wie AWS Lambda, Containerisierung mit Kubernetes oder Fargate-Services können durch automatisiertes Skalieren ihre Ressourcen noch feiner anpassen. Dennoch lohnt es sich oft, spezialisierte Lösungen oder Beratungen hinzuzuziehen, um die individuelle IT-Landschaft optimal zu analysieren und zu steuern. Unternehmen, die es schaffen, ihre Computerauslastung durch den geschickten Einsatz von KI zu optimieren, profitieren auf mehreren Ebenen.

Zum einen werden die Betriebskosten spürbar reduziert, ohne die Zuverlässigkeit zu beeinträchtigen. Zum anderen verbessert sich die ökologische Bilanz, da Rechenzentren effizienter genutzt werden und weniger Energie durch Leerlaufverschwendung verloren geht. Dies kann in Zeiten wachsender Nachhaltigkeitsanforderungen nicht hoch genug bewertet werden. Zudem erlaubt eine höhere Kostentransparenz und verbesserte Nutzung der Cloud-Kapazitäten den Entwicklern und Produktteams, ihre Innovationen schneller und kosteneffektiver voranzubringen. Freigewordene Budgets lassen sich in neue Features, bessere Performance oder zusätzliche Sicherheitsmechanismen investieren.

So entsteht eine Win-win-Situation für das gesamte Unternehmen. Abschließend lässt sich sagen, dass die Ära der klassischen, vorsichtigen Autoscaling-Strategien langsam an ihr Ende kommt. Die Kombination aus datengetriebenen Prognosen, künstlicher Intelligenz und flexiblen Cloud-Technologien eröffnet neue Wege, Computerauslastung smarter zu gestalten. Die Herausforderung für Unternehmen ist es nun, diese Technologien richtig einzusetzen und so das Gleichgewicht aus Kostenkontrolle, Zuverlässigkeit und Innovationskraft neu auszutarieren. Wer also in der Cloud unterwegs ist, sollte nicht länger in Angst vor unvorhergesehenen Lastspitzen verharren, sondern die Möglichkeiten moderner Prognosemodelle nutzen, um seine Projektionsunsicherheiten abzufedern.

Nur so wird es möglich sein, die AWS-Rechnung zu optimieren, das Potenzial der Cloud voll auszuschöpfen und letztlich Wettbewerbsvorteile im digitalen Zeitalter zu sichern.