Die asynchrone Programmierung in Python ist seit der Einführung von Asyncio ein weit verbreitetes Paradigma, das viele Entwickler nutzen, ohne tatsächlich zu verstehen, wie es funktioniert. Oft wird Asyncio als eine Art Magie empfunden – man schreibt einfach async Funktionen, versieht sie mit await und alles läuft scheinbar problemlos. Doch was passiert wirklich hinter den Kulissen, wenn der Interpreter bei einem await anhält und dann zahlreiche Tasks scheinbar gleichzeitig ausgeführt werden? Wer übernimmt die Arbeit während des Wartens und wie werden die Ergebnisse an die entsprechenden Funktionen zurückgegeben? Diese Fragen wollen wir aufdröseln und das Geheimnis um Asyncio lüften, indem wir Asyncio von Grund auf neu aufbauen, Schritt für Schritt, und dabei ganz ohne Magie auskommen. Im Kern basiert Asyncio auf kooperativem Multitasking, das bedeutet, dass mehrere Aufgaben durch ausdrückliches Verwalten der Steuerung gemeinsam laufen, ohne sich gegenseitig zu blockieren. Python stellt dafür Generatoren und Coroutinen zur Verfügung, mit denen sich Funktionen anhalten und wieder aufnehmen lassen.

Genau diese Mechanismen bilden die Basis unseres eigenen Event Loops, der mehrere Aufgaben gleichzeitig bearbeiten kann, indem er jeweils bei einem bestimmten Punkt pausiert und später fortsetzt. Generatoren in Python sind spezielle Funktionen, die mit yield Werte zurückgeben und ihren Zustand dabei beibehalten. Jedes Mal, wenn eine yield-Anweisung erreicht wird, pausiert die Funktion und gibt den Wert zurück. Später kann die Funktion dort weiterlaufen, wo sie aufgehört hat. Interessanterweise können diese Generatoren auch Werte von außen erhalten durch die Methode send(), womit sie nicht nur Werte produzieren, sondern auch konsumieren können.

Eine solche bidirektionale Kommunikation macht diese Generatoren zu Coroutinen, die perfekt geeignet sind für asynchrone und kooperative Programmierung. Ein praktisches Beispiel ist die Erzeugung der Fibonacci-Zahlen mithilfe eines Generators, der bei jeder Iteration eine Zahl zurückgibt und dann pausiert. Daraus lässt sich eine weitere Coroutine erstellen, die nur gerade Zahlen filtert, indem sie Werte sendet bekommt und mit yield wieder pausiert. Dieses Prinzip zeigt, wie sich Funktionen fließend anhalten und fortsetzen lassen, je nachdem, welche Daten gerade verarbeitet werden oder auf welche Ereignisse gewartet wird. Um mehrere solcher Coroutinen zu verwalten und zwischen ihnen zu wechseln, brauchen wir einen Scheduler, der die Aufgaben organisiert.

Eine einfache Methode dazu ist eine Warteschlange, in der Tasks abgelegt und nacheinander abgearbeitet werden. Im Scheduler laufen Tasks, die jeweils einen Zustand mit sich tragen. Sie werden der Reihe nach ausgeführt und pausieren mit yield oder await, sodass die Kontrolle zum Scheduler zurückkehrt und andere Tasks ausgeführt werden können. Ist ein Task beendet, wird er aus der Warteschlange entfernt. Diese Art von Steuerung ermöglicht es, mehrere Operationen scheinbar parallel auszuführen, ohne dass mehrere Threads benötigt werden.

Allerdings reicht das noch nicht aus, um wirklich asynchrone Funktionen effizient umzusetzen. Echte asynchrone Operationen benötigen eine Möglichkeit, auf Ergebnisse zu warten, die möglicherweise von außen oder einer anderen Quelle kommen, etwa das Lesen von Daten aus dem Netzwerk oder das Warten auf eine Zeitverzögerung. Hier kommen sogenannte Futures ins Spiel. Ein Future repräsentiert ein Ergebnis, das zu einem späteren Zeitpunkt verfügbar sein wird. Der Scheduler pausiert dann eine Coroutine, wenn sie auf ein Future wartet, und setzt sie erst fort, wenn das Future fertig ist und das Ergebnis vorliegt.

Die Implementierung eines Futures umfasst einen Mechanismus, der periodisch überprüft, ob die Operation abgeschlossen ist. Ist das der Fall, wird der auf das Future wartende Task mit dem Ergebnis wieder in die Ausführung aufgenommen. Dieser Polling-Mechanismus wird unterstützt durch Callbacks, die aktiviert werden, sobald das Future fertig ist. Somit ist der Scheduler in der Lage, Tasks nahtlos an den Stellen zu pausieren und fortzusetzen, an denen auf externe Ereignisse gewartet wird. Um das Ganze noch nutzerfreundlicher zu gestalten, wurden in Python die async- und await-Schlüsselwörter eingeführt.

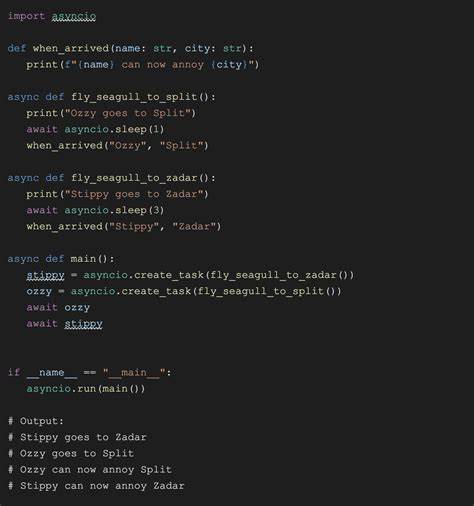

Diese sind syntaktischer Zucker und basieren intern auf den gewohnten Generator- und Future-Konzepten, bieten aber eine klarere und intuitivere Syntax zur Beschreibung asynchroner Programmierung. Das macht die Entwicklung von asynchronem Code nicht nur eleganter, sondern minimiert auch Fehler, da der Interpreter besser zwischen normalen Generatoren und Coroutinen unterscheiden kann. Unsere benutzerdefinierte Future-Klasse kann daher durch Implementierung der __await__-Methode dafür sorgen, dass sie await-kompatibel wird und somit vom Python-Interpreter nahtlos in async/await-Strukturen eingebunden werden kann. Auf diese Weise entsteht ein eigenes kleines Ökosystem, das exakt die Funktionsweise von Asyncio reproduziert, allerdings mit dem Vorteil, dass der Programmierer jeden Schritt nachvollziehen und verstehen kann. Ein sehr anschauliches Beispiel für den praktischen Einsatz zeigt sich beim Implementieren eines nicht-blockierenden Sleep.

Während ein normaler Zeitverzug in Python den ganzen Prozess blockieren und somit andere Tasks aufhalten würde, setzten wir eine Sleep-Klasse als Future ein, die nach Ablauf der Zeit ein Signal gibt und die jeweilige Coroutine fortsetzt. Dabei überwachen wir den aktuellen Zeitpunkt und ermitteln, ob die Wartezeit verstrichen ist, um das Future als „erledigt“ zu markieren. Der Scheduler sorgt dann dafür, dass andere Tasks während der Wartezeit ausgeführt werden, was zu einem reaktiven und effizienten Ablauf führt. Der bisherige Aufbau lässt sich schließlich noch erweitern, um reale Eingabe-/Ausgabeoperationen in unser Framework einzubinden. Die Herausforderung besteht hier darin, nicht blockierende I/O-Operationen durchzuführen, etwa Netzwerksockets, die auf neue Daten oder Verbindungen warten.

Die Python-Standardbibliothek liefert hierfür das Modul selectors, das eine Schnittstelle zu den Betriebssystem-Funktionen bereitstellt, über die man beobachten kann, wann ein Socket bereit für Lese- oder Schreiboperationen ist. Durch das Registrieren eines Sockets beim Selector und periodisches Abfragen ohne Blockierung kann unser Future feststellen, wann ein Ereignis eingetreten ist, und die entsprechende Coroutine wieder aufnehmen. Beispiele hierfür sind AcceptSocket, das auf neue eingehende Verbindungen wartet, und ReadSocket, das Daten von einem Socket liest. Diese Futures integrieren sich nahtlos in unseren Scheduler und ermöglichen dadurch eine vollwertige asynchrone Netzwerkanwendung. Der Höhepunkt dieser Implementierung ist ein asynchroner Echo-Server, der völlig ohne Threads oder Prozesse auskommt und dennoch mehrere Clients gleichzeitig bedienen kann.

Der Server akzeptiert neue Verbindungen durch Await auf AcceptSocket und startet für jeden Client eine neue Coroutine, die Daten vom Client liest und sofort wieder zurücksendet. Alle Tasks laufen über unseren selbstgeschriebenen Scheduler, der die Steuerung effizient verteilt und dabei die Wartezeiten komplett überbrückt. Die Erkenntnis aus diesem Projekt ist fundamental: Asyncio basiert auf einfachen, aber mächtigen Konzepten wie Generatoren, Koroutinen, Futures und einem Event Loop, der die Ausführung kooperativ an Tasks übergibt. Der Schlüssel liegt im bewussten Pausieren und Fortsetzen von Funktionen sowie der engen Verzahnung mit dem Betriebssystem, das die eigentliche Arbeit übernimmt und mit Ereignissen den Scheduler informiert. Diese Klarheit erlaubt es, Asyncio nicht länger nur als Blackbox zu verwenden, sondern ein tiefes Verständnis für die Abläufe zu entwickeln, was insbesondere bei komplexeren Anwendungen mit Zeitüberschreitungen, Abbruchmechanismen oder Priorisierungen von Tasks von unschätzbarem Wert ist.

Das Verständnis auf Generator-Ebene schenkt jedem Entwickler die Freiheit und das Rüstzeug, eigene asynchrone Frameworks zu bauen oder bestehende besser zu optimieren. Abschließend bleibt zu sagen, dass Asyncio keine Magie ist, sondern eine brillante Komposition einfacher mechanischer Konzepte, die zusammen ein komplexes und flexibles System ergeben. Die Arbeit mit yield und send ist der Kern, der den scheinbar mysteriösen await zum Leben erweckt. Wer diese Basis kennt und versteht, verfügt über ein mächtiges Werkzeug, um hochperformante, asynchrone Programme in Python zu schreiben.