Das Thema Webdesign entwickelt sich ständig weiter – technische Neuerungen, veränderte Nutzergewohnheiten und neue Standards sorgen dafür, dass Entwickler und Betreiber von Webseiten regelmäßig Anpassungen und Experimente durchführen müssen. Doch nicht alle dieser Innovationen erweisen sich als dauerhaft erfolgreich oder sinnvoll. Der Begriff „Design Graveyard“ fasst jene gescheiterten Designansätze und Feature-Experimente zusammen, die ausprobiert, reflektiert und letztlich verworfen wurden. Besonders anschaulich wird dieser Prozess am Beispiel der Website Gwern.net, die über Jahre zahlreiche Designexperimente unternahm und deren Ergebnisse offen reflektiert wurden.

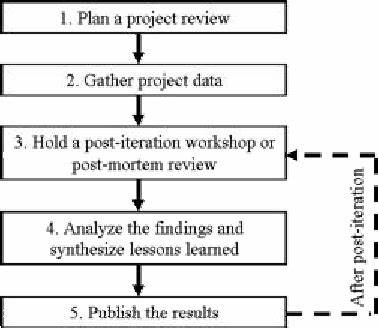

Diese „post-mortem analyses“ geben wertvolle Einblicke in die Herausforderungen der Webgestaltung und zeigen auf, warum manche technisch interessante Lösungen in der Praxis nicht funktionieren oder sogar kontraproduktiv sind. Eines der bekanntesten Probleme betrifft die Komplexität der Inhalte und wie diese für Nutzer verständlich gemacht werden können. Es zeigt sich immer wieder, dass komplexe Systeme oder Features oft nur eine begrenzte Akzeptanz finden. Die Erkenntnis, dass man Komplexität nicht direkt kommunizieren kann, sondern nur deren Bewusstsein erzeugen sollte, prägt viele Entscheidungen, die letztendlich zu einer Vereinfachung und Fokussierung auf klar nutzbare Features führen. Dieser Grundsatz steht am Anfang vieler Reflektionen im „Design Graveyard“.

Im technischen Bereich spielten unterschiedliche Werkzeuge für Content-Management und Versionierung eine große Rolle. Beispielsweise der Versuch, eine auf Gitit basierende Wiki-Struktur zu verwenden, wurde aufgrund der notwendigen Revisionstransparenz und des hierfür erforderlichen Aufwandes bald aufgegeben. Die Entscheidung, stattdessen statische Seiten mit einem simplen Generator wie Hakyll zu publizieren, erleichterte die Wartung und fokussierte die Arbeit auf das Wesentliche. Dies verdeutlicht ein zentrales Dilemma – technische Innovationen müssen immer auch praktikabel sein und dürfen nicht den Arbeitsfluss der Betreiber lähmen. In Sachen Benutzeroberfläche zeigt sich das Beispiel der sogenannten „jQuery Sausages Scrollbar“.

Die Idee, mit einem zusätzlichen Scrollbalken visuell die Struktur eines Artikels mit den Längen der Abschnitte abzubilden, klang vielversprechend. Leider erwies sich das Ergebnis in der Praxis als wenig intuitiv, weil zusätzliche UI-Elemente ohne klare Beschriftung beim Nutzer keinen Mehrwert stiften. Somit wurde das Feature wieder entfernt. Dieses Experiment macht deutlich, dass UI-Innovationen immer auf ihre Verständlichkeit geprüft werden müssen und dass vermeintliche Hilfen manchmal eher Verwirrung stiften. Lesefördernde Features wie der „Beeline Reader“, der durch farbliche Hervorhebung des Zeilenanfangs und -endes die Augenführung erleichtern soll, wurden ebenfalls getestet.

Trotz sinnvollem Ansatz führte eine A/B-Testung zu enttäuschenden Ergebnissen. Die Nutzer empfanden das Feature vielfach als störend, es bot keine messbaren Verbesserungen bei der Verweildauer und brachte Nachteile bei der Browserperformance mit sich. Das zeigt, dass Lesbarkeit und Barrierefreiheit mit einfachen Mitteln oft leichter und effizienter erreicht werden können, zum Beispiel durch eine gute Typografie oder clevere Textgestaltung, und dass experimentelle Tools sich erst bewähren müssen. Suchfunktionen auf statischen Webseiten stellen ein besonderes Problem dar. Das Beispiel eines Google Custom Search Engine (CSE) illustriert die Schwierigkeiten.

Obwohl CSE ursprünglich als praktische Lösung für die Websuche erschien, wurde es auf Gwern.net kaum genutzt und brachte teils fehlerhafte Suchergebnisse. Der Aufwand und die begrenzte Nutzerakzeptanz führten mehrfach zu dessen Entfernung und Wiederintegration. Schließlich ersetzte man CSE durch simpler gestaltete Suchoptionen, die direkt eine Google-Site-Suche in einem neuen Tab öffnen. Dies verdeutlicht die zentrale Erkenntnis, dass Technologien durchaus modern sein können, aber nur dann Sinn ergeben, wenn sie den tatsächlichen Gewohnheiten der Nutzer entsprechen.

Die Verwendung und Einbindung verschiedenster Schriftarten und Webfonts ist für die Webseite wichtig, um ein ansprechendes Schriftbild zu erzeugen. Der anfängliche Einsatz von Google Web Fonts erwies sich jedoch als problematisch, da dessen Ladezeiten die Seitenperformance negativ beeinflussten und Datenschutzbedenken aufwarfen. Der Aufbau von selbstgehosteten, subsetzten Fontversionen erwies sich als nachhaltiger und leistungsfähiger. Das zeigt, dass Abhängigkeiten von externen Providern mit Vorsicht betrachtet werden sollten und Selbstverwaltung in vielen Fällen profitabler ist. Die typografische Gestaltung von Dokumenten wurde durch Experimente mit Features wie „smallcaps“ und „rubrication“ getestet.

Automatisches Hervorheben von Akronymen mittels Smallcaps konnte zwar die Lesbarkeit vereinfachen, führte in der Praxis aber zu Performanceeinbußen und erhöhter Komplexität bei der Pflege des Quellcodes. Rubrikation, also der gezielte Einsatz von roter Farbe zur typografischen Hervorhebung, wurde als optisch ansprechend erkannt, jedoch im Gesamtzusammenhang als unpassend empfunden. Dies illustriert den schwierigen Spagat zwischen Schönheit, Lesbarkeit und Wartbarkeit. Ein besonders umfangreiches Kapitel im Gwern.net-Experimentierfeld sind „Popup-Anmerkungen“ und „Tooltipps“.

Statt simpler, statischer Tooltips wurden dynamische, interaktive Popups entworfen, die umfangreiche Zusatzinformationen, Quellenangaben und Kontext bieten können. Hier zeigte sich, wie wichtig es ist, eine Balance zwischen Performance, Benutzerfreundlichkeit und Archivierbarkeit zu finden. Zahlreiche Versionen wurden iteriert, u.a. mit rekursiver Einbindung von Anmerkungen und der Nutzung von Shadow DOM zur Performancesteigerung.

Trotz der hohen technischen Hürde ermöglicht dieses System eine innovative Hypertext-Erfahrung, die die Grenzen des Web-Leseerlebnisses neu definiert. Widrigkeiten brachte auch das Bemühen um optimierte Bildgrößen für unterschiedliche Endgeräte mit sich. Das HTML-Attribut „srcset“ sollte es ermöglichen, automatisch kleinere Bilder für mobile Geräte zu liefern und somit Ladezeiten zu reduzieren. Dieser Ansatz wurde jedoch von Browsern inkonsequent umgesetzt und ließ sich in der Praxis nur unzuverlässig realisieren. Die Enttäuschung führte letztlich zu einer Aufgabe des Systems.

Dies unterstreicht, wie wichtig eine funktionierende Browserunterstützung und eine einfache Wartbarkeit für Webstandards sind. Auch soziale und communityorientierte Features wie das Einbinden von Kommentarsystemen wurden hinterfragt. Das Beispiel Disqus zeigt, dass externe Plattformen zwar initial attraktiv sind, langfristig aber durch Leistungseinbußen, Inkonsistenzen bei Bedienung und den Rückgang der aktiven Nutzerbasis unattraktiv werden können. Die Verschiebung des Diskurses in soziale Medien hat die Bedeutung klassischer Blog-Kommentare deutlich verringert und deren technische Integration mit dynamischen Webseiten erschwert. Ein weiterer Aspekt war die Komplexität von URLs und deren Lesbarkeit, vor allem im Hinblick auf SEO und Nutzerfreundlichkeit.

Längere URLs mit Großbuchstaben, Leerzeichen oder www-Subdomains erwiesen sich als schwierig und wurden schrittweise zu kürzeren, kleingeschriebenen und „einfacheren“ Versionen geändert. Diese Umstrukturierungen verlangen zwar initial großen Aufwand für Backward-Kompatibilität, helfen aber langfristig, die Nutzererfahrung zu verbessern und Suchmaschinenoptimierung zu stärken. Ebenso wurden klassische Features wie Breadcrumbs kritisch betrachtet. Weil moderne Websites kaum noch starre Hierarchien abbilden und Nutzer oft individuelle Lesewege verfolgen, sind herkömmliche Breadcrumb-Navigationen wenig sinnvoll. Stattdessen wird über alternative Ansätze nachgedacht, wie z.

B. personalisierte „Browsing History“ Sektionen, die das Lesen von Popups und Links innerhalb einer Seite nachvollziehbar machen. Die Idee ist, Nutzer dabei zu unterstützen, ihren Verlauf zu speichern und leichter zu bearbeiten – eine Antwort auf das Problem der Informationsflut. Nicht zuletzt war auch das Design von Interviews und ähnlichen Gesprächsformaten ein Experimentierfeld. Wie präsentiert man abwechslungsreiche Sprecherwechsel, Themenblöcke und komplexe Diskussionsstrukturen auf einer Website übersichtlich und zugleich leicht bearbeitbar? Die Lösung wurde in einer feingliedrigen, zweistufigen Listenstruktur mit cleverer CSS- und JS-Ansteuerung gefunden, die die Lesbarkeit verbessert und es ermöglicht, Inhalte zu skimming und dennoch das Gesprächsgefüge klar abzubilden.

All diese Beispiele aus dem „Design Graveyard“ zeigen eines sehr klar: Im Webdesign zählen nicht nur technische Möglichkeiten und theoretisch schöne Lösungen, sondern vor allem praktische Nutzerfreundlichkeit, Wartungsfreundlichkeit und Performance. Manche innovative Features scheitern, weil sie die Nutzer überfordern, die Technik nicht stabil läuft, oder der Aufwand für Pflege und Kompatibilität zu groß wird. Für Webentwickler und Content Creator bietet die Analyse dieser Experimente eine wertvolle Wissensquelle. Rückschläge müssen nicht als Misserfolge betrachtet werden, sondern als essentielle Lernerfahrungen auf dem Weg zu besser gestalteten und benutzbaren Webseiten. Sie fördern ein reflektiertes Vorgehen, bei dem Neuerungen zunächst im Kleinen getestet werden, bevor sie umfassend ausgerollt werden – und sie zeigen, wie wichtig es ist, Nutzerverhalten genau zu beobachten und zu analysieren.

Die Zukunft des Webdesigns wird daher immer mehr von diesem iterativen Prozess geprägt sein: Experimentieren, Auswerten, Verbessern und gegebenenfalls Wiederverwerfen. Nur so können innovative und zugleich alltagstaugliche Lösungen entstehen, die den Ansprüchen der Nutzer gerecht werden und zugleich technisch sauber, performant und wartbar bleiben. Das „Design Graveyard“-Konzept liefert dabei eine wertvolle Orientierungshilfe. Jeder Webentwickler sollte sich bewusst sein, dass nicht jede Idee zum Erfolg führt, jedoch gerade das ehrliche Aufarbeiten von Fehlversuchen den nachhaltigen Fortschritt sichert. Das hilft nicht nur, eigene Projekte besser zu gestalten, sondern auch, externe Innovationen kritisch einzuordnen und anzupassen.

In Summe zeigt die Auswertung gescheiterter Webdesign-Experimente, dass die beste Webgestaltung nicht aus dem Vermeiden von Fehlern besteht, sondern aus dem Lernen aus ihnen. Wie im echten „Friedhof der Designs“ ruhen dort weniger Niederlagen als dazukommende, wertvolle Erfahrungen – das Fundament für Webseiten, die wirklich funktionieren und begeistern.