Die Welt der Künstlichen Intelligenz entwickelt sich rasant weiter, und mit ihr auch die verschiedenen Werkzeuge und Frameworks, die für die Modellierung und Verarbeitung von Daten genutzt werden. Eines der innovativen Konzepte, das in jüngster Zeit Aufsehen erregt hat, ist Flash Linear Attention. Dieses Verfahren galt als vielversprechend bei der Beschleunigung von Modellen und der effizienten Handhabung von Sequenzen. Doch kürzlich wurde bekannt gegeben, dass Flash Linear Attention keine Unterstützung mehr für die RWKV-Serie bietet. Diese Entscheidung wirft viele Fragen auf: Warum wurde die Unterstützung eingestellt? Was bedeutet das für Entwickler, die die RWKV-Serie nutzen? Und wie wirkt sich dies auf die Zukunft der KI-Entwicklung aus? Im Folgenden werden diese Fragen ausführlich beantwortet und die Hintergründe der Entscheidung beleuchtet.

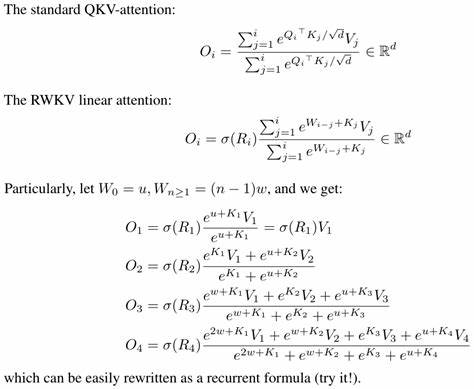

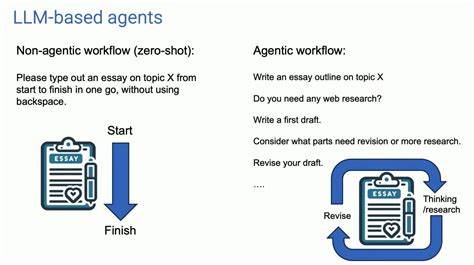

Flash Linear Attention war ursprünglich entwickelt worden, um die Effizienz von Attention-Mechanismen in neuronalen Netzen zu verbessern. Attention ist ein zentraler Bestandteil vieler moderner Modelle, insbesondere solcher, die auf Transformer-Architekturen basieren. Dabei steht die Möglichkeit, die Rechenzeit und den Speicherverbrauch drastisch zu senken, im Vordergrund, ohne die Genauigkeit oder Leistungsfähigkeit wesentlich zu beeinträchtigen. Gerade im Bereich der sequentiellen Datenverarbeitung, wie bei Sprachmodellen oder Zeitreihenanalysen, bietet Flash Linear Attention Vorteile gegenüber herkömmlichen Methoden. Die RWKV-Serie, eine Reihe von neuronalen Netzwerkmodellen, setzte ebenfalls auf diese Technologie, um die Effizienz ihrer Modelle zu steigern.

RWKV stand für eine innovative Alternativarchitektur zu herkömmlichen Transformer-basierten Modellen und erlangte insbesondere in der KI-Community durch seine Fähigkeiten Aufmerksamkeit. Die Kombination mit Flash Linear Attention ermöglichte es, die Vorteile beider Technologien zu nutzen: die Flexibilität und Leistungsfähigkeit der RWKV-Modelle und die Effizienzsteigerung durch Flash Linear Attention. Doch trotz dieser vielversprechenden Symbiose wurde die Unterstützung von Flash Linear Attention für die RWKV-Serie eingestellt. Die Entscheidung basiert auf mehreren Faktoren. Zum einen hat sich die Entwicklung von Flash Linear Attention in eine Richtung bewegt, die nicht mehr vollständig mit den Anforderungen oder der Architektur der RWKV-Modelle kompatibel ist.

Technologische Weiterentwicklungen und ein stärkerer Fokus auf andere Anwendungsbereiche führten dazu, dass die bisherigen Implementierungen und Optimierungen für RWKV nicht mehr gepflegt oder aktualisiert wurden. Ein weiterer wichtiger Aspekt ist die zunehmende Diversifizierung der Anforderungen und Modelle im Bereich der KI. Die Entwickler von Flash Linear Attention mussten Prioritäten setzen und entschieden sich, Ressourcen verstärkt auf Frameworks und Modelle zu konzentrieren, die eine größere Nutzerbasis oder einen expansiveren Anwendungsbereich aufweisen. Die RWKV-Serie, trotz ihrer Innovation, stellte einen relativ kleinen Teil des Gesamt-Ökosystems dar, was wirtschaftlich und technisch eine begrenzte Perspektive bot. Auch die Komplexität der Integration spielt eine Rolle.

Flash Linear Attention erfordert eine enge Verzahnung mit der jeweiligen Modellarchitektur, um Höchstleistungen zu erzielen. Mit Veränderungen in der RWKV-Architektur und deren Weiterentwicklung stieg der Aufwand für die Kompatibilität stetig, sodass die Pflege dieser Schnittstelle immer aufwendiger wurde. In Anbetracht begrenzter Ressourcen und anderer Prioritäten war die Einstellung der Unterstützung eine logische Konsequenz. Die Folgen dieser Entscheidung sind für Entwickler und Nutzer der RWKV-Serie spürbar. Wer bisher auf Flash Linear Attention setzte, um die Effizienz seiner Modelle zu steigern, steht nun vor der Herausforderung, alternative Lösungen zu finden.

Das kann bedeuten, auf andere Attention-Mechanismen oder Optimierungsmethoden umzusteigen oder eigene Anpassungen vorzunehmen, um die Performance nicht zu verlieren. Glücklicherweise ist die KI-Community dynamisch und vielfältig, sodass es eine Reihe von Ansätzen gibt, um ähnliche Ziele zu erreichen. Für die Entwickler der RWKV-Serie könnte dies auch eine Gelegenheit sein, eigene Innovationen im Bereich der Attention-Mechanismen zu forcieren. Statt auf externe Tools angewiesen zu sein, entstehen oft die besten Lösungen dann, wenn die Technologie speziell auf die Eigenheiten des Modells zugeschnitten wird. Gleichzeitig bleibt abzuwarten, wie sich Flash Linear Attention in anderen Bereichen weiterentwickeln und welche neuen Partnerschaften oder Kombinationen künftig entstehen.

Aus sicht der KI-Branche verdeutlicht der Verlust der Unterstützung für RWKV durch Flash Linear Attention ein grundlegendes Spannungsfeld zwischen Innovation, Ressourcenallokation und Kompatibilität. Während die Nachfrage nach effizienten und leistungsfähigen Modellen wächst, müssen Entwicklerteams immer wieder Entscheidungen treffen, welche Technologien sie aktiv unterstützen und weiterentwickeln. Diese Entscheidungen beeinflussen nicht nur die technische Landschaft, sondern auch die strategische Ausrichtung der Forschung und Entwicklung in der Künstlichen Intelligenz. Abschließend lässt sich festhalten, dass die Einstellung der Unterstützung von Flash Linear Attention für die RWKV-Serie ein bedeutsamer Schritt ist, der einerseits Herausforderungen birgt, andererseits aber auch Chancen eröffnet. Nutzer der RWKV-Modelle sollten sich darauf einstellen, ihre Strategien im Umgang mit Attention-Mechanismen zu überdenken und gegebenenfalls neue Wege zu beschreiten.

Gleichzeitig bleibt die Entwicklung rund um Flash Linear Attention spannend, und es ist nicht auszuschließen, dass zukünftig neue Fortschritte oder alternative Frameworks entstehen, die wiederum neue Möglichkeiten bieten. Die KI-Landschaft ist dynamisch und verändert sich ständig. Das Beispiel von Flash Linear Attention und der RWKV-Serie zeigt, wie wichtig es für Entwickler und Nutzer ist, flexibel zu bleiben und offen für Neuerungen zu sein. Die Zukunft bringt zweifellos weitere Innovationen, und nur wer sich kontinuierlich anpasst und weiterentwickelt, wird langfristig erfolgreich sein in dem immer wettbewerbsintensiveren Umfeld der Künstlichen Intelligenz.