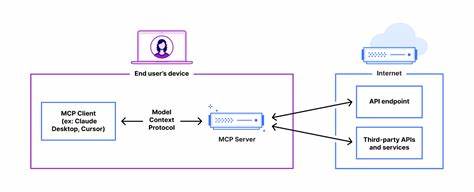

Das Deployen von Remote MCP Servern ist heute ein essenzieller Bestandteil moderner KI-Infrastrukturen. MCP, das Model Context Protocol, ermöglicht es, KI-Modelle effektiv zu verbinden und Anwendungen mit kontextbasierten Datenflüssen zu versorgen. Während der Protokollstandard sich noch in der Weiterentwicklung befindet, schafft die Remote-Bereitstellung von MCP Servern zahlreiche Vorteile für Teams und Unternehmen, die skalierbare und sichere KI-Lösungen umsetzen möchten. Ursprünglich liefen MCP Server hauptsächlich lokal auf Entwickler-Rechnern und kommunizierten via Standard-Ein-/Ausgabe mit MCP Clients. Diese Arbeitsweise ist für einzelne Entwickler oder begrenzte Testumgebungen ausreichend, stößt jedoch schnell an Grenzen, wenn es um Teamkoordination, Versionsmanagement und zentrale Sicherheitsrichtlinien geht.

Die Möglichkeit, MCP Server remote zu hosten, eröffnet hier völlig neue Perspektiven. Der Transportmechanismus ist zentral für das Protokoll. Während frühe MCP Implementierungen häufig lokale Verbindungen oder einfache HTTP Nutzung beinhalteten, haben Fortschritte wie der neue „streamable HTTP“ Transport nach dem Update im März 2025 den Weg zu performanteren und zuverlässigen Kommunikationskanälen geebnet. Im Kern basiert dieser Transport auf HTTP und Server-Sent Events (SSE), die eine latenzarme und beständige Datenübertragung ermöglichen. Dabei wird vermieden, komplexe Upgrades zu WebSocket-Verbindungen vorzunehmen, was die Implementierung und Wartung vereinfacht.

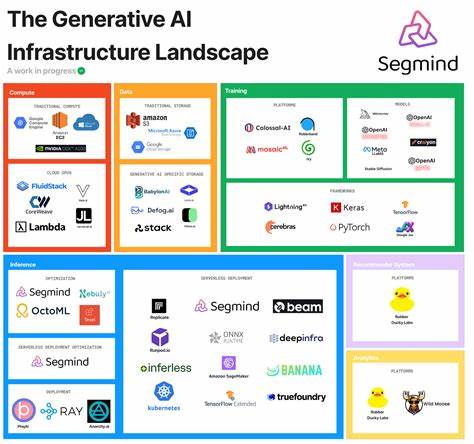

Ein wesentliches Argument für Remote MCP Server ergibt sich aus der zentrale Verfügbarkeit und Konsistenz. Teams greifen auf eine durchgängig erreichbare Instanz zu, die den gleichen Code, die gleichen Ressourcen und Zugriffskontrollen bereitstellt. Dies erhöht nicht nur die Effizienz bei der Zusammenarbeit, sondern schützt auch sensible Informationen wie API-Schlüssel und Authentifizierungsdaten, die sonst lokal und mit weniger Schutz gespeichert wären. Bei der Auswahl des geeigneten Hosting-Modells spielen verschiedene Faktoren eine Rolle. Der Einsatz von Cloudflare Workers ist beispielsweise für Projekte sinnvoll, die eine schnelle, serverlose und global skalierbare Lösung benötigen.

Dieser Ansatz besticht durch minimalistischen Wartungsaufwand und eingebaute Sicherheitsfunktionen wie HTTPS und OAuth-Integration. Allerdings existieren technische Limitationen, zum Beispiel beim CPU-Zeitbudget oder der Beschränkung auf keine nativen Binaries. Alternativ bieten traditionelle Cloud-VMs mehr Freiheiten, insbesondere bei Netzwerk- und Systemkonfigurationen. Durch selbstverwaltete virtuelle Maschinen kann man beispielsweise komplexe SSE-Streams betreiben, erfordert aber auch ein höheres Maß an Monitoring und Patching. Diese Variante empfiehlt sich besonders, wenn Anwendungsfälle intensive Datenzugriffe oder besondere Anpassungen erfordern.

Containerbasierte Deployment-Lösungen mit Docker oder Kubernetes punkten durch starke Isolation, Skalierbarkeit und automatisierte Rollouts. Sie eignen sich für größere Teams oder Dienstleister, die MCP Server als Produkt für zahlreiche Kunden anbieten wollen. Die Lernkurve ist hier zwar steiler, aber die langfristigen Vorteile in Bezug auf Wiederholbarkeit und Betriebssicherheit sind erheblich. Für Unternehmen mit strengen Compliance-Anforderungen oder interner Datenhaltung ist die On-Premises-Bereitstellung eine optimale Wahl. Durch die Anbindung mittels Cloudflare Tunnel und Zero Trust Access lässt sich der lokale MCP Server sicher aus dem Unternehmensnetzwerk heraus erreichbar machen, ohne Firewall-Ports offenlegen oder VPN-Komplexitäten managen zu müssen.

Diese Kombination gewährleistet, dass nur autorisierte Nutzer auf den Server zugreifen können und Daten in der eigenen Infrastruktur verbleiben. Die Einrichtung eines Remote MCP Servers beginnt meist mit ausgewählten Templates oder Beispielen. Die Sentry MCP Server Implementation gilt dabei als guter Einstieg, da sie OAuth-basiertes Authentifizierungsmanagement integriert und mit Cloudflare Workers leicht anpassbar ist. Die erforderlichen Schritte reichen vom Klonen des Repositorys über die Installation der Abhängigkeiten bis hin zum Einrichten von Umgebungsvariablen und dem Deployment via Wrangler, dem Cloudflare CLI Tool. Die korrekte Konfiguration von OAuth ist besonders wichtig, um sichere Zugriffe zu gewährleisten.

Sowohl der MCP Server als auch die Clients, etwa das MCP Inspector Tool, agieren in einem kontrollierten Token-Austausch, der durch Redirect-URIs und Berechtigungsbereiche (Scopes) abgesichert wird. Dieses Vorgehen erlaubt es, Drittservices wie Sentry in den Workflow zu integrieren, gleichzeitig aber stets nur autorisierten Anwendungen Zugriff zu gewähren. Neben Cloud-Deployments gewinnen Lösungen für das lokale Hosting dank Datenschutz und Performance ebenfalls an Bedeutung. Hier ist die Kombination aus Docker-Containerisierung und Cloudflare Tunnel wegweisend. Der Tunnel schafft eine verschlüsselte Verbindung zur Cloudflare-Edge, wodurch die interne Serverumgebung geschützt bleibt, während Anwender weltweit sicher darauf zugreifen können.

Die Integration von Cloudflare Zero Trust Access ermöglicht es zudem, granulare Nutzerrichtlinien zu definieren und die Zugriffe zentral zu steuern. Durch die Nutzung von Cloudflare Warp lassen sich Geräte zusätzlich in das Zero Trust Netzwerk einbinden, was eine nahtlose Authentifizierung und Verbindung unter Beibehaltung hoher Sicherheit garantiert. Diese Flexibilität macht On-Premises-Deployments vergleichbar einfach nutzbar wie serverlose Alternativen. Beim Vergleich der Hosting-Modelle müssen auch wirtschaftliche Faktoren berücksichtigt werden. Cloudflare Workers operieren nach einem Pay-per-Request Modell, das insbesondere bei niedriger Nutzung kosteneffizient ist.

Hingegen entstehen bei On-Premises Deployments fixe Infrastrukturkosten, die sich aber mit wachsenden Nutzungszahlen amortisieren können. Zudem bewerten Teams die Wartungsintensität unterschiedlich: Serverlose Optionen minimieren den Administrationsaufwand, während eigene Infrastruktur kontinuierliche Überwachung und Betrieb verlangt. Ein zentrales Merkmal bei allen Varianten ist die exakte Einhaltung der MCP Spezifikation. Unabhängig von Transportmechanismus oder Hosting-Umgebung kommunizieren Clients und Server über das gleiche JSON-RPC 2.0 basierte Protokoll.

Diese Standardisierung garantiert Kompatibilität, erleichtert Updates und garantiert eine langfristige Investitionssicherheit. In weiteren experimentellen Deployment-Ansätzen spielen auch AWS Lambda oder Kubernetes eine Rolle. Während Lambda ähnliche Funktionen wie Cloudflare Workers bietet, stößt es aufgrund komplexerer Einrichtung und Problemen mit SSE an Grenzen. Kubernetes ist vor allem bei größeren, verteilten Systemen interessant, erfordert aber deutlich mehr Know-how und Ressourceneinsatz. Um Remote MCP Server erfolgreich zu deployen, ist die klare Definition der Zielanforderungen entscheidend.

Soll der Server schnell und wartungsarm zugänglich sein, bieten sich serverlose Modelle an. Für maximale Kontrolle, Zugang zu lokalen Ressourcen oder Einhaltung spezifischer Sicherheitsrichtlinien empfiehlt sich On-Premises Hosting mit Tunnel-Integration. Die Sicherheitsarchitektur muss dabei an erster Stelle stehen. Authentifizierung und Autorisierung, Verschlüsselung der Verbindung und das Zugriffsmanagement über Zero Trust Konzepte bilden das Fundament einer robusten Umgebung. Ärgernisse wie unerwünschter Zugriff oder Datenlecks werden so minimiert.