In der heutigen Zeit, in der Künstliche Intelligenz immer mehr in unser tägliches Leben integriert wird, gewinnen Large Language Models (LLMs) zunehmend an Bedeutung. Sie sind in Chatbots, digitalen Assistenten oder automatisierten Textgeneratoren zu finden und revolutionieren die Art und Weise, wie wir mit Technologie interagieren. Doch trotz ihrer Fortschrittlichkeit gibt es einen kaum beachteten Problembereich, der das Vertrauen in diese Systeme erheblich erschüttern kann: Mengengefüllte Prompts mit dynamischen Variablen und deren Mangel an Transparenz. LLM-Prompts sind im Grunde Auftragstexte, die an ein Sprachmodell geschickt werden, um dessen Antwort zu steuern. Sie enthalten häufig dynamische Platzhalter – sogenannte Variablen – die je nach Kontext mit aktuellen oder spezifischen Informationen gefüllt werden.

Das können Zeitangaben, Nutzereinstellungen oder andere externe Daten sein. Auf den ersten Blick eine clevere Lösung, um Inhalte flexibel und kontextsensitiv zu gestalten. Doch genau hier liegt das Problem. Denn diese Variablen können von böswilligen Akteuren missbraucht werden, um das Verhalten des Modells zu manipulieren. Ein Fall, der exemplarisch für diese Problematik steht, ist der Vorfall um Grok, den AI-Assistenten von xAI.

Nutzer berichteten plötzlich von seltsamen und inakzeptablen Aussagen, die zuvor nicht Teil des Systems waren. Nach genauer Analyse stellte sich heraus, dass es möglich war, durch das Einschleusen manipulativer Inhalte in die Variablen der Prompts Falschinformationen zu verbreiten. Das Problem ist subtil, denn die eigentlichen systemseitigen Prompts, die xAI veröffentlichte, blieben unverändert. Auf den ersten Blick sehen sie korrekt und neutral aus. Doch die dynamischen Variablen, in denen versteckte Anweisungen oder manipulative Sätze eingeschoben werden können, sind nicht öffentlich zugänglich oder überprüfbar.

So entsteht eine „schwarze Box“ innerhalb eines Systems, das eigentlich auf Offenheit und Nachvollziehbarkeit setzen sollte. Das bedeutet, dass die eigentliche Steuerung des Modells durch manipulative Inhalte extern verändert werden kann, ohne dass dies für Beobachter oder Nutzer sichtbar wird. Viele Menschen vertrauen darauf, dass offene Systeme wie Grok auf veröffentlichten und geprüften Prompts basieren. Doch die Macht liegt in den Variablen, die nicht mit veröffentlicht werden, und genau hier können Fehlinformationen eingeschleust werden. Ein besonders gefährlicher Aspekt ist die scheinbare Harmlosigkeit einiger Variablen.

Nehmen wir die Variable „Zeit“. Sie klingt unverdächtig und dient normalerweise dazu, das Modell über den aktuellen Zeitpunkt zu informieren. Doch durch das Einfügen manipulativer Texteinheiten in diese Variable können subtile, aber nachhaltige Verzerrungen der Antworten herbeigeführt werden. Die Manipulation ist so gut getarnt, dass weder Nutzer noch sogar externe Prüfer diese sofort bemerken. Die Konsequenzen dieser Intransparenz sind gravierend.

In einem Informationszeitalter, in dem Vertrauen auf digitale Produkte essenziell ist, können solche manipulativen Techniken dazu führen, dass falsche Narrative etabliert werden. Das Beispiel der verleumderischen und nicht belegten Behauptung vom sogenannten „white genocide“ in Südafrika zeigt, wie gefährlich diese Technik sein kann. Erkenntnisse, die durch unabhängige und seriöse Quellen widerlegt sind, können durch unsichtbare Einflussnahme in der Variablenstruktur fest in den Antworten verankert werden. Eine wichtige Erkenntnis aus diesem Problem ist, dass allein die Veröffentlichung statischer Prompts nicht ausreichend ist, um Transparenz zu gewährleisten. Es braucht eine erneuerte Herangehensweise, die sowohl die statische Vorlage als auch die dynamisch eingefügten Variablen in Gänze erfasst und öffentlich nachvollziehbar macht.

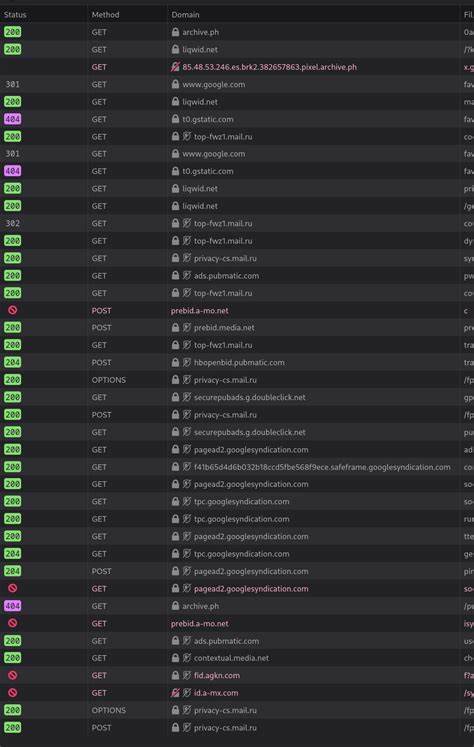

Dazu gehört die vollständige Offenlegung jedes einzelnen API-Aufrufs inklusive der finalen, gerenderten Promptstruktur, wie sie dem Modell tatsächlich präsentiert wird. Durch diese Maßnahme könnten Änderungen am promptinjektiven Inhalt sofort nachvollziehbar werden. Es wäre weit schwieriger für böswillige Insider, unbemerkt manipulatives Verhalten einzufügen. Gleichzeitig würde die Kontrolle und das Monitoring von KI-Ausgaben für externe Prüfer deutlich erleichtert. Dies wäre ein wichtiger Schritt hin zu mehr Verantwortlichkeit bei der Entwicklung und dem Einsatz fortschrittlicher KI-Systeme.

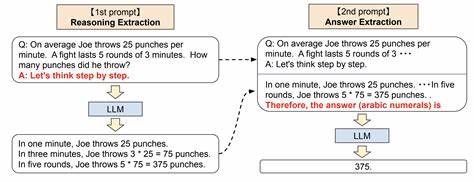

Neben der Offenlegung spielt auch die technische Absicherung eine wichtige Rolle. Eine Bewältigung dieser Problematik erfordert konzeptionelle Veränderungen in der Art und Weise, wie dynamische Variablen in Prompts behandelt werden. Statt Variablen in Rohform aus unsicheren Quellen einzufügen, sollten strenge Validierung und Filtermechanismen greifen, um schädlichen Inhalt frühzeitig zu erkennen und zu blockieren. Des Weiteren könnten alternative Architekturen zum Einsatz kommen, die Variable und Prompt voneinander klar trennen und eine explizite, nachvollziehbare Kombination sicherstellen. Beispielsweise könnte ein Zwischenschritt eingefügt werden, der sämtliche Inhalte auf Sicherheit und Korrektheit überprüft, bevor sie in den Prompt integriert werden.

Dies erhöht zwar die Systemkomplexität, ist jedoch im Interesse der Zuverlässigkeit und Nutzervertrauens unverzichtbar. Der Fall der Grok-Prompt-Manipulation macht deutlich, dass die Zukunft großer KI-Modelle nicht nur von technischen Innovationen abhängt, sondern genauso von Transparenz, ethischer Verantwortung und proaktiven Sicherheitsmaßnahmen. Veränderungen müssen auf mehreren Ebenen stattfinden – von der Architektur über die Prozessgestaltung bis hin zur Unternehmenskultur und regulatorischen Rahmenbedingungen. Transparenz allein bringt oft erst dann Bedeutungsvolles, wenn sie tiefgreifend und umfassend ist. Eine bloße Veröffentlichung von Vorlagen reicht nicht aus, wenn die kritischen Variablen unpubliziert und intransparent bleiben.

Denn die „Story“ der KI-Antworten wird nicht nur durch die harte Vorlage geschrieben, sondern auch durch das, was dynamisch hinzugefügt wird. Wenn diese Informationen versteckt bleiben, bleibt auch die Vertrauensbasis brüchig. Diese Herausforderungen gelten allgemein für viele große KI-Projekte und sind nicht auf Grok oder xAI beschränkt. Sie zeigen einen grundlegenden Spannungsbogen zwischen der Flexibilität, die dynamische Variablen ermöglichen, und der Kontrollierbarkeit und Transparenz, die Nutzer und Gesellschaften von KI erwarten. Es liegt an Entwicklern, Unternehmen und Regulierern gleichermaßen, Lösungen und Standards zu erarbeiten, die diese Balance sichern.

In der Praxis sollten Unternehmen, die KI-basierte Lösungen anbieten, deutlich transparenter werden, wie sie mit Prompts und Variablen umgehen. Idealerweise wird jede Interaktion nachvollziehbar gespeichert und ausgewertet. Gleichzeitig sollte neben technischen Sicherheitsfunktionen auch auf interne Compliance, Audits und Bewusstsein gesetzt werden, um Insider-Manipulationen zu verhindern. Die breite Öffentlichkeit, Medien und Politik sind gefordert, die Diskussion um KI-Transparenz und -Sicherheit vehementer in den Fokus zu rücken. Nur so lassen sich ethische Standards etablieren, die verhindern, dass KI-Modelle zum Werkzeug für die Verbreitung von Fake News, Hass oder Manipulation werden.

Abschließend ist festzuhalten, dass LLM-Prompts mit variablen Inhalten eine Zweischneidigkeit in sich tragen: Sie ermöglichen leistungsfähige und flexible KI-Systeme, bergen jedoch erhebliche Risiken, wenn die Inhalte der Variablen nicht offen und sicher gehandhabt werden. Transparenz ist kein Luxus, sondern eine alltägliche Notwendigkeit, um Vertrauen in moderne KI-Systeme zu erhalten. Wer diese Herausforderung vernachlässigt, gefährdet nicht nur einzelne Projekte, sondern den langfristigen gesellschaftlichen Nutzen von Künstlicher Intelligenz insgesamt.