In den letzten Jahren hat die Welt der künstlichen Intelligenz (KI) enorm an Bedeutung gewonnen. Immer mehr Unternehmen werben mit KI-gestützten Produkten und Dienstleistungen, um Kunden zu beeindrucken und Investoren zu gewinnen. Doch der Fall von Builder.ai sorgte insbesondere 2024 für Schlagzeilen – allerdings nicht wegen einer bahnbrechenden Innovation, sondern wegen des Vorwurfs, das Unternehmen habe angeblich mit 700 Ingenieuren in Indien vorgetäuscht, ein KI-Unternehmen zu sein. Dieses Narrativ ging viral und wurde von zahlreichen Medien und sozialen Netzwerken aufgegriffen.

Doch wie viel Wahrheit steckt tatsächlich hinter der Behauptung, dass Builder.ai KI nur vorgetäuscht habe? Um dieser Frage auf den Grund zu gehen, lohnt sich ein genauer Blick auf das Unternehmen selbst, seine Technologien und auch die Berichte ehemaliger Mitarbeiter. Builder.ai wurde als Softwareentwicklungsplattform gegründet, die es Kunden ermöglichen sollte, Apps und Websites einfach per KI-Unterstützung erstellen zu lassen. Insbesondere sollte die Plattform mit „Natasha“, einer KI-Entwicklungsassistenz, Kundenprojekte automatisieren und beschleunigen.

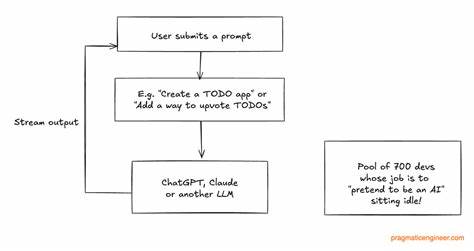

Dabei handelte es sich um ein System, das mithilfe von Sprachmodellen wie GPT und Claude Code generieren konnte, um die Softwareentwicklung zu erleichtern. Die Behauptung, Builder.ai habe 700 Entwickler in Indien beschäftigt, die lediglich als „menschliche KI“ agierten, klingt auf den ersten Blick erschreckend. Ein solcher Eingriff wäre nicht nur unethisch, sondern auch teuer und ineffizient – insbesondere in Zeiten, in denen leistungsfähige Large Language Models (LLMs) wie GPT-4 zur Verfügung stehen und automatisierte Programmierung ermöglichen. Insidergespräche mit ehemaligen Builder.

ai-Ingenieuren zeigen jedoch ein anderes Bild: Das Unternehmen nutzte tatsächlich eine KI-Plattform zur Codegenerierung, die von einem Kernteam von rund 15 Ingenieuren entwickelt wurde. Diese Kerngruppe arbeitete überwiegend in Großbritannien, unterstützt von kleineren Teams in Indien, um die KI-basierten Systeme zu optimieren und zu warten. Die rund 700 Entwickler, von denen oft die Rede ist, waren größtenteils über externe Dienstleister in verschiedenen Ländern verteilt, darunter auch Indien, aber eben auch Vietnam, Rumänien, Polen und die Ukraine. Diese Entwickler waren für unterschiedliche Kundenprojekte tätig und wurden nicht zur „Vortäuschung“ einer KI beschäftigt. Stattdessen handelte es sich um gewöhnliche Outsourcing-Entwickler, die mit herkömmlichen Methoden Software erstellten.

Die Rechnung, die wahrscheinlich zur Verwechslung führte, war, dass parallel zur KI-Plattform ein umfangreiches Netzwerk an Entwicklern agierte, um kundenspezifische Projekte umzusetzen. Ein wichtiges Missverständnis wächst oft daraus, dass KI-Systeme wie Natasha, die Code generieren können, nicht vollständig autonom arbeiten. Stattdessen fungieren sie als unterstützende Werkzeuge, die menschliche Entwickler entlasten. Das Team bei Builder.ai baute eine komplexe Infrastruktur auf, die den Entwicklungsprozess orchestrierte: Von der Annahme der Kundenidee über die Spezifikation der Anforderungen bis hin zur automatischen Erstellung und dem Testen des Codes.

Stimmt der generierte Code nicht vollständig, greifen Entwickler korrigierend ein. Dieser Mix aus KI und menschlicher Expertise ist heute eine gängige Praxis bei vielen Softwareunternehmen, die intelligente Automatisierung einsetzen wollen. Der Fokus auf interne Entwicklung und die gleichzeitige Beschäftigung eines großen Netzes an externen Entwicklern führte bei Builder.ai zu einem fragilen Geschäftsmodell. Statt sich auf das KI-System zur Codegenerierung zu konzentrieren, investierte das Unternehmen parallel in den Aufbau eigener Tools wie Builder Home, Builder Meet, Builder Tracker oder Builder Whiteboard, die teilweise bereits etablierte Marktprodukte nachahmten.

Dieser fehlende Fokus und das Zu-viel-auf-einmal machten es schwierig, die Effizienz zu steigern und die Umsätze wie prognostiziert zu erwirtschaften. Ein weiterer ausschlaggebender Faktor war der Umgang mit den externen Entwicklern: Aufgrund der großen Menge der ausgelagerten Arbeitskräfte und der Tätigkeit über diverse Dienstleister hinweg erschwerte es Builder.ai, die Arbeitszeiten und die Leistung der Entwickler einwandfrei zu kontrollieren. Interne Systeme zur Betrugserkennung wurden implementiert, um Abrechnungen abzugleichen und Manipulationen zu verhindern. Ehemalige Mitarbeiter berichteten von einer zweijährigen „Katze-und-Maus“-Situation, in der es schwierige Kontrollprobleme gab, die sich negativ auf das Unternehmensergebnis auswirkten.

Die dramatische Wende kam, als durch eine finanzielle Prüfung erhebliche Unstimmigkeiten aufgedeckt wurden. Die vorgelegten Umsatzzahlen mussten drastisch nach unten korrigiert werden. Aus ursprünglich prognostizierten 220 Millionen US-Dollar für das Jahr 2024 wurden etwa 55 Millionen, während die Einnahmen für 2023 ebenfalls um knapp 75 Prozent nach unten revidiert wurden. Die Kreditgeber zogen ihre Unterstützung zurück, und Investoren verloren das Vertrauen. Die Insolvenz von Builder.

ai wurde schließlich unausweichlich. Inmitten dieses Chaos wurde die Falschinformation, Builder.ai habe KI durch ein Heer von 700 Entwicklern in Indien bewusst vorgetäuscht, rasch verbreitet. Es handelte sich dabei keinesfalls um fundierte journalistische Recherche, sondern vielmehr um hitzige Spekulationen und unbestätigte Social-Media-Posts, die von manchen einflussreichen Persönlichkeiten aufgegriffen wurden. Das renommierte Finanzmagazin Financial Times konnte sogar die Quelle des viralen Threads auf eine Einzelperson zurückverfolgen, die keinerlei journalistische Erfahrung und Glaubwürdigkeit besitzt.

Diese verzerrte Darstellung trifft insbesondere die Ingenieurinnen und Ingenieure, die bei Builder.ai gearbeitet haben und ernsthafte Arbeit geleistet haben, um innovative KI-Lösungen zu entwickeln. Viele von ihnen äußerten Enttäuschung darüber, dass ihre Leistungen durch die Gerüchte ad absurdum geführt werden. Besonders schmerzlich ist diese Entwicklung, weil gerade im AI-Sektor technisches Know-how und Erfahrungen von hoher Qualität gefragt sind und Absolventen von Builder.ai als wertvolle Talente gelten.

Ein Blick auf die Technologie hinter Natasha offenbart zudem, dass Builder.ai durchaus auf dem zeitgemäßen Stand der Technik arbeitete. Die Codegenerierung erfolgte mit Hilfe moderner Large Language Models, und das Entwicklungsteam testete kontinuierlich verschiedene Modelle, um das beste Resultat für ihre Anwendungsfälle zu erzielen. Das Konzept, KI gestützte Entwicklerwerkzeuge mit einem menschlichen Team zu kombinieren, war und ist auch heute eine bewährte Methode, um Software effizient und fehlerarm zu produzieren. In der Welt der Softwareentwicklung kann man KI daher nicht einfach als „magische Lösung“ betrachten, die mühelos und vollkommen autonom eine komplette App erstellt.

Vielmehr handelt es sich bei hochwertigen KI-Systemen um unterstützende Ökosysteme, die menschliche Fähigkeiten ergänzen und repetitive Aufgaben automatisieren. Die Überhöhung oder Dämonisierung solcher Systeme entgegen den tatsächlichen Gegebenheiten führt zu falschen Erwartungen und unnötigem Misstrauen. Der Fall Builder.ai sollte also als Mahnung verstanden werden, Gerüchte kritisch zu hinterfragen und den Blick hinter die Schlagzeilen zu wagen. Unternehmerisches Scheitern, wie es Builder.

ai erlebt hat, ist häufig das Ergebnis eines komplexen Zusammenspiels von Faktoren: Trendhoppen, fehlende Fokussierung, Managementfehler und Marktbedingungen sind hier nur einige Schlüsselbegriffe. Einzelne Aspekte wie ein angebliches „Fake-KI“-Narrativ lenken dabei nur vom eigentlichen Kern ab. Künftige Talente im KI-Bereich können aus dem Fall Builder.ai lernen, wie wichtig es ist, sich einen Überblick zu verschaffen, echte technologische Innovationen zu verstehen und sich nicht von oberflächlichen Medienberichten beirren zu lassen. Das öffentliche Interesse an KI wächst weiter, was eine verantwortungsvolle Berichterstattung und eine differenzierte Betrachtung von Unternehmen und Technologien immer wichtiger macht.

Insgesamt lässt sich festhalten, dass Builder.ai kein Unternehmen war, das mit 700 Entwicklern eine vermeintliche KI vorgetäuscht hat. Hinter den Kulissen arbeiteten engagierte Ingenieure hart daran, eine KI-gestützte Softwareentwicklung möglich zu machen – ein Ziel, das auch heute vielerorts mit großem Aufwand verfolgt wird. Das Scheitern des Unternehmens hatte mehr mit internen Strukturen und Managemententscheidungen zu tun als mit bewusster Täuschung durch falsche KI-Versprechen. Der Mythos vom „Fake AI mit 700 Entwicklern“ wurde durch ungenaue Quellen entstand, verbreitete sich viral und schadet den ehrlichen Fachkräften, die an echten Innovationen und Produkten gearbeitet haben.

Wer die Komplexität von Softwareentwicklung mit KI begreift und die Umstände bei Builder.ai selbst betrachtet, wird erkennen, dass die Realität weit differenzierter und weniger sensationell war, als es die Überschriften glauben machen wollten. So wichtig es ist, Missstände aufzudecken, so sehr braucht die Technologiebranche umfassendes Verständnis und Fairness gegenüber denjenigen, die trotz widriger Umstände echten Wandel vorantreiben.