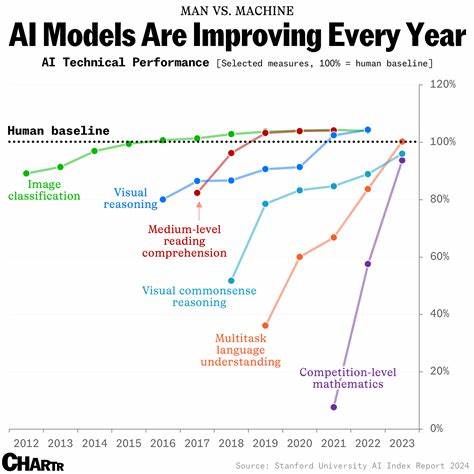

Die rasante Entwicklung Künstlicher Intelligenz bringt eine Vielzahl neuer Modelle und Ansätze hervor, die es zunehmend schwieriger machen, den Überblick zu behalten und die besten Optionen für konkrete Anwendungen zu finden. Besonders relevant ist die Frage, mit welchen Benchmarks und Kriterien man KI-Modelle zuverlässig bewerten kann, um fundierte Entscheidungen zu treffen und nicht nur auf Marketingversprechen oder subjektive Eindrücke zu vertrauen. Die Suche nach validen und alltagstauglichen Leistungsindikatoren gewinnt deshalb immer mehr an Bedeutung. Ein gängiger Ansatz zur Bewertung von KI-Modellen ist die Verwendung spezialisierter Benchmarks, die bestimmte Fähigkeiten oder Anwendungsszenarien abbilden. Zum Beispiel werden bei Sprachmodellen häufig Tests zu Textverständnis, Sprachgenerierung und Code-Erzeugung eingesetzt.

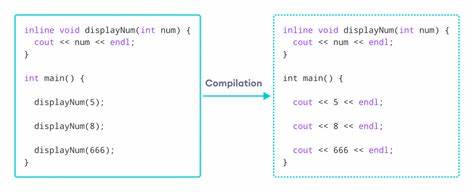

Ein bemerkenswertes Beispiel in diesem Bereich ist Aider’s Polyglot Benchmark, das insbesondere die Fähigkeiten von Modellen im Programmierkontext misst. Wer einen Eindruck gewinnen möchte, wie gut ein Modell bei der Codegenerierung und -vervollständigung abschneidet, findet hier wertvolle Anhaltspunkte, die über reine Textverarbeitung hinausgehen. Neben der Leistungsmessung durch Benchmarks spielt auch die Popularität und tatsächliche Nutzung der Modelle eine wichtige Rolle. Hierbei kann die Analyse von Nutzerstatistiken auf Plattformen wie OpenRouter helfen. Die Nutzerzahlen und Rankings geben oft indirekt Auskunft darüber, wie praxistauglich und vielseitig ein Modell im täglichen Einsatz ist.

Denn ein Modell, das häufig genutzt wird, ist in vielen Fällen auch ein Zeichen dafür, dass es echten Mehrwert bietet und sich gegenüber der Konkurrenz behaupten kann. Somit spiegelt die Beliebtheit eine Art realweltliche Bewertung wider, die rein technische Metriken manchmal nicht abbilden können. Ein weiterer wertvoller Wissensspeicher ist die Webseite LLM-Stats, die umfassende Daten und Visualisierungen zu verschiedenen Benchmark-Ergebnissen rund um Large Language Models (LLMs) bereitstellt. Hier können Interessierte unterschiedliche Modelle und ihre Leistungen in diversen Kategorien direkt vergleichen und so tiefere Einblicke in die jeweiligen Stärken und Schwächen gewinnen. Diese Ressourcen erweitern die Perspektive und ermöglichen es, die technischen Zahlen besser zu interpretieren und für die eigenen Anforderungen zu nutzen.

Trotz all dieser digitalen Ressourcen gibt es auch eine skeptische Haltung gegenüber Benchmarks. Einige Experten und Nutzer betonen, dass persönliche Erfahrungen mit den Modellen oft aussagekräftiger sind als standardisierte Tests. Gerade in der dynamischen Landschaft der KI-Modelle, in der sich die Algorithmen ständig weiterentwickeln und neue Versionen erscheinen, ist es hilfreich, selbst Hand anzulegen und die Modelle in realen Szenarien auszuprobieren. So kann man nicht nur die allgemeinen Fähigkeiten beurteilen, sondern auch feststellen, wie gut das Modell sich auf spezifische Aufgaben anpassen lässt und welchen Workflow es unterstützt. Der prominente Ansatz „einfach eines wählen und testen“ hat in der Community seine Befürworter.

Es wird argumentiert, dass die großen Anbieter wie OpenAI häufig mehrere Modelle mit unterschiedlichen Prioritäten wie Geschwindigkeit, Tiefgang oder Vielseitigkeit gleichzeitig anbieten. Ein pragmatischer Nutzer konzentriert sich darauf, ein Modell auszuwählen, das zum aktuellen Anwendungsfall passt, und sammelt so selbst die wichtigsten Eindrücke, ohne sich von der Vielzahl an Optionen überwältigen zu lassen. Dies steht im Kontrast zur detaillierten Benchmark-Orientierung, die vor allem bei tiefergehenden technischen Vergleichen sinnvoll ist. In den letzten Monaten hat sich gezeigt, dass es nicht immer massenhaft neue Modelle braucht, um relevante Vergleiche anzustellen. Die Einführung von fünf bahnbrechenden Modellen wie Claude 3.

7, OpenAI’s o1 und o3 Versionen, Grok 3 und Gemini 2.5 Pro hat der Community die Möglichkeit gegeben, konzentriert und intensiv zu evaluieren. Wer diese Auswahl manuell und mit verschiedenen Aufgaben getestet hat, gewinnt einen unmittelbaren Erlebniswert, der schwer durch Benchmarks ersetzbar ist. Dabei entstehen oft präzisere Einschätzungen zur tatsächlichen Einsatzreife und Leistungsfähigkeit der Systeme. Dies zeigt generell, dass der Bewertungsprozess sowohl aus standardisierten Leistungstests als auch direkter praktischer Erfahrung bestehen sollte.

Benchmarks liefern eine objektivierte Grundlage, während der reale Einsatz die individuelle Eignung für konkrete Bedürfnisse prüft. Wer beide Perspektiven kombiniert, erhält ein ausgewogenes Bild der aktuellen KI-Landschaft. Für Unternehmen und Entwickler empfiehlt sich daher ein mehrstufiger Bewertungsansatz. Zunächst ist das Studium einschlägiger Ranking-Seiten und Benchmark-Ergebnisse ratsam, um aussichtsreiche Kandidaten einzugrenzen. Im Anschluss sollten praktische Tests mit realen Aufgabenstellungen erfolgen, die die relevanten Funktionen und Performance-Kriterien abdecken.

Ideal ist es zudem, Communities und User-Feedback zu verfolgen, um aktuelle Entwicklungen und Schwachstellen frühzeitig zu erkennen. Eine weitere Herausforderung bei der Bewertung liegt in der Vielfalt der Einsatzgebiete. Ob Codeerstellung, Textgenerierung, Dialogführung oder Datenanalyse – jedes Anwendungsfeld stellt unterschiedliche Anforderungen an ein KI-Modell. Es gibt daher keine „One-Size-Fits-All“-Lösung, sondern nur eine individuelle Optimierung je nach Zielsetzung. Das bedeutet, dass Benchmarks immer auch im Kontext der spezifischen Nutzung interpretiert werden müssen, um die richtigen Schlüsse zu ziehen.

Die zunehmende Aufmerksamkeit auf Metriken wie Geschwindigkeit, Genauigkeit, Kontextverständnis und Robustheit spiegelt wider, dass Benutzer sowohl technische Exzellenz als auch praktische Alltagstauglichkeit erwarten. Auch Aspekte wie Sicherheit, Bias-Reduktion und Kosten-Effizienz fließen zunehmend in die Bewertung ein und gewinnen angesichts ethischer und wirtschaftlicher Überlegungen an Stellenwert. Schlussendlich ist die Orientierung am Nutzererlebnis und die direkte Anwendung entscheidend für den nachhaltigen Erfolg eines KI-Modells. Qualität zeigt sich nicht allein in Laborbedingungen, sondern im täglichen Einsatz und in der Fähigkeit, unterschiedliche Szenarien flexibel zu meistern. Die Kombination von Benchmarkanalysen, Nutzerstatistiken und praktischen Tests gibt den besten Rahmen, um zukunftssichere und leistungsstarke KI-Lösungen zu erkennen und auszuwählen.

In einer sich schnell wandelnden Technologiewelt bleibt die kontinuierliche Beobachtung und Anpassung der Bewertungsansätze essenziell. Die Tools und Metriken werden sich weiterentwickeln, doch die Verbindung von objektiven Daten und subjektiven Erfahrungen wird weiterhin der Schlüssel zu fundierten Entscheidungen bei der Auswahl von KI-Modellen bleiben.