Die Wahl der richtigen Datenbank ist für moderne Unternehmen von entscheidender Bedeutung. Mit wachsendem Umfang und steigenden Anforderungen an Performance, Skalierbarkeit und Kostenverwaltung stehen viele Organisationen vor der Frage, ob verteilte Datenbanksysteme wie CockroachDB oder traditionelle relationale Systeme wie Postgres besser geeignet sind. Seit Anfang 2022 nutzte das Unternehmen Motion CockroachDB für seine Datenhaltung. Obwohl CockroachDB mit nahtloser horizontaler Skalierung, hoher Verfügbarkeit und einer SQL-kompatiblen Schnittstelle viele Vorteile bietet, zeigte der Praxisbetrieb über zwei Jahre deutliche Schwächen, die letztlich zu einer Migration in Richtung Postgres führten. Ein zentraler Auslöser für den Wechsel war die Kostenentwicklung.

Bis 2024 hatte sich die CockroachDB-Rechnung auf mehrere hunderttausend Dollar jährlich verfünffacht – und das bei einer Nutzung, die hauptsächlich einfache transaktionale Abfragen in einer einzigen Region umfasste. Ohne die Nutzung der eigentlich geplanten Multi-Region-Fähigkeiten stellte sich die Frage, ob die teure verteilte Architektur tatsächlich notwendig war. Zusätzlich traten bei Migrationsprozessen mit dem von Motion eingesetzten Object-Relational-Mapper (ORM) Prisma immer wieder Timeouts auf, was manuelle Eingriffe erforderlich machte und die Entwicklerteams zu kurzfristigen Workarounds zwang. Diese Timeouts führten nicht nur zu langen Ausfallzeiten beim Deployment, sondern auch zu erheblichen Problemen bei Datenintegrations- und ETL-Prozessen. Das Unternehmen nutzte Airbyte als Connector, um Daten zu replizieren, stieß jedoch auf Funktionsstörungen wie Speicherlecks und dauerhafte Hänger.

Da die CockroachDB-Community und ihr Ökosystem für ETL-Anwendungen schwach ausgeprägt sind, konnte keine stabile Lösung bei der Datenmigration gefunden werden. Im Vergleich zu Postgres erzielte CockroachDB bei einigen komplexen Abfragen zwar eine schnellere Ausführung, allerdings handelte es sich dabei um Ausnahmen. In vielen praxisnahen Szenarien führte der von Prisma generierte komplexe und teilweise ineffiziente SQL-Code dazu, dass CockroachDB ganze Tabellen scannte und dadurch große Latenzen verursachte. Postgres hingegen bewies für einen Großteil der realen Arbeitslasten eine deutlich bessere Performance und zeigte sich für Entwickler einfacher zu handhaben. Auch im Bereich Nutzererfahrung und Betrieb überzeugte Postgres.

Technische Hürden wie das Abbrechen laufender Abfragen gestalteten sich bei CockroachDB aufwendig, da dafür direkte Eingriffe ins Management-Interface des verteilten Systems notwendig waren. Postgres bietet hier mit gängigen SQL-Clients eine direkte und unkomplizierte Möglichkeit, Aktionen abzubrechen, was vor allem in dringenden Situationen Zeit und Ressourcen spart. Ein weiterer entscheidender Punkt waren Verbindungsprobleme in CockroachDB-Setups bei Nutzung von VPCs (Virtual Private Clouds). Immer wieder kam es zu schwer nachvollziehbaren Ausfällen oder Nichterreichbarkeit des Datenservers, obwohl die Infrastruktur eigentlich stabil sein sollte. Diese Probleme traten in unterschiedlichsten Umgebungen auf, von lokalen Datenbanken bis hin zu Produktionssystemen, und konnten trotz intensiver Troubleshooting-Versuche nicht dauerhaft gelöst werden.

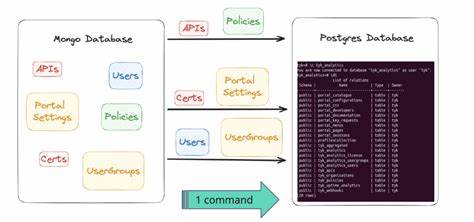

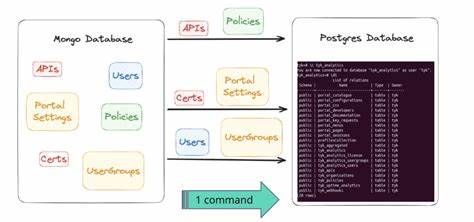

Postgres zeigte sich in dieser Hinsicht deutlich robuster und stabiler. Die Datenmigration an sich stellte eine große Herausforderung dar. Mit über 100 Millionen Zeilen in der größten Tabelle war keine einfache Übertragung möglich – herkömmliche ETL-Tools oder Connectoren hatten schlichtweg Limitierungen, besonders im Zusammenspiel von spezifischen Datenformaten wie JSON und Arrays. Daher entwickelte der Autor ein eigenes ETL-Skript unter Verwendung der Programmiersprache Bun. Dabei wurden Daten tabellenweise in CSV-Dateien exportiert, von jeweiligen Prozessen eingelesen und schließlich in die neue Postgres-Datenbank importiert.

Während der Testläufe traten jedoch Inkompatibilitäten in der Byte-Codierung einzelner Datentypen zwischen CockroachDB und Postgres zutage. Durch gezielte Datenumwandlung und Parsing-Strategien konnte eine vollständige Kompatibilität erreicht werden, sodass die bestehenden Daten auf Anwendungsebene identisch waren – ein entscheidender Schritt, um funktionale Ausfälle nach dem Umzug zu vermeiden. Die eigentliche Migration in der Produktion fand mit minimaler Downtime statt. Ein Großrechner mit 128 CPU-Kernen wurde zur Beschleunigung eingesetzt, zudem wurde das System vorübergehend in den Wartungsmodus versetzt. Unter diesen Bedingungen konnte die Übertragung aller Daten innerhalb von etwa 15 Minuten realisiert werden, während der komplette Vorgang inklusive Traffic-Anpassungen knapp eine Stunde dauerte.

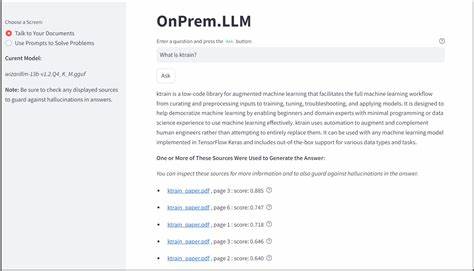

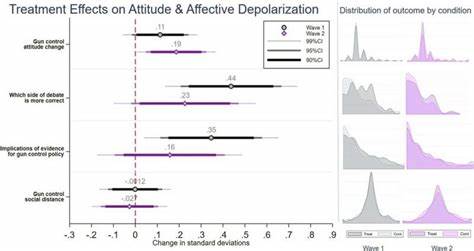

Wichtiger als Geschwindigkeit war dabei die Sicherheit, um Datenverluste oder inkonsistente Zustände zu verhindern. Nach der Migration zeigte sich schnell der Erfolg: Die aggregierte Anfrage-Latenz reduzierte sich um rund ein Drittel, was sich unmittelbar auf die Nutzererfahrung auswirkte. Mit dem umfassenden Ökosystem von Postgres-Tools wie PGAnalyze konnten in den folgenden Stunden weitere Performance-Engpässe identifiziert und optimiert werden. Dies führte zu zusätzlichen Effizienzgewinnen und stabileren Abläufen. Auch die wirtschaftliche Bilanz der Migration ist bemerkenswert.

Trotz einer konservativen Cluster-Bereitstellung lagen die Einsparungen bei über 110.000 US-Dollar jährlich, was im Kontext des erwarteten Wachstums im Traffic noch weiter an Bedeutung gewinnen dürfte. Die Reduzierung der Betriebskosten ohne Einbußen bei Ausfallsicherheit und Performance stellt somit einen klaren Vorteil dar. Aus technischer, betrieblicher und wirtschaftlicher Perspektive zeigt die Migration den Wert einer sorgfältigen Bewertung und Auswahl der Datenbankarchitektur. Verteilte Datenbanksysteme punkten in spezialisierten Einsatzszenarien, insbesondere wenn Multi-Region-Support und hohe Verfügbarkeit im Vordergrund stehen.

In vielen klassischen Anwendungsfällen mit lokal begrenzter Transaktionslast und pragmatischen Skalierungsansprüchen kann Postgres mit seiner stabilen Performance und umfangreichen Community schneller, kosteneffizienter und unkomplizierter punkten. Entscheidend für eine erfolgreiche Migration ist neben der reinen Datensicherheit auch das Handling von komplexen Datenmodellen, Optimierung der Abfragen und sorgfältiges Testing. Die enge Zusammenarbeit zwischen Entwicklerteams, Datenbankadministratoren und Support ist hier ein Erfolgsfaktor. Neben technischen Herausforderungen spielen auch Betriebsthemen wie Support-Erreichbarkeit, UI/UX und Netzwerkverfügbarkeit eine gewichtige Rolle. Abschließend lässt sich sagen, dass die Migration zu Postgres nicht nur ein rein technischer Schritt war, sondern eine bewusste strategische Weichenstellung.

Sie veranschaulicht, wie technische Innovatoren durch Engagement, Eigeninitiative und experimentelle Herangehensweise effiziente Lösungen für komplexe Infrastrukturthemen erarbeiten können. Gerade kleinere Teams oder Unternehmen profitieren von solchen Analysen und Erfahrungswerten immens, da eine zu frühe oder uninformierte Wahl hochspezialisierter Technologien oft mehr Last als Nutzen bringt. Für Unternehmen, die vor ähnlichen Entscheidungen stehen, empfiehlt es sich, den Ist-Zustand genau zu analysieren, Kosten und Nutzen realistisch abzuwägen und Migrationen als kontinuierlichen Verbesserungsprozess zu begreifen. Der Einsatz moderner ORM-Tools erleichtert Vergleiche und Testläufe, allerdings sollten die Eigenheiten des SQL-Codes dabei kritisch geprüft werden, um spätere Performance-Engpässe zu vermeiden. Investitionen in individuelle Migrationsskripte zahlen sich ebenfalls aus, wenn Standardtools an Grenzen stoßen.

Zukunftsorientiert stärkt die Nutzung von Postgres zudem den Zugang zu einem breit gefächerten Werkzeugkasten an Analysetools, Extensions und Community-getriebenen Innovationen. Durch diese Offenheit können Unternehmen ihre Dateninfrastruktur flexibel an wachsende Anforderungen anpassen, ohne auf proprietäre Systeme oder eingeschränkte Ökosysteme angewiesen zu sein. Letztlich ist die Erfahrung von Motion zu einer wertvollen Fallstudie geworden, die den Mut zeigt, etablierte Systeme zu hinterfragen und aktiv nach pragmatischen Lösungen zu suchen. Dieses Beispiel bietet Orientierung für Teams, die sich mit Skalierung, Migration und Kostenoptimierung auseinandersetzen – und zeigt, dass durch technische Sorgfalt und entschlossenes Handeln enorme Verbesserungen möglich sind.