In der heutigen digitalen Landschaft ist Datenmanagement ein entscheidender Erfolgsfaktor für Unternehmen aller Branchen und Größenordnungen. Die exponentiell wachsenden Datenmengen und die Vielfalt der Datentypen stellen herkömmliche Speicherlösungen vor immer größere Herausforderungen. Softwaredefinierte Objektspeicherung hat sich in diesem Kontext als zukunftsweisende Technologie etabliert, die durch Skalierbarkeit, Flexibilität und Cloud-Native-Fähigkeit überzeugt. Doch was genau verbirgt sich hinter softwaredefinierter Objektspeicherung, wie unterscheidet sie sich von anderen Speicherformen und welche Kriterien sollten Unternehmen bei der Auswahl berücksichtigen, um langfristig von ihrer Investition zu profitieren? Diese Fragen werden in diesem Leitfaden umfassend beantwortet. Objektspeicherung stellt eine spezielle Form der Datenspeicherung dar, bei der Daten als einzelne, unveränderliche Objekte abgelegt werden.

Jedes Objekt besteht aus den eigentlichen Dateneinheiten, Metadaten zur Beschreibung und einem einzigartigen Identifikator. Diese Struktur ermöglicht eine besonders effiziente und flexible Verwaltung großer Datenmengen ohne die Notwendigkeit einer hierarchischen Ablage wie bei Dateisystemen. Die Unterscheidung liegt darin, dass die Metadaten atomar mit dem Objekt gespeichert werden, was vor allem bei kleinen Objekten für eine herausragende Performance sorgt. Diese Art der Speicherung ist bestens geeignet für unstrukturierte Daten wie Bilder, Videos, Logs oder Zeitreihendaten, welche rund 80 Prozent der unternehmerischen Datenwelt ausmachen. Softwaredefinierte Objektspeicherung hebt das Konzept der Objektspeicherung auf ein neues Level, indem sie Hardwareunabhängigkeit und maximale Flexibilität kombiniert.

Im Gegensatz zu appliance-basierten Systemen, die an proprietäre Hardware gebunden sind, läuft softwaredefinierte Speicherlösung auf Standardhardware und lässt sich problemlos in Container- und Kubernetes-Umgebungen integrieren. Da sie komplett containerisiert und API-gesteuert ist, passt sie ideal zur Cloud-Native-Strategie vieler Unternehmen und ermöglicht eine plattformübergreifende Skalierung – vom Edge bis zum Core, vom Rechenzentrum bis zur Public Cloud. Der Wechsel zu softwaredefinierter Objektspeicherung bringt mehrere Vorteile mit sich. Die Möglichkeit, heterogene Hardware in einem skalierbaren Pool zu kombinieren, eröffnet große Freiräume bei der Kapazitäts- und Performanceplanung. So können Unternehmen exakt auf ihre Anforderungen zugeschnittene Infrastruktur aufbauen, ohne auf teure proprietäre Geräte angewiesen zu sein.

Zudem erleichtert die native Integration in Kubernetes-Orchestrierung den Betrieb, da Speicherressourcen dynamisch bereitgestellt, verwaltet und skaliert werden können. Entwickler profitieren von einer konsistenten S3-kompatiblen API, die den Zugriff und die Integration mit unterschiedlichsten Cloud-Diensten vereinfacht. Ein weiterer wichtiger Aspekt ist die Sicherheit und Datenintegrität, welche in modernen Software-Defined Object Storage-Lösungen besondere Aufmerksamkeit erhalten. Features wie Objektimmutabilität, Versionierung und WORM (Write Once Read Many) sorgen dafür, dass Daten vor Änderungen oder Löschungen geschützt sind – essenziell für Compliance-Anforderungen in regulierten Branchen. Darüber hinaus gewährleisten Inline-Erasure-Coding-Verfahren höchste Ausfallsicherheit bei geringstem Speicheraufwand, indem Daten in mehrere Fragmente aufgeteilt und redundant abgelegt werden.

Im Vergleich zu herkömmlichen RAID-Systemen bieten diese Methoden eine schnellere Wiederherstellung und höhere Resilienz. Auch das Thema Performance darf nicht vernachlässigt werden. Moderne Objektspeicher erreichen je nach Hardwarekonfiguration beeindruckende Übertragungsraten und können sowohl große sequentielle Datenmengen als auch eine hohe Anzahl kleiner Objekte effizient handhaben. Dies widerspricht dem weitverbreiteten Mythos, Objektspeicherung sei langsam oder nur für Archivzwecke geeignet. Im Gegenteil, sie wird zunehmend für analytische Workloads, KI/ML-Prozesse, Streaming-Anwendungen und sogar als Backend für relationale Datenbanken eingesetzt.

Vergleicht man Objektspeicherung mit traditionellen Speicherformen wie File- und Blockspeicher, so treten klare Unterschiede hervor, die sich auf Anwendungsfall und Kosten auswirken. Dateispeicher arbeitet hierarchisch mit Verzeichnissen und eignet sich gut für klassische Applikationen, bringt jedoch Skalierungsprobleme im Internetkontext mit sich. Blockspeicher zerlegt Daten in einzelne Blöcke und wird meist für transaktionale Datenbanken verwendet, ist allerdings teuer und erfordert eine externe Metadatenverwaltung. Objektspeicherung dagegen bietet nahezu unbegrenzte Skalierbarkeit, kosteneffiziente Speicherung und eine flexible Datenklassifizierung über Metadaten, die tiefgreifende Analysen unterstützt. Die Cloud-Native-Entwicklung ist ein weiterer Katalysator für die Verbreitung von softwaredefinierter Objektspeicherung.

Da immer mehr Anwendungen containerisiert sind und auf Microservices setzen, muss der Speicher mit diesen Paradigmen mithalten. Das bedeutet API-gesteuerte, automatisierte Bereitstellung und Verwaltung, Multi-Tenancy, Lightweight-Design sowie vollständige Nutzerraum-Architektur ohne Kernel-Abhängigkeiten. Nur so lässt sich Storage nahtlos in Kubernetes orchestrieren und flexibel auf spezifische Workloads anpassen. Essentiell für Unternehmen ist auch die Multi-Cloud-Fähigkeit, die einzig softwaredefinierte Lösungen vollumfänglich bieten. In einer Welt, in der Daten und Anwendungen über diverse Cloud-Anbieter und On-Premises-Umgebungen verteilt sind, gewinnt Portabilität und Verfügbarkeit zunehmende Bedeutung.

Die Fähigkeit, Objektspeicher plattformübergreifend zu betreiben und zwischen verschiedenen Clouds oder Standorten zu verschieben, sichert Geschäftskontinuität und verhindert Anbieterabhängigkeit. Bei der Auswahl einer softwaredefinierten Objektspeicherlösung sollten Unternehmen auf mehrere Kernkriterien achten. Ein reiner Fokus auf Objektspeicherung garantiert eine spezialisierte und optimierte Architektur statt eines unzureichenden All-in-One-Produktes. Die vollständige Kompatibilität mit dem S3-Standard, idealerweise in den Versionen V2 und V4, ist Grundvoraussetzung für eine breite Anwendungsintegration. Performanceoptimierte Funktionen wie SIMD-beschleunigte S3 Select unterstützen datenintensive Analysen direkt im Speicher, was Bandbreite und Rechenressourcen effizienzsteigernd reduziert.

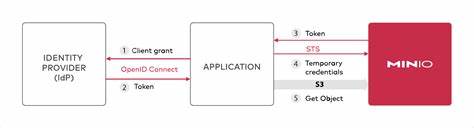

Resilienz wird vor allem durch fortschrittliches Erasure Coding, BitRot-Schutz mit leistungsfähigen Hash-Algorithmen und Active-Active-Replication gewährleistet. Diese Features minimieren Ausfallzeiten und Datenkorruption selbst in anspruchsvollsten Einsatzszenarien und gewährleisten eine nahezu unterbrechungsfreie Datenverfügbarkeit. Kombiniert mit flexiblen Identity- und Access-Management-Lösungen, die sowohl interne als auch externe Anbieter wie LDAP, OpenID Connect oder Single Sign-On unterstützen, entsteht ein robustes Sicherheitskonzept zur Einhaltung strenger Compliance-Regeln. Die Bedienbarkeit der Speicherumgebung ist ebenfalls entscheidend. Intuitive Web-Konsolen, umfassende CLI-Tools und eine gut dokumentierte API erleichtern Administratoren sowohl den Betrieb als auch die Fehlerdiagnose.

Automatisierte Monitoring- und Logging-Funktionen mit Unterstützung gängiger Standards wie Prometheus und Grafana sorgen für transparente Einblicke in Systemzustände und Performance. Gleichzeitig ermöglichen Lambda-Events und Integrationen mit Nachrichtensystemen wie Kafka oder MQTT die Anbindung serverloser Anwendungen und das Event-getriebene Arbeiten. Nicht zu vernachlässigen sind Funktionen zur Datenlebenszyklusverwaltung und Tiering. Ein moderner Objektspeicher sollte Daten automatisch basierend auf Zugriffsmustern zwischen schnellen NVMe- oder SSD-Medien und kostengünstigeren HDDs verschieben können. Ebenso wichtig ist die Option, Daten zwischen unterschiedlichen öffentlichen und privaten Cloud-Umgebungen oder sogar an den Edge zu verlagern.

Diese Fähigkeiten maximieren Kosteneffizienz und Leistungsfähigkeit gleichermaßen und ermöglichen eine dynamische Anpassung an sich ändernde Geschäftsanforderungen. Insgesamt bieten softwaredefinierte Objektspeicherunternehmen eine flexible, skalierbare und leistungsfähige Grundlage für moderne Dateninfrastrukturen. Gerade in Zeiten von Big Data, KI-Anwendungen und hybriden Cloud-Strategien ist ein solcher Ansatz unerlässlich, um Wettbewerbsvorteile zu sichern. Unternehmen, die sich intensiv mit den Auswahlkriterien auseinandersetzen und auf eine Cloud-Native, API-first-Architektur setzen, sind bestens auf die Herausforderungen der digitalen Zukunft vorbereitet und vermeiden die Einschränkungen statischer appliance-basierter Systeme. Ob es darum geht, Datenmengen jenseits der Petabyte effizient zu verwalten, analytische Insights direkt am Speicherort zu gewinnen oder eine hochverfügbare und sichere Lösung für regulatorisch sensible Daten zu implementieren – softwaredefinierte Objektspeicherung ist der Schlüssel zur Modernisierung der Speicherlandschaft.

Die Investition in eine solche Technologie macht Unternehmen agiler, kosteneffizienter und zukunftssicher im Umgang mit ihren wertvollsten Ressourcen: den Daten.

![OpenSIPS Summit 2025 [video]](/images/4C0C0F24-2C44-4857-858B-3EBE52B97793)