Die Welt des Deep Learnings hat in den letzten Jahrzehnten eine bemerkenswerte Entwicklung durchlaufen. Von den bescheidenen Anfängen mit einfachen neuronalen Netzen auf schwacher Hardware bis hin zu den heutigen gigantischen Sprachmodellen, die auf Hochleistungs-GPUs trainiert werden, hat sich vor allem die Effizienz von Algorithmen und Systemen massiv verbessert. Dieser Bericht beleuchtet die Meilensteine, Konzepte und technischen Innovationen, die diesen Fortschritt möglich gemacht haben, und gibt einen Einblick in den aktuellen Stand im Jahr 2024. Zu den frühen Erfolgen gehört die Nutzung von Backpropagation in den späten 1980er Jahren. Ein besonderer Meilenstein war Yann LeCun's Arbeit mit Convolutional Neural Networks (CNN) auf einer sehr einfachen Hardware mit 16,67 MHz Taktfrequenz und nur 128 MB Speicher.

Obwohl das damalige Modell mit etwa 10.000 Parametern klein war, bietet es heute einen interessanten Kontrast zu den enormen Modellen der Gegenwart. Die Implementierung erforderte damals noch eine manuelle Ableitung, da Autodifferenzierungswerkzeuge fehlten. Doch auch in dieser spärlichen Umgebung wurden leistungsfähige Ergebnisse erzielt, die den Weg für spätere Entwicklungen ebneten. Eine entscheidende technologische Wende brachte die Einführung von CUDA im Jahr 2006 durch NVIDIA.

Mit der Einführung der Tesla-GPU-Mikroarchitektur begann die Nutzung von Grafikprozessoren nicht mehr nur für Computergraphik, sondern als universelle Beschleuniger für wissenschaftliche und maschinelle Lernanwendungen. CUDA ermöglichte es Entwicklern, parallele Berechnungen effizienter zu programmieren, ohne sich mit Grafik-APIs auseinandersetzen zu müssen. Die Einführung von Tensor Cores ab 2017 sorgte zudem für einen enormen Leistungsschub bei der Matrixmultiplikation, einem zentralen Baustein von neuronalen Netzwerken. Parallel zu den Hardware-Fortschritten entstanden wichtige Software-Frameworks, die für breite Akzeptanz und größere Zugänglichkeit sorgten. Theano im Jahr 2012 war einer der ersten Versuche, symbolische Tensoroperationen zu optimieren.

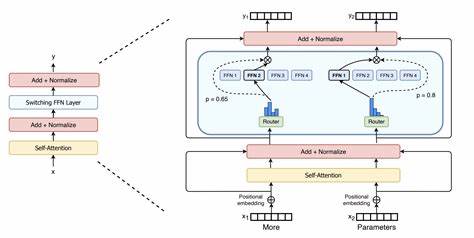

Kurz darauf folgten Caffe, TensorFlow und PyTorch. Besonders PyTorch setzte mit seinem dynamischen Rechenmodell neue Standards bei einfacher Nutzung und Flexibilität. Google brachte mit JAX eine funktionale Alternative mit Just-in-Time-Kompilierung heraus, die besonders auf TPUs optimiert ist. Solche Frameworks bilden heute die Grundlage für die rasante Entwicklung neuer Modelle. Die Architekturen für Deep Learning durchliefen ebenfalls eine interessante Evolution.

Während Recurrent Neural Networks (RNNs) lange Zeit sehr präsent waren, hat die Transformer-Architektur seit 2017 das Feld dominiert. Sie zeichnet sich besonders durch das Aufmerksamkeitsmechanismus (Attention) aus, der jedoch wegen seiner quadratischen Komplexität in Bezug auf Reihenlänge eine Herausforderung für die Skalierung darstellt. Zahlreiche Arbeiten wie Sparse Transformers, Longformer oder Performer versuchten, diesen Engpass mit sparsamen oder approximativen Verfahren zu überwinden. Dennoch haben sich viele dieser Ansätze in der Praxis nicht durchgesetzt, da sie oft die Genauigkeit kompromittierten oder kaum echte Laufzeitvorteile brachten. Ein wichtiges Forschungsfeld ist seit langem die effiziente Konvergenz von Modellen.

Die Einbindung von induktiven Biases wie Residualverbindungen, Dropout, speziellen Aktivierungsfunktionen sowie leistungsfähigen Optimierern wie Adam und AdamW führte zu stabileren und schnelleren Trainingsprozessen. Gleichzeitig halfen Methoden wie Lernratenscheduler, insbesondere Cosine-Annealing, dabei, das Training zu optimieren. In Fragen der Modellkompression und Speicheroptimierung war das sogenannte Pruning ein zentraler Ansatz. Bereits 2015 zeigte die Arbeit „Learning both Weights and Connections“ die Möglichkeit, neuronale Netze durch das Entfernen unwichtiger Gewichte drastisch zu verkleinern, ohne einen nennenswerten Performanceverlust hinzunehmen. Die berühmte Lottery Ticket Hypothesis unterstrich die Existenz kleiner, trainierbarer Teilnetzwerke in großen Netzen.

Allerdings hat das unstrukturierte Pruning seine Grenzen, da Hardware oft nicht von sparsamer Modellstruktur profitiert. Deshalb gewinnen strukturierte Ansätze und Quantisierungstechniken an Bedeutung. Quantisierung erlaubt es, hochpräzise Gewichte und Aktivierungen auf weniger Bits zu komprimieren. Insbesondere das BF16-Format gilt seit einigen Jahren als Industriestandard im Training von großen Modellen wegen seiner stabilen Dynamik. Mit der Einführung von FP8 Unterstützung durch die neuesten NVIDIA H100 GPUs ist ein weiterer Effizienzsprung in Sicht.

Automatische Mixed Precision (AMP) ermöglicht es, Trainingsvorgänge soweit wie möglich auf niedrigeren Präzisionseinstellungen durchzuführen, ohne dabei an Qualitätsverlust oder Stabilität einzubüßen. Die epochemachende Arbeit „Deep Compression“ kombinierte Pruning mit Quantisierung und Codierung wie Huffman-Kompression, was zu bis zu 50-facher Speicherreduktion bei konserviertem Modellverhalten führte. Trotz dieser vielversprechenden Ergebnisse wird diese Art der extremen Komprimierung bei sehr großen Transformer-Modellen bisher selten eingesetzt. Ein weiterer bedeutender Aspekt ist die Parallelisierung und Verteilung von Trainingsprozessen. Große Modelle wie GPT-3 mit 175 Milliarden Parametern oder Meta's LLaMA 3.

1 mit 405 Milliarden Parametern erfordern Multi-GPU- und Multi-Node-Cluster. Datenparallelismus teilt Chargen von Trainingsdaten auf mehrere GPUs auf, stößt aber bei sehr großen Batchgrößen aufgrund von Generalisierungsproblemen an Grenzen. Modellparallelismus, bei dem das Modell selbst über Maschinen verteilt wird, kompliziert die Synchronisation, jedoch macht genau dieses Vorgehen extrem großes Training erst möglich. Pipeline-Parallelismus ergänzt Modellparallelismus, indem rechnerische Abhängigkeiten durch Mikrobatches überlappend ausgeführt werden, was die Auslastung der GPUs erhöht. Frameworks wie Megatron-LM oder DeepSpeed haben diese Techniken in entwickelten Bibliotheken zugänglich gemacht, die ZeRO-Optimierungen implementieren, um redundant belegten Speicher bei der Verteilung von Parametern, Gradienten und Optimierungsstatistiken zu minimieren.

Die Skalierungsgesetze erweisen sich als wichtige Werkzeuge, um vorherzusagen, wie sich Modellgröße, Trainingsdatenmenge und Rechenbudget auf die erwartete Modellleistung auswirken. Arbeiten wie jene von Kaplan et al. oder dem Chinchilla-Team identifizierten klare Power-Law-Beziehungen, die Unternehmen helfen, Ressourcen optimal für gewünschte Leistungsziele einzusetzen. Insbesondere zeigte sich, dass eine bessere Balance zwischen Modellgröße und Datensatzgröße essenziell für Effizienz ist. Interessanterweise erleben wir seit kurzem ein Umdenken hin zu kleineren, sogenannten Small Language Models (SLMs).

Unter Berücksichtigung beschränkter Budget- und technischer Ressourcen geht man den Weg, hochqualitative und gut kuratierte Trainingsdaten zu nutzen, um vergleichbare Leistungen zu erzielen. Modelle wie die Phi-Serie von Microsoft forcieren diesen Ansatz. Strukturierte Pruning-Methoden wie Sheared LLaMA konzentrieren sich zudem auf hardwarefreundliche Kompression durch das Entfernen ganzer Schichten oder Heads. Sowohl auf Trainings- als auch auf Inferenzseite spielen moderne Quantisierungsmethoden eine wachsende Rolle. Ein Beispiel ist LLM.

int8(), das 8-Bit-Quantisierung speziell an großen Modellen adaptieren kann, ohne Modellzusammenbruch durch Ausreißer zu provozieren. Ebenso AGW (Activation-Aware Weight Quantization) identifiziert die für Genauigkeit kritischsten Parameter und behandelt diese besonders sorgfältig. 1- und 2-Bit Quantisierungsmethoden wie BitNet zielen auf maximale Kompression und Effizienz, stehen aber noch vor Herausforderungen bezüglich Leistungseinbußen und Hardware-Unterstützung. Ein spannendes Marginalfeld stellen sparsamer parametrisierte Modelle und Transformermodelle mit sparsamen Attention-Mustern dar, die den Rechenaufwand enorm reduzieren können. Innovative Ansätze wie StreamingLLMs mit Attention Sinks zeigen, dass sich solche sparsamen Mechanismen in realen Szenarien effizient implementieren lassen.

Allerdings sind Herausforderungen bei der Hardware-Ökonomie und Softwareintegration nach wie vor präsent. Im Bereich der Modellinferenz werden die Anforderungen an Latenz und Durchsatz immer strenger. Frameworks wie vLLM mit paged Attention verwalten KV-Caches intelligent, um Speicherfragmentierung und Ineffizienz zu verringern. Gleichzeitig erlauben Methoden wie speculative decoding, bei denen eine kleinere Draft-Version des Modells die nächsten Tokens vorhersagt, eine Beschleunigung der Generierung. Neuere Ansätze wie Medusa nutzen mehrere Dekodier-Köpfe, um noch effizienter zu arbeiten.

Derzeit befinden wir uns in einer Phase, in der Supercluster mit Zehntausenden von GPUs Standard werden. Während der Nutzen weiterer Skalierungen diskutiert wird, wächst der Druck, neue Forschungsansätze jenseits der reinen Parameteranzahl zu finden. Kombinationen aus effizienteren Algorithmen, KPI-optimierten Hardwarelösungen und alternativen Architekturen könnten zukünftig von entscheidender Bedeutung sein. Fazit: Die Effizienz im Deep Learning hat sich in den letzten vier Jahrzehnten durch zahlreiche technische Errungenschaften erheblich gesteigert. Sowohl im Bereich der Hardware, durch GPUs, TPUs und spezialisierte ASICs, als auch in der Software mit optimierten Frameworks und Compilertechnologien, konnten Modelle immer größer und leistungsfähiger werden.

Trends wie strukturierte Pruning-Methoden, fortschrittliche Quantisierung und optimierte verteilte Trainingsverfahren zeigen, dass die Forschung sich zunehmend auf ganzheitliche Optimierung konzentriert. Die nächsten Jahre werden zweifellos weitere spannende Fortschritte bringen, die Deep Learning noch effizienter und zugänglicher machen.