Amazon Bedrock hat die Art und Weise, wie Unternehmen künstliche Intelligenz nutzen, revolutioniert, indem es eine innovative Technologie namens Model Distillation anbietet. Diese Technologie ermöglicht es, kleinere, schnellere und deutlich kosteneffizientere KI-Modelle zu erstellen, die dabei dennoch eine Genauigkeit erreichen, die mit größeren und komplexeren Modellen vergleichbar ist. Besonders für Unternehmen, deren Anwendungen hohe Leistungsanforderungen bei begrenzten Budgets erfüllen müssen, bietet Amazon Bedrock Model Distillation einen entscheidenden Vorteil. Model Distillation bezeichnet den Prozess, bei dem ein großes, sogenanntes »Teacher«-Modell seine Fähigkeiten an ein kleineres »Student«-Modell weitergibt. Dabei lernt das Student-Modell, die Ausgabe des leistungsstarken Teacher-Modells nachzuahmen und somit ähnliche Resultate zu erzielen, jedoch mit einem Bruchteil des Rechenaufwands und der damit verbundenen Kosten.

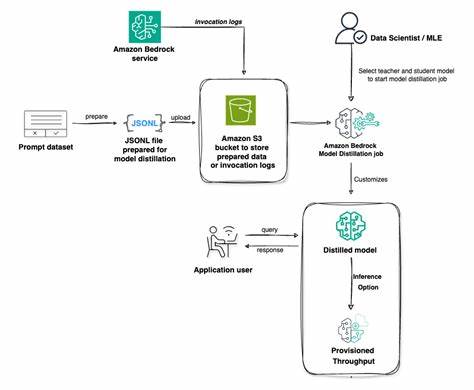

Dieses Verfahren hat das Potenzial, KI-Anwendungen deutlich zugänglicher zu machen, besonders in Bereichen wie natürlicher Sprachverarbeitung, bildgebender Analyse oder Agenten-gestützten Workflows. Amazon Bedrock baut auf dieser Technologie auf und bietet eine maßgeschneiderte Lösung für die Praxis. Anwender können zunächst ein Teacher-Modell auswählen, dessen Genauigkeit sie erreichen möchten – beispielsweise leistungsstarke Modelle wie Amazon Nova Premier oder Claude 3.5. Anschließend wählen sie ein beobachtetes Student-Modell, etwa Amazon Nova Pro oder eine kleinere Variante von Llama, das für die Feinabstimmung vorgesehen ist.

Indem die Bedrock-Plattform automatisiert die Antworten des Teacher-Modells generiert und zur Anpassung des Student-Modells verwendet, entsteht ein schnellerer, kostengünstigerer Vertreter mit nur minimalen Einbußen bei der Genauigkeit. Ein wesentlicher Vorteil von Model Distillation in Amazon Bedrock ist die Verbesserung der Effizienz ohne deutliche Qualitätsverluste. In Tests konnten die destillierten Modelle bis zu fünfhundert Prozent schneller arbeiten und die Kosten um bis zu 75 Prozent reduzieren, während die Genauigkeit nicht mehr als zwei Prozent unter dem Niveau des ursprünglichen Modells lag – ein beachtlicher Kompromiss für viele praktische Anwendungsfälle, insbesondere bei Retrieval-Augmented Generation (RAG), bei der schnelle und präzise Antworten auf Anfragen entscheidend sind. Die Technologie geht aber noch weiter, indem sie speziell auf die Bedürfnisse einzelner Kunden zugeschnittene Daten-Synthese integriert. Denn die Feinabstimmung eines Student-Modells ist ein iterativer Prozess.

Amazon Bedrock nutzt unterschiedliche Methoden zur Datenvervielfältigung, um die Trainingsbasis zu erweitern. Dadurch können für den jeweiligen Anwendungsfall relevante Datensätze durch generierte, ähnliche Prompts oder hochwertige synthetische Antworten ergänzt werden. Diese Herangehensweise erlaubt eine bessere und schneller erreichbare Modellleistung, ohne dass Kunden einen hohen Aufwand für eigene Datenaufbereitung betreiben müssen. Darüber hinaus wird der Prozess deutlich vereinfacht, da Kunden bei der Datenbereitstellung nicht mehr zwingend fertige Antworten liefern müssen. Im klassischen Fine-Tuning ist sowohl Prompt als auch korrekte Antwort notwendig.

Mit Amazon Bedrock Model Distillation reicht das Einreichen der Prompts. Die Plattform übernimmt die Generierung synthetischer Antworten auf Basis der vorhandenen Teacher-Modelle. Alternativ können Kunden auch ihre Produktionsdaten, etwa Invokationsprotokolle aus realen Anwendungen, direkt einbringen. Bedrock kann diese Logs analysieren, filtern und bei Bedarf einsetzen, um das Modelltraining ohne wiederholte Antwortgenerierung durch die teureren Teacher-Modelle zu optimieren. Dies minimiert nicht nur Kosten, sondern beschleunigt auch den gesamten Anpassungsprozess erheblich.

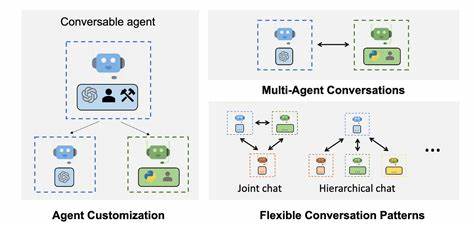

Ein weiterer Bereich, in dem Amazon Bedrock Model Distillation besonders Mehrwert schafft, liegt in der Verbesserung der Vorhersagegenauigkeit bei Agenten-funktionalen Aufrufen. Moderne KI-Anwendungen interagieren oft mit externen Systemen, APIs oder Datenbanken, indem sie passende Funktionen möglichst präzise erkennen und mit korrekten Parametern aufrufen. Große Modelle leisten diese Aufgabe zwar gut, sind aber mit hohen Kosten und Verzögerungen verbunden. Durch Distillation können viel kleinere Modelle diese Fähigkeit übernehmen und so schneller und günstiger funktionieren, ohne Einbußen bei der Zuverlässigkeit. Dies unterstützt etwa Chatbots oder automatisierte Workflows, die eine effiziente und nahtlose Interaktion mit unterschiedlichsten Softwarekomponenten verlangen.

Die praktische Anwendbarkeit von Amazon Bedrock Model Distillation zeigt sich in verschiedenen Branchen. In der Kundenbetreuung können schnelle, präzise Antworten mittels kleinerer Modelle realisiert werden, was die Nutzerzufriedenheit steigert und Betriebskosten senkt. In der Finanzdienstleistung oder im Gesundheitswesen helfen maßgeschneiderte KI-Modelle dabei, sensible Daten effizient zu verarbeiten und dennoch regulatorische Anforderungen zu erfüllen. Auch in der Softwareentwicklung profitieren Teams von leistungsstarken, aber ressourcenschonenden KI-Tools, die beispielsweise Code analysieren oder generieren. Die Fähigkeit, spezialisierte, zeit- und kosteneffiziente Modelle einzusetzen, eröffnet neue Möglichkeiten für Innovation und Skalierbarkeit.

Darüber hinaus unterstützt Amazon Bedrock Entwickler durch eine benutzerfreundliche Konsole und ausführliche Guides, die den Einstieg erleichtern und die Komplexität von Modellfeinabstimmung und Distillation verringern. Zudem stellt Amazon Beispielcodes bereit, die beim Aufbau eigener Workflows helfen, um das Potenzial der Model Distillation bestmöglich auszuschöpfen. Die Integration in bestehende Softwarelandschaften und Cloud-Infrastrukturen wird dadurch ebenfalls gefördert. In puncto Sicherheit und Datenschutz bietet Amazon Bedrock vertrauenswürdige Rahmenbedingungen, etwa durch die Möglichkeit, eigene Daten sicher einzubringen und zu kontrollieren. Insbesondere bei sensiblen Anwendungsgebieten ist dies ein unverzichtbarer Aspekt.

Außerdem sind die Schnittstellen so gestaltet, dass Kunden größtmögliche Transparenz über ihre Trainingsdaten und Modelle erhalten sowie die Kontrolle über deren Nutzung behalten. Zusammenfassend stellt Amazon Bedrock Model Distillation einen bedeutenden Fortschritt im Bereich KI dar. Es verbindet die Leistungsfähigkeit großer Sprach- und KI-Modelle mit der Erfordernis nach Geschwindigkeit, Kosteneffizienz und praxisgerechter Anpassbarkeit. Die Technologie ist dabei nicht nur für große Unternehmen interessant, sondern ebenso für Start-ups und mittelständische Firmen, die auf flexible, wirtschaftliche KI-Lösungen angewiesen sind. Die Zukunft der künstlichen Intelligenz wird zunehmend durch intelligente Optimierung und Automatisierung geprägt sein.

Amazon Bedrock liefert mit der Model Distillation nicht nur ein wichtiges Werkzeug zur Kosten- und Zeitersparnis, sondern fördert gleichzeitig Innovation, indem es erlaubt, AI-Modelle gezielt und effizient an individuelle Bedürfnisse anzupassen. Damit öffnet sich ein breites Spektrum an Möglichkeiten – von verbesserten Kundenservices bis hin zu autonomen Agentenanwendungen und spezialisierten Analysewerkzeugen. In einer Welt, in der Geschwindigkeit und Präzision immer wichtiger werden, bietet Amazon Bedrock Model Distillation eine perfekte Kombination aus Technologie, Benutzerfreundlichkeit und Wirtschaftlichkeit. Unternehmen, die diese Lösung einbinden, profitieren von schnelleren Reaktionszeiten, reduzierten Betriebskosten und qualitativ hochwertigen KI-Interaktionen. Dies macht die Plattform zu einem unverzichtbaren Baustein moderner AI-Strategien und einem künftigen Eckpfeiler digitaler Transformationen.

Für alle, die auf der Suche nach einer effektiven Methode sind, ihre KI-Infrastruktur zu optimieren und gleichzeitig die Leistungsfähigkeit der besten Modelle zu erhalten, ist Amazon Bedrock Model Distillation daher eine äußerst attraktive Option. Sie ermöglicht es, den hohen Anforderungen verschiedener Branchen gerecht zu werden, ohne das Budget unrealistisch zu belasten. Durch automatisierte Prozesse, intelligente Datenverarbeitung und flexible Einsatzmöglichkeiten lassen sich so nachhaltig Wettbewerbsvorteile erzielen und innovative Lösungen schneller realisieren.