In der heutigen Zeit, in der Datenverfügbarkeit und deren intelligente Nutzung entscheidend für den Geschäftserfolg sind, wird die Brücke zwischen künstlicher Intelligenz und echten Datenquellen immer relevanter. Besonders in Bereichen wie Produktanalytik oder Nutzerverhalten ermöglicht der direkt Zugang zu Backend-Datenbanken schnelle und präzise Antworten auf komplexe Fragen. Die Kombination aus Firebase als Datenbanklösung und MCP-Servern als Schnittstelle bietet hierbei einen vielversprechenden Ansatz. Firebase erfreut sich als hochskalierbare NoSQL-Datenbank besonderer Beliebtheit, vor allem für Echtzeitanwendungen und mobile Apps. Es bietet vielfältige Funktionen, angefangen bei Realtime-Datenbank über Firestore-Services bis hin zu leistungsfähigen SDKs zur einfachen Integration.

Doch gerade bei umfangreichen Datenmengen und komplexen Abfragen stellt sich oft die Herausforderung, dass klassische Tools wie Mixpanel oder Posthog eine aufwändige Einrichtung mit sich bringen, die für schnelle, spontane Fragen oft nicht praktikabel ist. Genau an diesem Punkt setzt die Integration eines eigenen MCP-Servers an. MCP – kurz für Modular Command Protocol – ist ein Protokoll, das es erlaubt, KI-Agenten wie Claude oder Cursor mit externen Tools zu verbinden, auf die sie zur Laufzeit zugreifen können. So ist es möglich, Sprachbefehle in Datenbankabfragen umzuwandeln wodurch eine naive Schnittstelle zwischen natürlicher Sprache und Datenanalyse entsteht. Die Flexibilität von MCP ermöglicht es, maßgeschneiderte Werkzeuge zu entwickeln, die genau auf individuelle Anforderungen zugeschnitten sind.

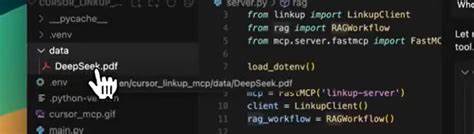

Ein praktisches Beispiel zeigt der Entwickler Bill Prin, der seinen MCP-Server erweitert hat, um speziell für seine Poker-Trainingsapp Live Poker Theory produktbezogene Fragen mit Firebase zu beantworten. Statt lange Dashboards und Event-Tracking einzurichten, wollte er direkt mit natürlicher Sprache herausfinden, ob Nutzer mehr Turniere oder Cash Games trainieren. Das ist ein feines Detail, das alltäglichen Workflow stark vereinfacht und Zeit spart. Die Implementierung eines solchen Servers startete mit einer Open-Source-Basis: einem MCP-Server-Repository von Gannon Hall, das bereits eine Grundlage bot, um Datenbankabfragen zu ermöglichen. Dennoch gab es eine wichtige Hürde.

Die bisherigen MCP-Implementierungen, sowohl die offizielle Firebase-Variante als auch Gannons Version, unterstützten nicht die Zählfunktion, die für große Datenmengen essentiell ist. Denn bei vielen tausend Dokumenten wäre das abrufen aller Datensätze zum Zählen nicht nur ineffizient, sondern auch kostspielig aufgrund der gebührenpflichtigen Lesezugriffe bei Firebase. Die Lösung lag in der Nutzung der fortschrittlichen Zähl-API aus dem firebase-admin SDK, die eine effiziente Zählung von Dokumenten erlaubt, ohne alle Daten einzeln zu ermitteln. Diese Funktion erfordert jedoch eine eigene Erweiterung des MCP-Servers, da sie vorher in den gängigen MCP-Servern nicht eingebunden war. Durch das Forken des Repositories konnte Bill Prin die benötigte Funktion hinzufügen und so einen maßgeschneiderten MCP-Server schaffen, der genau diese Zählabfragen unterstützt.

Erfahrungen aus der Entwicklung zeigen, dass die Unterstützung durch KI-Codegeneratoren wie Cursor hilfreich sein kann. Das automatische Generieren von Basiscode für die Zählfunktion gestaltete sich relativ einfach, allerdings traten typische „vibe coding“-Effekte auf: die KI generierte zunächst unnötige Parameter wie eine Sortierung (orderBy) oder Paginierung, die bei einer reinen Zählabfrage nicht sinnvoll sind. Ein menschliches Review war somit unverzichtbar, um solche Fehler rechtzeitig zu erkennen und auszubessern. Dies unterstreicht erneut, dass KI-Tools zwar eine enorme Erleichterung bieten, aber dennoch eine fundierte Entwicklererfahrung voraussetzen. Ein weiteres nützliches Werkzeug in diesem Entwicklungsprozess war der MCP Inspector.

Dieses Debugging-Tool ermöglicht das Simulieren und Testen von Toolaufrufen außerhalb der eigentlichen KI-Integration. Es hilft dabei, schnell die korrekte Funktionsweise der MCP-Serverfunktionen zu überprüfen ohne das vollständige System initialisieren oder über Cursor bzw. Claude gehen zu müssen. Gerade bei der Arbeit mit Umgebungsvariablen und Firebase-Credentials entfaltet der Inspector seinen Nutzen, indem er die manuelle Fehlersuche minimiert und den Entwicklungsworkflow erheblich beschleunigt. Die Modellierung der Firebase-Daten selbst stellte aufgrund der Datenstruktur besondere Herausforderungen dar.

Beispielsweise enthielten die Sessions keine explizite Kategorisierung als „Turnier“ oder „Cash Game“. Stattdessen musste Bill den Filter über Stringvergleiche im Feld für Charts realisieren. Da Firebase keine Substring-Filter unterstützt, kam eine clevere Filtermethode über Bereichsvergleiche zum Einsatz: alle Turnier-Charts beginnen mit „MTT“, sodass mit einem Vergleich - "MTT" <= Wert < "MTU" - die relevanten Datensätze zuverlässig gefiltert werden konnten. Der MCP-Server wurde dabei nicht einfach durch die übliche Tool-Registrierung eingebunden, sondern durch speziell konfiguriertes Handling von Request-Typen, wie ListToolsRequestSchema und CallToolRequestSchema. Diese Form erlaubt mehr Flexibilität und Kontrolle beim Routing und der Definition der Werkzeuge als der häufig verwendete Standardpfad.

Ein zusätzlicher Vorteil ist die Einbindung in die Smithery-Plattform, einer gemeinschaftlichen Registry für MCP-Server, die auch HTTP-basierte Transports unterstützt und somit einen Ausblick auf zukünftige Entwicklungen bezüglich Transportprotokollen gibt. Neben technischen Herausforderungen gab es auch praktische Schwierigkeiten, etwa mit Portkonflikten. Der Server verweigerte den Start, wenn Port 3000 bereits belegt war, was bei Nutzung von stdio extern nicht relevant wäre. Solche Fehlerquellen sind typisch für komplexe Entwicklungsumgebungen und erfordern ein durchdachtes Troubleshooting, bevor der Server stabil produktiv läuft. Aus Analyse-Daten ergaben sich wertvolle Produkt-Insights.

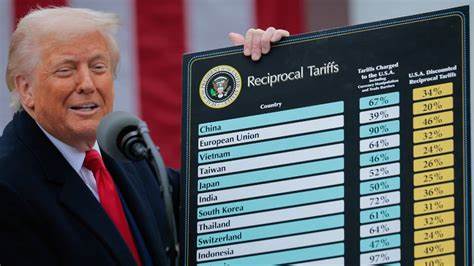

Von etwa 17.000 Sessions waren circa 40 Prozent Turnierspiele. Das überraschte den Entwickler, der erwartet hatte, dass Turniere dominieren, da der Demo-Flow auf Turniertraining ausgelegt ist. Im Poker-Kontext machen Turnierspiele häufig klarere und strukturiertere Vorentscheidungen erforderlich, während Cash Games kreativer und oft tiefgründiger sind. Die Daten zeigten, dass Cash Game Studien bei den Nutzern sogar mehr Beachtung finden – eine wichtige Erkenntnis für eine datengetriebene Produktentwicklung.

Der entscheidende Vorteil dieser individuellen MCP-Server-Lösung ist die Möglichkeit, im Entwicklungseditor direkt mit natürlicher Sprache auf die produktiven Firebase-Daten zuzugreifen. Die KI übersetzt dann die Anfragen intelligent in Datenbankabfragen. Dies schafft völlig neue Arbeitsabläufe, da Produktentscheider und Entwickler leichter und schneller auf operative Kennzahlen zugreifen können, ohne aufwändige Dashboards oder komplexe Querysprachen beherrschen zu müssen. Die Erfahrungen zeigen auch klar, dass während KI-gestütztes Codieren ein mächtiges Werkzeug ist, dennoch eine kritische Prüfung und ein gutes Verständnis der Backend-Architektur notwendig bleiben. MCP-Tooling befindet sich noch in einer frühen Phase, und während es erste Registries und Transportwege gibt, leben die meisten Anwendungen momentan lokal.

Tools wie der MCP Inspector sind deshalb essenziell für produktives Arbeiten. Zusammenfassend lässt sich sagen, dass maßgeschneiderte MCP-Server die Lücke zwischen KI und Echtzeitproduktionsdaten bemerkenswert schließen können. Die Fähigkeit, präzise Fragen in natürlicher Sprache zu stellen und direkte Antworten aus Firebase zu erhalten, eröffnet neue Möglichkeiten im Produktmanagement und der Analyse. Die geschilderte Lösung, verbunden mit den gemachten Learnings aus Implementierung und Praxis, empfiehlt sich als Vorbild für Entwickler, die ähnliche Herausforderungen mit Datenbank- und KI-Integrationen bewältigen möchten. Mit weiteren Fortschritten bei Firebase, MCP-Protokollen und KI-Assistenztools wird sich dieser Bereich zukünftig noch viel stärker verbreiten.

Es lohnt sich, die Entwicklungen aufmerksam zu verfolgen und eigene Projekte entsprechend zu gestalten, um datengetriebene Produktentscheidungen schneller und unkomplizierter zu ermöglichen.