In einer Welt, in der täglich unzählige E-Mails den digitalen Posteingang überschwemmen, ist die effiziente und präzise Suche nach wichtigen Informationen eine zentrale Herausforderung. Häufig sind es nicht nur die Menge und die Vielfalt der Nachrichten, sondern auch die Komplexität der Anfragen, die traditionelle Suchfunktionen an ihre Grenzen bringen. Genau an diesem Punkt setzt ART·E an – ein innovativer E-Mail-Forschungsagent, der entwickelt wurde, um diese Hürden zu überwinden und dabei in puncto Geschwindigkeit, Kosten und Genauigkeit neue Maßstäbe zu setzen. ART·E ist das Ergebnis neuester Forschung im Bereich der Künstlichen Intelligenz, speziell der Anwendung von Reinforcement Learning (RL) im Bereich natürlicher Sprachverarbeitung. Während frühere Agenten wie o3 bereits beachtliche Leistungen erbracht haben, zeigt ART·E, dass es möglich ist, durch gezielte Optimierung und spezielle Trainingsansätze bedeutende Verbesserungen zu erzielen.

Dies macht ART·E zu einem wichtigen Werkzeug für alle, die eine zuverlässige und intuitive Lösung zur Beantwortung von Fragen aus ihrem E-Mail-Postfach suchen. Die Auswahl einer realistischen und praxisnahen Aufgabe spielte eine entscheidende Rolle bei der Entwicklung von ART·E. Die Suche im E-Mail-Posteingang ist nicht nur alltäglich, sondern oft auch zeitintensiv und umständlich. Die Vorstellung, per natürlicher Sprache präzise Auskünfte zu erhalten, ohne sich mit Suchbegriffen und Filterfunktionen auseinandersetzen zu müssen, brachte die Entwickler auf die Idee, ART·E genau für diese Herausforderung zu konzipieren. Somit stellt ART·E einen Sprung von rudimentären Suchmechanismen hin zu einem intelligenten Agenten dar, der selbst komplexe, kontextabhängige Fragen beantworten kann.

Ein zentraler Schritt bei der Entwicklung war die Erstellung eines realistischen Datensatzes für Training und Bewertung. Da es kaum öffentlich zugängliche, ausreichend detaillierte E-Mail-Datensätze mit passenden Frage-Antwort-Paaren gibt, griff das Team auf den berühmten Enron-E-Mail-Datensatz zurück. Dieser stammt aus einem der wohl bekanntesten Wirtschaftsskandale und umfasst hundertetausend E-Mails ehemaliger Mitarbeiter. Für die Evaluation und das Training wurden ausgewählte Postfächer mit jeweils mehreren Tausend E-Mails herangezogen. Um für jede E-Mail passende Fragen zu generieren, kam eine speziell angepasste Version von GPT-4 zum Einsatz, die synthetisch realistische und nutzerorientierte Fragen produzierte.

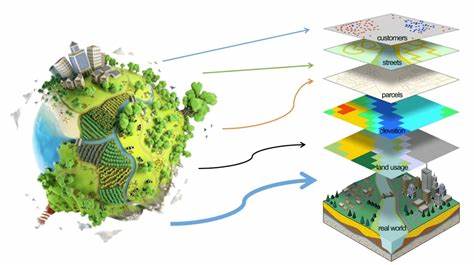

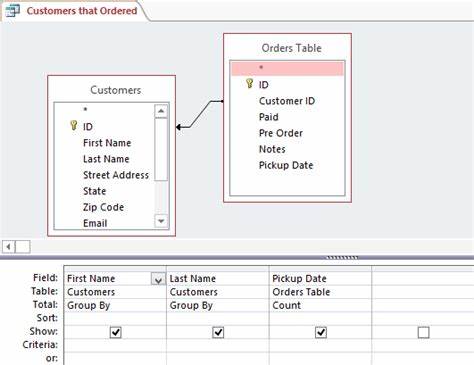

Diese Vorgehensweise ermöglichte eine breite und vielfältige Grundlage, die das Modell später für präzise Antworten nutzte. Die Umgebung, in der ART·E operiert, ist bewusst einfach gehalten, um den Fokus auf die eigentliche Recherchefähigkeit zu legen. Dem Agenten werden drei Hauptwerkzeuge zur Verfügung gestellt: eine Suchfunktion für E-Mails basierend auf Schlüsselwörtern und Zeitfiltern, eine Funktion zum vollständigen Lesen der E-Mail-Inhalte anhand der jeweiligen Nachricht-ID sowie eine Rückgabe-Funktion für die finale Antwort inklusive der verwendeten Quellen. Hinter der Suchfunktion steckt ein SQLite-Datenbanksystem mit einer Full-Text-Suche, das einen schnellen und effizienten Zugriff auf die relevanten E-Mails sicherstellt. Der Steuerungsmechanismus des Agenten besteht aus mehreren Iterationsschritten.

Zunächst erhält ART·E die Aufgabenstellung, beispielsweise eine Frage aus einem Nutzerkontext. Dann greift er je nach Bedarf suchend und lesend auf die E-Mails zu und verarbeitet die gewonnenen Informationen. Dieser Dialogzyklus wiederholt sich, bis der Agent entweder eine abschließende Antwort liefert oder die maximale Anzahl an Schritten erreicht ist. Trotz der simplen Architektur baut ART·E auf Schwarmintelligenz durch Reinforcement Learning auf, wodurch es kontinuierlich lernt, seine Strategie für die Recherche zu verbessern. Authentische Leistungsmessungen sind für die Weiterentwicklung entscheidend.

Vor Beginn des eigentlichen RL-Trainings wurden diverse Modelle und Ansätze kritisch analysiert, um mögliche Schwachstellen zu identifizieren und die Rahmenbedingungen zu perfektionieren. Dabei erwies sich die Evaluation anhand einer automatisierten Überprüfung durch ein Sprachmodell als praktikabel. Dieses bewertet, ob die Antwort des Agenten der sogenannten Goldstandardantwort entspricht – ein Maßstab für die Genauigkeit. Ein besonders wichtiges Element ist die Definition der sogenannten Belohnungsfunktion, die das Lernverhalten während des Reinforcement Trainings steuert. Ursprünglich diente die bloße Übereinstimmung der Antworten als Grundlage.

Doch für ART·E wurden weitere Qualitätskriterien integriert, die dem Agenten Anreize bieten, schneller und gewissenhafter zu arbeiten. So wurden kürzere Antwortwege mit zusätzlichen Punkten belohnt, während falsche oder halluzinierte Antworten mit Abzügen sanktioniert wurden. Dieses Vorgehen fördert nicht nur präzise, sondern auch effiziente Recherchen und vermeidet die frustrierenden falschen Ergebnisse, die bei digitalen Assistenten häufig vorkommen. Neben der finalen Belohnung versuchte das Team auch, den Lernfortschritt durch Zwischenziele zu erleichtern, wie beispielsweise die korrekte Identifikation passender E-Mails im Suchergebnis oder die richtige Auswahl der Quelle. Diese sogenannten partiellen Belohnungen hatten jedoch nur einen geringen Einfluss auf die Trainingsgeschwindigkeit, was darauf hindeutet, dass der Agent bereits genügend Lernsignale aus der Hauptbewertung erhielt.

Zudem zeigte ein Erfahrungswert, dass zu komplexe oder missverstandene Zwischenbelohnungen den Agenten dazu verleiten können, suboptimale Verhaltensweisen zu entwickeln – etwa sich wiederholende Aufgaben oder endlose Schleifen. Für das eigentliche Training setzte das Team das Open-Source-Framework ART (Agent Reinforcement Trainer) ein, das speziell für die Entwicklung von mehrstufigen Agenten konzipiert wurde. ART implementiert eine moderne Version von Reinforcement Learning namens Group Relative Policy Optimization (GRPO), die eine höhere Stabilität und Effizienz beim Training verspricht. Das Training selbst umfasste mehrere Durchläufe mit verschiedenen Fragen aus dem synthetischen Datensatz, wobei jede Frage mehrfach simuliert wurde. Die daraus entstehenden Verläufe wurden bewertet, um das Modell schrittweise zu optimieren.

Interessant ist, dass die gesamte Trainingsphase mit optimierten Rückkopplungsschleifen und moderner Hardware wie der NVIDIA H100 GPU innerhalb eines Tages abgeschlossen werden konnte und die Kosten bei etwa 80 US-Dollar lagen – ein bemerkenswert günstiger Wert für solch anspruchsvolle KI-Anwendungen. Während der Trainingsphase war das Monitoring ein entscheidender Faktor für den Erfolg. Ein besonderes Augenmerk galt der Variabilität der Belohnungen, da eine zu geringe Streuung auf einen lokalen Optimums-Effekt hindeuten kann, der das Training blockiert. Durch Anpassungen bei der Lernrate, der Reward-Dichte oder der Vielfalt der Trainingsbeispiele ließ sich in solchen Fällen gegengesteuern. Zusätzlich wurden zahlreiche Metriken wie Antwortgenauigkeit, Anzahl der Zugriffe auf E-Mails und Fehlantworten verfolgt, um ein umfassendes Verständnis über die Entwicklungsfortschritte zu gewinnen.

Darüber hinaus analysierten die Entwickler regelmäßig konkrete Antworten des Modells, um manipulierendes Verhalten frühzeitig zu erkennen und auszuschließen. Das Ergebnis von ART·E kann sich sehen lassen. Im Vergleich zu o3 gelingt es ART·E nicht nur, 60 Prozent der Fragen zu beantworten, die sein Vorgänger nicht lösen konnte, sondern der Agent arbeitet auch fünfmal schneller und ist 64-mal kosteneffizienter im Betrieb. Diese Leistungssteigerung macht ART·E zu einem wertvollen Werkzeug, das den Alltag von vielen Nutzern vereinfachen kann. Die Fähigkeit, Antworten präzise und zügig aus großen, unübersichtlichen E-Mail-Beständen herauszufiltern, eröffnet neue Potenziale im Bereich persönlicher Assistenz und Unternehmenskommunikation.

Neben der technischen Finesse legt das Projekt auch großen Wert auf Offenheit und Nachhaltigkeit. Sowohl das finale Modell als auch die kompletten Trainingsscripte wurden als Open Source zur Verfügung gestellt. Dies befähigt Entwickler weltweit, auf diesen Fortschritten aufzubauen, eigene Anpassungen vorzunehmen oder das System in neue Anwendungsfelder zu überführen. Zudem wird durch regelmäßige Community-Veranstaltungen und Austauschforen eine lebendige Umgebung geschaffen, die Innovation und praktische Wissensvermittlung fördert. Die Kombination aus modernster KI-Forschung, praxisnaher Aufgabenstellung und robustem Entwicklungsprozess macht ART·E zu einem wegweisenden Projekt im Bereich der intelligenten Informationsverarbeitung.

Der Fokus auf Benutzerfreundlichkeit bei gleichzeitiger technischer Exzellenz zeigt exemplarisch, wie man komplexe KI-Technologien zielgerichtet für reale Probleme einsetzen kann. Für Unternehmen und Privatpersonen, die nach Lösungen suchen, ihre E-Mail-Kommunikation produktiver zu gestalten, bietet ART·E einen vielversprechenden Ausblick. Die Integration solcher Agenten kann dabei helfen, Informationsfluten zu bändigen, Entscheidungsprozesse zu beschleunigen und die Qualität der Arbeit zu erhöhen. Gleichzeitig zeigen die Erfahrungen mit ART·E, dass der Weg zu solchen Anwendungen durch sorgfältige Datenvorbereitung, kluge Reward-Designs und kontinuierliches Monitoring geebnet wird. Zusammenfassend lässt sich sagen, dass ART·E ein bedeutender Schritt hin zu intelligenten, lernenden E-Mail-Assistenten ist.

Durch die Kombination von Reinforcement Learning, smarten Algorithmen und realistischen Datensätzen konnte ein System geschaffen werden, das weit über herkömmliche Suchfunktionen hinausgeht und neue Standards für Effizienz und Genauigkeit setzt. Die Zukunft verspricht so noch engere Verzahnung von künstlicher Intelligenz und digitalem Alltag – ein Gewinn für Nutzer auf der ganzen Welt.

![Dr Russell Barkley's 30 essential ideas everybody needs to know about ADHD. (Y [video]](/images/C16EA6B6-1E2C-4CC4-91B4-8DBDA3C63F11)