Die rasante Entwicklung großer Sprachmodelle, auch Large Language Models (LLMs) genannt, hat in den letzten Jahren beinahe alle Fachbereiche der Wissenschaft erreicht – so auch die Chemie. Diese leistungsfähigen KI-gestützten Systeme, die auf gigantischen Textdatensätzen trainiert sind, können komplexe Texte verstehen, beantworten und sogar neue Inhalte generieren. Besonders spannend ist die Frage, inwieweit diese Modelle über fundiertes chemisches Wissen und die Fähigkeit zu wissenschaftlichem Denken verfügen, im Vergleich zu menschlichen Experten. Das Verständnis dieser Fragestellung ist entscheidend, um die Rolle von künstlicher Intelligenz zukünftig in Forschung, Lehre und Anwendung besser einordnen zu können. Im Folgenden wird ein Überblick über den aktuellen Stand der Technologie geboten, sowie deren Potenziale, Grenzen und Herausforderungen diskutiert.

Große Sprachmodelle und ihre Chemiekompetenz: Der Stand der Forschung LLMs wie GPT-4, Claude, LLaMA oder Galactica zeichnen sich dadurch aus, dass sie riesige Mengen an Textmaterial, inklusive wissenschaftlicher Publikationen, Lehrbücher und Online-Ressourcen, verarbeiten. Dadurch verfügen sie über ein beachtliches Wissen in verschiedenen Wissenschaftsdisziplinen, darunter auch Chemie. Jedoch ist ihr Verständnis nicht mit menschlichem Wissen direkt vergleichbar. Sie funktionieren primär durch Mustererkennung und das Vorhersagen von Textsequenzen basierend auf trainierten Wahrscheinlichkeiten. In einer kürzlich erschienenen Studie wurde ein leistungsfähiges Prüf- und Vergleichsinstrument namens ChemBench entwickelt, das über 2700 Frage-Antwort-Paare aus verschiedensten chemischen Themengebieten vereint.

Dieses Tool ermöglicht die systematische Bewertung von LLMs im Vergleich zu der Leistung erfahrener Chemiker. Die Analyse zeigt, dass Spitzenmodelle in vielen Bereichen sogar bessere Ergebnisse liefern als viele der teilnehmenden menschlichen Experten. Insbesondere bei grundlegenden Wissensfragen und standardisierten Prüfungsaufgaben übertrafen einige LLMs Menschen deutlich. Dabei wurde sowohl der reine Wissenserwerb als auch komplexeres chemisches Denken geprüft. Beachtenswert ist jedoch, dass der Erfolg der KI nicht uneingeschränkt ist.

Da menschliches Denken über reine Faktenkenntnis hinausgeht und komplexe, mehrstufige Schlussfolgerungen umfasst, sind diese Modelle teilweise noch nicht in der Lage, tiefgreifende Interpretationen oder strukturbezogene Analysen überzeugend umzusetzen. Beispielsweise fällt es den Modellen schwer, molekulare Symmetrien zu erkennen oder die Anzahl der Signale in einem Kernspinresonanzspektrum korrekt zu bestimmen. Solche Aufgaben erfordern ein echtes Verständnis molekularer Geometrie und physikalischer Prinzipien, die kaum allein durch Textdaten vollkommen abgebildet werden können. Überzeugende KI, aber mit begrenztem Selbstbewusstsein Eine weitere Herausforderung, die im Rahmen von ChemBench beleuchtet wurde, betrifft die Fähigkeit der KI-Modelle, Einschätzungen zu ihrer eigenen Sicherheit oder Korrektheit zu treffen. Für die Anwendung in der Forschung oder im Bildungsbereich wäre es sinnvoll, wenn die Modelle nicht nur Antworten geben, sondern auch ihre Zuverlässigkeit einschätzen könnten.

Die Studien zeigen, dass LLMs häufig übermäßig selbstsicher auftreten, selbst wenn sie falsche Antworten liefern. Für Anwender ohne tiefgreifende Fachkenntnisse kann dies problematisch sein, insbesondere wenn es um sicherheitsrelevante Chemieinformationen geht. Die Fähigkeit, Unsicherheit akkurat zu kommunizieren, bleibt somit eine offene Forschungsfrage. Einige Modelle geben zwar verbalisiert unterschiedliche Zuverlässigkeitsgrade an, doch diese sind oft nicht präzise kalibriert und bieten keine verlässliche Grundlage für kritische Entscheidungen. Hier besteht ein klarer Handlungsbedarf, damit KI-Systeme in sensiblen Bereichen verantwortungsvoll eingesetzt werden können.

Breite versus Tiefe – Unterschiede in chemischen Fachgebieten Die Leistungsfähigkeit der LLMs variiert stark je nach chemischem Themenfeld. Allgemeine Chemie und technische Chemie werden vergleichsweise gut gemeistert, während Bereiche wie Toxikologie, Sicherheitsvorschriften oder analytische Chemie schlechter abschneiden. Gerade bei Sicherheitsfragen, etwa im Umgang mit Gefahrstoffen, ist jedoch höchste Genauigkeit zwingend erforderlich, was die derzeitigen Modelle vor Herausforderungen stellt. Die Diskrepanz rührt unter anderem daher, dass manche Wissensbereiche in den Trainingsdaten der Modelle weniger umfangreich abgebildet sind oder spezielles Fachwissen erfordern, das oft nur in spezialisierten Datenbanken vorhanden ist. Diese sind für LLMs teilweise nicht direkt zugänglich, da die Modelle ohne integrierte Schnittstellen zu externen Fachquellen nur das Wissen einsetzen können, das sie vor dem Training angehäuft haben.

Darüber hinaus lassen sich die Schwierigkeiten bei komplexeren Analyseaufgaben darauf zurückführen, dass die Modelle keine echte dreidimensionale Vorstellung von Molekülen besitzen. Sie reagieren oft auf Ähnlichkeiten und bekannte Muster in der Datenbasis, anstatt die zugrundeliegenden physikalischen und chemischen Prinzipien aktiv zu simulieren oder zu berechnen. Mensch und Maschine: Wie sieht die Zukunft der Chemiearbeit aus? Der Vergleich zeigt eindrucksvoll, dass LLMs heute schon auf vielen Gebieten Chemiekenntnisse aufweisen, die mit denen von Expertinnen und Experten konkurrieren können. Sie sind aufgeweckt, verfügen über ein breites Faktenwissen und können in kurzer Zeit auf umfangreiche Literatur zugreifen. Das macht sie zu wertvollen Unterstützern für Forschung, Lehre und industrielle Anwendungen – als wissenschaftliche Assistenten oder Ideengeber.

Die Notwendigkeit, Berufsausbildung und Unterricht neu zu gestalten, ist offensichtlich. Wenn Maschinen Faktenwissen schneller und zuverlässiger anbieten können, verschiebt sich der Fokus menschlicher Ausbildung stärker auf kritisches Denken, Urteilsvermögen, ethische Reflexion und experimentelle Fähigkeiten. Ebenso brauchen wir klare Richtlinien für den verantwortungsvollen Umgang mit KI, um Fehlinformationen zu vermeiden und Sicherheitsrisiken zu minimieren. Doch trotz der Fortschritte bleibt der Mensch unverzichtbar, wenn es um kreative und komplexe Denkprozesse geht, die über reines Faktenwissen hinausgehen. Die kombinierten Stärken von Chemikern und künstlicher Intelligenz können die wissenschaftliche Produktivität erheblich steigern und innovative Wege in der Materialentwicklung, Arzneimittelforschung oder Umweltchemie eröffnen.

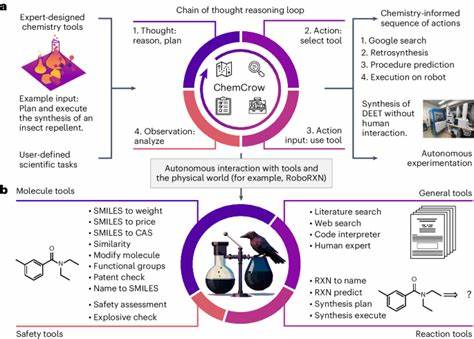

Technologische Entwicklungen und Herausforderungen Zukünftige Weiterentwicklungen zielen darauf ab, LLMs besser für den chemischen Fachbereich zu trainieren, indem sie auf spezialisierten Datenbanken und multimodalen Informationen aufbauen, etwa der Kombination von Text, molekularen Strukturen und experimentellen Daten. Solche multimodalen Modelle könnten das fehlende räumliche Verständnis verbessern, chemische Reaktionsmechanismen besser nachvollziehen und komplexere Schlussfolgerungen ziehen. Auch die Integration von Werkzeugen wie Web-Suche oder chemischen Rechenprogrammen in sogenannte Tool-augmented Systeme kann die Leistung steigern. So können LLMs nicht nur auf vortrainiertes Wissen zurückgreifen, sondern dynamisch aktuelle Daten oder Analysen abrufen. Damit steigen allerdings auch Anforderungen an das Systemdesign, die Datensicherheit und die Transparenz der Entscheidungen.

Ein weiteres Forschungsfeld befasst sich mit der sogenannten Präferenzmodellierung, bei der KI lernt, die Vorlieben von Chemikern in Entscheidungsprozessen abzubilden, zum Beispiel bei der Auswahl von Molekülen. Bisher stimmen LLMs in dieser Hinsicht kaum mit menschlichen Experten überein, sodass hier noch großes Potenzial besteht. Sicherheitsbedenken und ethische Aspekte Die duale Nutzbarkeit chemischer Kenntnisse und Werkzeuge bleibt eine kritische Aufmerksamkeitspflicht. Während KI-Modelle Chemiker bei der Entwicklung neuer, nützlicher Verbindungen unterstützen, können sie gleichzeitig potenziell zur Planung gefährlicher Stoffe missbraucht werden. Die Forschungsgemeinschaft entwickelt daher parallele Maßnahmen zur Risikobewertung und Verantwortlichkeit im Umgang mit solchen Technologien.

Zudem ist der unkritische Einsatz von LLM-Ergebnissen vor allem durch Laien eine potenzielle Gefahrenquelle. Fehlinformationen oder übermäßiges Vertrauen in falsche Antworten könnten zu Unfällen führen. Um dem entgegenzuwirken, sind bessere Nutzerschnittstellen, Nachverfolgbarkeit der Quellen und Aufklärung entscheidend. Fazit: Chancen und Grenzen der KI in der Chemie Große Sprachmodelle haben sich als mächtige Werkzeuge erwiesen, die chemisches Wissen in einem beeindruckenden Umfang verarbeiten und anwenden können. Ihre Fähigkeit, viele Prüfungsfragen schneller und teilweise besser als Menschen zu beantworten, deutet auf eine neue Ära in der Chemie hin, in der digitale Assistenten eine wichtige Rolle spielen.