Große Sprachmodelle, auch bekannt als Large Language Models (LLMs), haben in den letzten Jahren enorm an Bedeutung gewonnen. Sie ermöglichen menschenähnliche Kommunikation, unterstützen bei Recherche, Textgenerierung und Problemlösungen und sind mittlerweile fester Bestandteil vieler innovativer Anwendungen. Trotz ihrer beeindruckenden Fähigkeiten zeigen LLMs jedoch signifikante Schwierigkeiten in der Handhabung von Gesprächen, die sich über mehrere Dialogrunden erstrecken. Studien und Experimente haben gezeigt, dass diese Modelle in sogenannten Multi-Turn-Gesprächen, also längeren Dialogen mit mehreren Austauschrunden, oft den Faden verlieren und an Zuverlässigkeit einbüßen. Die Gründe dafür sind vielfältig und werfen grundlegende Fragen zur zukünftigen Entwicklung von KI-Sprachassistenten auf.

Der Kern des Problems ist, dass viele existierende LLMs für einzelne, klar definierte Aufgaben optimiert wurden. Das bedeutet, wenn eine Anweisung von einem Nutzer präzise formuliert wird, können sie darauf sehr effektiv und akkurat reagieren. Bei der Mehrfachinteraktion oder der sukzessiven Verfeinerung einer Aufgabe jedoch, wo der Kontext sich dynamisch verändert und früher getroffene Annahmen überdacht werden müssen, schneidet dieselbe Technologie deutlich schlechter ab. Dies liegt zum großen Teil daran, dass LLMs früh gefasste Annahmen nicht ohne Weiteres revidieren und sich durch Fehler in früheren Dialogschritten sozusagen „verlaufen“. Simulationsexperimente mit Hunderttausenden von Gesprächen haben gezeigt, dass im Mehrfachdialog die Leistung der Modelle beispielsweise bei der Textgenerierung, beim Beantworten komplexer Fragen oder beim Programmieren im Schnitt um etwa 39 Prozent im Vergleich zur Einzeltask-Performance abfällt.

Dabei lässt sich die Verschlechterung in zwei Hauptfaktoren zerlegen. Erstens gibt es einen leichten Verlust in der grundlegenden Fähigkeit, Aufgaben zu lösen – also eine Abnahme in der Kompetenz. Zweitens und deutlich gravierender ist eine Zunahme der Unzuverlässigkeit. Dies bedeutet, dass Modelle öfter falsche Annahmen treffen oder voreilig Lösungen ausarbeiten, die nicht mehr konsistent mit neuen Informationen sind. Ein Beispiel aus der Praxis: Wenn ein Nutzer in einem „Multi-Turn“-Gespräch mit einem Sprachmodell nach und nach eine komplexe Textanalyse verfeinern möchte, fängt das Modell unter Umständen schon nach den ersten Schritten an, voreilige Schlussfolgerungen zu ziehen.

Statt sich flexibel an neue Hinweise anzupassen, hält es an diesen alten Hypothesen fest, was zu immer unzutreffenderen Resultaten führt. Selbst wenn der Nutzer korrigierende Eingaben macht, überwindet das Modell diese Sackgasse oft nicht mehr, was eine Art „Verlaufen“ im Dialog bedeutet. Diese Tendenz kann in kritischen Anwendungen problematisch sein, da sie Vertrauen und Zuverlässigkeit untergräbt. Die Herausforderung liegt auch darin, wie Sprachmodelle den Kontext über mehrere Dialogrunden hinweg managen. Während der Kontext bei Einzelanfragen begrenzt und gut definiert ist, muss das Modell bei längeren Gesprächen Informationen speichern, bewerten und gewichten, welche früheren Aussagen weiterhin gültig sind.

Das ist eine komplexe Aufgabe, die sowohl vom Modell-Design als auch von der Trainingsstrategie abhängt. Aktuelle Methoden wie das sogenannte „Prompt Engineering“ oder die Nutzung von Zwischenzusammenfassungen versuchen, den Kontext konsistent zu halten, stoßen jedoch an technische Grenzen, wenn es um sehr umfangreiche oder wechselnde Inhalte geht. Die Ergebnisse der Studien rund um das Thema unterstreichen die Notwendigkeit, LLMs stärker auf das Handling von dynamischen Gesprächen auszurichten. Nur so können sie ihr Potenzial in echten Anwendungsszenarien voll ausschöpfen. Dazu gehört unter anderem, dass Modelle lernen müssen, wie sie frühere Annahmen kritisch hinterfragen, Fehler erkennen und korrigieren, anstatt sich auf vermeintliche Lösungen zu versteifen.

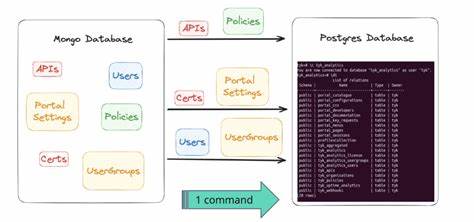

Mögliche Ansätze sind hier, Architekturverbesserungen in neuronalen Netzwerken oder die Integration von Mechanismen zur besseren Kontextmodellierung und -aktualisierung. Ein weiterer vielversprechender Weg ist die Kombination von LLMs mit externen Wissenquellen und Logikmodulen. Während Sprachmodelle hervorragend darin sind, Sprachmuster zu erkennen und zu reproduzieren, fehlt es ihnen oft an robustem Faktenwissen und langfristigem Gedächtnis in Dialogen. Die Verknüpfung mit spezialisierter Software oder Datenbanken könnte dabei helfen, Fehler frühzeitig zu vermeiden und die Zuverlässigkeit mehrstufiger Dialoge deutlich zu verbessern. Die Forschung zu diesem Thema ist noch jung, doch die praktischen Konsequenzen sind klar: Für Einsätze wie digitale Assistenten, Kundensupport-Systeme oder interaktive Lernplattformen ist es entscheidend, dass die Systeme über mehrere Interaktionsschritte hinweg stabil und verlässlich bleiben.