Die Verarbeitung und Analyse großer Datenmengen ist längst zu einer zentralen Herausforderung in der heutigen digitalen Welt geworden. Besonders bei der Arbeit mit JSON-Dateien – einem bevorzugten Format für den Datenaustausch im Web – stößt man bei Dateien ab einer Größe von 20 Megabyte oftmals an Leistungsgrenzen. Herkömmliche Online-Tools, die auf einfache Darstellung, Formatierung oder Suche ausgelegt sind, bringen Browser oft an ihre Grenzen, was zu langen Ladezeiten oder gar Abstürzen führt. Gerade für Entwickler, Datenwissenschaftler und Techniker ist es jedoch essenziell, auch mit umfangreichen JSON-Strukturen schnell Informationen zu extrahieren. Hier setzt der Fokus auf effiziente Suchmethoden und spezialisierte Werkzeuge an, die das Handling großer JSON-Datensätze grundlegend verbessern.

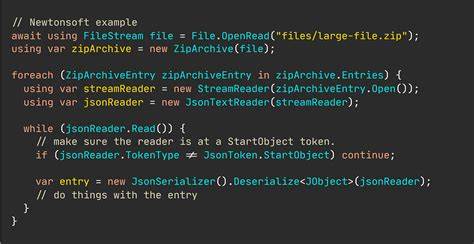

Ein optimales Tool muss dabei in der Lage sein, nicht nur schnell zu laden, sondern auch komplexe und tief verschachtelte Strukturen zu erkennen und gezielt zu durchsuchen, ohne durch ressourcenintensive Prozesse zum Stillstand zu kommen. Die Herausforderungen liegen in der schieren Datenmenge und der häufig hohen Verschachtelungstiefe, die eine einfache Suche erschweren. Zudem erzeugen visuelle Features wie Syntaxhervorhebungen oder umfangreiche Cursor-Interaktionen oft zusätzlichen Overhead, der bei großen Dateien zu Abstürzen führen kann. Die Lösung besteht oft darin, auf eine konsequente Performance-Optimierung zu setzen und auf ressourcenfressende Darstellungen zu verzichten. Moderne Anwendungen nutzen Web-Worker, um Aufgaben im Hintergrund zu bewältigen, wodurch die Haupt-User-Interface-Schicht entlastet wird und so Reaktionsfähigkeit erhalten bleibt.

Ergänzend kommen virtuelle Listen zum Einsatz, die nur einen Bruchteil der Daten sichtbar machen und rendern. Dies reduziert massiv den Speicherbedarf und beschleunigt die Anzeige selbst bei tausenden Suchergebnissen. Eine weitere wichtige Komponente ist eine intelligente Stringifizierungslogik, die auch bei sehr tiefen und komplexen JSON-Objekten zuverlässig funktioniert, ohne durch die native JSON.stringify Funktion an Grenzen zu stoßen. Neben der technischen Realisierung steht auch die Vielfalt der Suchmöglichkeiten im Fokus.

Für einfachere Suchen eignet sich die reine Textsuche, bei der gezielt nach bestimmten Zeichenfolgen innerhalb der Daten gesucht wird. Diese Methode ist intuitiv und deckt viele Alltagsanwendungen ab, stößt aber schnell an ihre Grenzen, wenn Strukturverständnis gefragt ist. Deshalb gewinnen strukturierte Suchabfragen wie JSON Path immer mehr an Bedeutung. Diese ermöglichen es, gezielt über definierte Pfade bestimmte Datenpunkte anzusprechen, ohne das gesamte Objekt durchforsten zu müssen. Die Kombination aus einfacher Eingabe und präziser Positionierung der Resultate stellt dabei eine erhebliche Erleichterung für Nutzer dar.

Noch mächtiger und flexibler gestaltet sich die Nutzung von JQ-Queries. JQ ist ein spezialisiertes Tool zur Verarbeitung von JSON-Daten, das komplexe Transformationen und Filterungen erlaubt, vergleichbar mit sed oder awk für Textdateien. Allerdings erfordert die Syntax von JQ oft eine gewisse Einarbeitungszeit, weshalb moderne Anwendungen mittlerweile visuelle Builder integrieren, die Schritt für Schritt beim Erstellen von JQ-Suchen helfen. Diese Drag-and-Drop-artigen Oberflächen verringern die Einstiegshürde, machen JQ zugänglicher und fördern damit eine breitere Nutzung. Auch das lokale Speichern von häufig genutzten Abfragen ist ein relevantes Feature, um den Workflow nachhaltig zu optimieren.

Die Open-Source-Charakteristik vieler dieser Tools ermöglicht zudem kontinuierliche Weiterentwicklung und Anpassung an individuelle Bedürfnisse. Entwicklergemeinschaften auf Plattformen wie GitHub tragen so zur Verbesserung der Funktionalität und Stabilität bei. Ein Beispiel für eine derartige Anwendung ist der Huge JSON Viewer, der gezielt für das Arbeiten mit sehr großen und stark verschachtelten JSON-Strukturen entwickelt wurde. Er verzichtet bewusst auf aufwändige visuelle Effekte und nutzt stattdessen effiziente Algorithmen, um selbst bei großen Datenmengen absturzfrei zu bleiben. Die Integration von Web-Workern sorgt für flüssige Bedienung, während die virtuelle Darstellung von Suchergebnissen schnelle Navigation ermöglicht.

Auch die Unterstützung von JQ-Queries mit einem interaktiven UI-Baukasten erleichtert komplexe Suchanfragen. Solche spezialisierten Werkzeuge sind unverzichtbar in Zeiten, in denen Datenvolumen stetig wachsen und effiziente Verarbeitung immer mehr an Bedeutung gewinnt. Für Unternehmen und Entwickler, die regelmäßig mit JSON-Daten arbeiten, bedeutet dies eine erhebliche Zeitersparnis und zuverlässigere Workflows. Neben Softwarelösungen ist auch das Verständnis und die Anwendung geeigneter Suchtechniken entscheidend. Nutzer sollten sich mit den Grundlagen von JSON Path und JQ vertraut machen, um das volle Potenzial der Werkzeuge auszuschöpfen.

Verschiedene Ressourcen, Tutorials und Community-Plattformen bieten hierfür wertvolle Hilfestellungen. Zudem sollte die Wahl des passenden Tools stets auf Faktoren wie Dateigröße, Komplexität der Datenstruktur und Nutzungszweck abgestimmt sein. Eine gute Praxis ist es, JSON-Daten initial zu filtern oder zu zerlegen, bevor umfangreiche Suchabfragen durchgeführt werden, um Ressourcen zu schonen. Die Speicherung häufiger Suchmuster verbessert zudem den Workflow und vermeidet wiederkehrende Arbeitsschritte. Insgesamt zeigt sich, dass trotz der Herausforderungen beim Umgang mit großen JSON-Dateien im Web effektive und stabile Lösungen existieren.

Durch gezielte Optimierung des Renderingprozesses, Auslagerung rechenintensiver Operationen in Hintergrundprozesse und verschiedene Suchmodi können Nutzer große Datenmengen komfortabel und ohne Angst vor Abstürzen durchsuchen. Dies fördert nicht nur die Produktivität, sondern eröffnet auch neue Möglichkeiten in der Datenanalyse und Webentwicklung. Wer die beschriebenen Methoden und Tools nutzt, ist bestens gerüstet, um den Umgang mit riesigen JSON-Dateien souverän zu meistern und datengestützte Erkenntnisse effizient zu gewinnen.