Die rasante Weiterentwicklung künstlicher Intelligenz hat in den letzten Jahren eine neue Ära der Softwareentwicklung eingeleitet. Insbesondere KI-gestützte Programmierhilfen, auch bekannt als AI-Coding-Assistenten, erfreuen sich immer größerer Beliebtheit und bieten Programmierern Unterstützung bei der Codeerstellung. Doch trotz dieser technologischen Fortschritte offenbart sich ein bislang kaum beachtetes Problem: die sogenannten pervertierten Anreize im sogenannten Vibe Coding. Dabei handelt es sich um eine Spielart der Programmierung, die durch den Einsatz von KI-Systemen geprägt ist und bestimmte psychologische sowie ökonomische Dynamiken hervorruft, die das Ergebnis eher verschlechtern als verbessern können. Vibe Coding zeichnet sich durch das stetige Hin- und Her von Eingaben und Ausgaben zwischen dem Nutzer und der KI aus.

Programmierer geben kurze Anweisungen oder Fragen in ein Modell ein und erhalten daraufhin Codefragmente, die meistens noch revisionsbedürftig sind. Das ständige „Fast-aber-nicht-ganz“-Gefühl schafft eine Art Suchtmechanismus, der, ähnlich wie Glücksspiele, auf unregelmäßiger Verstärkung basiert. Dieses Phänomen lässt Programmierer immer wieder neue Eingaben vornehmen, in der Hoffnung, dass der nächste Vorschlag der KI exakt die richtige Lösung liefert. Wissenschaftlich gesehen stimuliert dieses variable Belohnungsschema die Dopaminwege im Gehirn besonders stark, was den sogenannten Vibe Coding Zwang erklärt. Die Verlockung, mit minimalem Aufwand durchaus nützliche Ergebnisse erzielen zu können, führt dazu, dass viele Nutzer intensiver mit KI-Assistenten interagieren als mit herkömmlichen Programmier-Methoden.

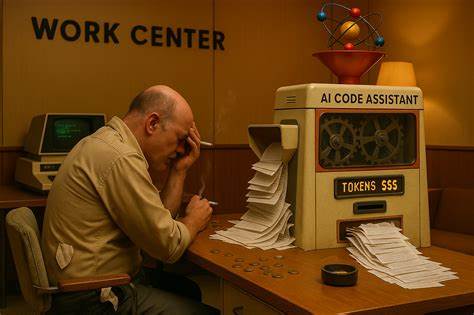

Dieses „Effort Discounting“ sorgt dafür, dass sich die geringe Anstrengung im Verhältnis zu den potenziellen Erfolgen besonders attraktiv anfühlt. Hinzu kommt eine psychologische Neigung namens „Completion Bias“, also der Wunsch, begonnene Aufgaben auch abzuschließen. Zusammen erschaffen diese Mechanismen eine Endlosschleife, in der Nutzer immer weiter Prompts eingeben, obwohl dies oft nicht zu einem qualitätsvollen Endprodukt führt. Doch der Kostenfaktor ist nicht nur psychologisch, sondern auch finanziell relevant. Viele KI-Coding-Tools basieren auf einem Preismodell, das sich nach der Menge der verarbeiteten und erzeugten Tokens richtet.

Dies hat zur Folge, dass die Systeme eher dazu neigen, äußerst ausführlichen und oft redundanten Code zu produzieren, da dadurch die Verkaufseinahmen steigen. Anstelle von eleganten, schlanken Lösungen generiert die KI häufig überkomplexe und verschachtelte Programme, die zwar auf den ersten Blick beeindruckend wirken, jedoch in der Praxis zusätzliche Fehleranfälligkeit und schlecht wartbaren Code bedeuten. Ein erfahrener Programmierer würde das Problem mit wenigen präzisen Zeilen effektiver lösen als eine KI, die auf maximale Textgenerierung optimiert ist. Diese Überproduktion von Code hat mehrere Nachteile. Zum einen verlangsamt es den Entwicklungsprozess, da die überflüssigen Zeilen erstmal verstanden, getestet und gegebenenfalls korrigiert werden müssen.

Zum anderen erhöht sich die Fehleranfälligkeit – die KI produziert nicht nur mehr Code, sondern auch mehr Nebeneffekte, versteckte Bugs und unnötige Komplexität, die menschliche Entwickler oft erst mühselig aufspüren müssen. Besonders problematisch wird es beim Debugging, da jeder weitere Schritt wiederum den Token-Verbrauch in die Höhe treibt und somit die Kosten steigen. Entwickler befinden sich so in einer Kostenfalle, aus der es schwer wird, herauszukommen, denn jeder weitere AI-gestützte Eingriff verlangt erneut viel Rechenkapazität und Geld. Ein großer Teil dieses Problems liegt in der Trainingsdatenbasis der Modelle. Die KI-Systeme wurden überwiegend mit bereits existierendem Code aus öffentlichen Repositories trainiert, dessen Qualität und Eleganz stark variiert.

Es gibt eine Vielzahl von Codefragmenten, die besonders umfangreich, repetitiv oder verworren sind – beispielsweise bestimmte Java-Frameworks oder generierter Boilerplate-Code. Die KI spiegelt somit nicht nur das aktuelle Niveau der Softwareentwicklung wider, sondern verstärkt oftmals auch dessen Schwächen. Aus diesem Grund neigen die Modelle dazu, ähnliche Patterns von Ausführlichkeit und Redundanz zu replizieren, anstatt wirklich innovative oder minimalistische Ansätze zu produzieren. Diese Entwicklung wird durch das zugrundeliegende Geschäftsmodell zusätzlich verstärkt. Weil KI-Entwickler meisten über Tokenverbrauch oder ähnliche mengenbasierte Ansätze monetarisieren, haben sie keinen direkten Anreiz, sparsamer oder eleganter zu programmieren.

Das Gegenteil ist der Fall: Je länger die generierten Inhalte, desto höher der Umsatz. Dies führt zu einem klassischen „Perverse Incentive“-Problem, bei dem die Anreizstruktur für Anbieter und Nutzer nicht auf Effizienz, sondern auf Maximierung der Nutzung ausgelegt ist. Oft wird argumentiert, dass selbst Abonnements mit Flatrate-Modellen die Problematik nicht lösen, weil sonstige Begrenzungen und Sperren den Verbrauch unter Kontrolle halten, was die Grundkonfiguration nicht grundlegend ändert. Ein weiterer Aspekt ist die Herausforderung, die KI zur präzisen Bearbeitung komplexer, abstrakter Probleme zu bringen. Hochkomplexe Algorithmen wie Minimax-Implementierungen oder tiefe Refactorings bergen in sich Anforderungen, die über das reine Mustererkennen hinausgehen.

Da viele Sprachmodelle hauptsächlich Texte vorhersagen und Muster extrapolieren, fällt es ihnen schwer, wirkliche systemische Lösungen zu entwickeln. Ihre Antworten sind oft gestückelt, inkohärent oder versehentlich redundanter als nötig. Untersuchungen und Praxisbeispiele zeigen, dass die KI bei anspruchsvollen Aufgaben häufig in „Verschachtelungsfallen“ gerät und das Problem nicht an seiner Wurzel packt. Psychologisch wird dieses Phänomen noch verschärft durch die eigenen Nutzungsgewohnheiten und die Methodik der Interaktion. Statt mit einem durchdachten, klar gegliederten Plan zur KI zu gehen, werden häufig Feature-Level-Anfragen gestellt, die das System dazu bringen, große und komplexe Codeblöcke zu produzieren, die den Nutzer überfordern und oft unbrauchbar sind.

Effektiver ist es, die Arbeit in kleine, verständliche und überprüfbare Einheiten zu zerlegen, so dass selbst Junior-Entwickler den Überblick behalten könnten. Es ist erwähnenswert, dass die Forderung nach Kürze und Prägnanz in der Antwortgenerierung ebenfalls eine Herausforderung darstellt. Forschungsarbeiten zeigen, dass der Versuch, Modelle zu zwingen, kurz und knapp zu antworten, oft zu Fehlern und Ungenauigkeiten führt. Hier steht das Modell vor der schwierigen Entscheidung, entweder eine unvollständige oder falsche Antwort zu liefern beziehungsweise gar nicht zu antworten. Dies gilt nicht nur für Textantworten, sondern auch für Codierungsaufgaben, bei denen ein Mehr an Erklärung und Zwischenschritten die Genauigkeit und Qualität der Ausgabe verbessert.

Um diesen vielschichtigen Problemen entgegenzuwirken, entwickeln erfahrene Nutzer Strategien, um den negativen Effekten der pervertierten Anreize zu begegnen. Sie fordern von den KI-Systemen häufig zuerst detaillierte Pläne und Architekturbeschreibungen an, bevor überhaupt eine Zeile Code generiert wird. Dieses Vorgehen zwingt das System, strukturell zu denken und kann zu klarerem, kompakterem Code führen. Ebenso setzen Nutzer auf eine Art Erlaubnisprotokoll, das automatisches Generieren von Code unterbindet, bis eine ausdrückliche Zustimmung gegeben wird. Versionskontrollsysteme wie Git helfen, experimentelle Änderungen nachzuvollziehen, zu bewerten und bei Ineffizienz rigoros zu verwerfen – was einen mentalen Schnitt mit Fehlentwicklungen erleichtert.

Interessanterweise kann auch der bewusste Einsatz günstigerer, weniger leistungsfähiger Modelle Vorteile bringen. Die Einschränkungen in Kapazität und Kontextfenster führen nicht selten dazu, dass die KI sich auf wesentliche Lösungselemente konzentrieren muss, anstatt den Output mit unnötigem Ballast zu überladen. Solche Modelle eignen sich hervorragend für Routineaufgaben und kleinere Projekte. Damit kann der Programmierer seine Ressourcen schonen und dennoch von der KI-Unterstützung profitieren. Für die Zukunft sind bessere Anreize im AI-Ökosystem essenziell.

Ein Umdenken bei den Geschäftsmodellen ist erforderlich, die nicht nur nach Größe der Ausgabe, sondern vor allem nach der Qualität und Wartbarkeit bewerten. Feedbackmechanismen, bei denen Entwickler mehrere Versionen vergleichen und die beste auswählen, könnten in das Training integriert werden, um KI-Modelle gezielt für eleganten Code zu sensibilisieren. Verantwortliche Unternehmen sollten auch erkennen, dass zufriedene Entwickler, die klare, minimalistische und gut wartbare Programme erhalten, letztlich mehr Wert bringen als hohe Verkaufszahlen basierend auf unnötigem Tokenverbrauch. Letztlich sind KI-Systeme lediglich Werkzeuge, deren Effektivität maßgeblich durch die Ziele und Strukturen ihrer menschlichen Entwickler und Betreiber gesteuert wird. Die Diagnosen zur Fehlentwicklung liegen weniger in den Modellen selbst, sondern in den wirtschaftlichen Zwängen, die sie umgeben.

Nutzer sollten sich dieser Dynamiken bewusst sein und mit einer Kombination aus technischem Wissen, kritischem Bewusstsein und kreativer Nutzung bestehender Systeme versuchen, bessere Ergebnisse zu erzielen. Die Debatte um Vibe Coding und seine Anreizprobleme zeigt, dass gerade in einem so schnellen Innovationsumfeld wie der KI-Entwicklung die Balance zwischen Technik, Psychologie und Ökonomie entscheidend ist. Nur durch eine ganzheitliche Betrachtung lässt sich das volle Potenzial künstlicher Intelligenz in der Softwareentwicklung nachhaltig ausschöpfen – zugunsten sauberer, wartbarer und effizienter Programmierung, die dem Entwickleralltag und den Anforderungen moderner Softwareprojekte gerecht wird.

![Brian Pontarelli on the Future of AI in Authentication and Education [video]](/images/DF5536F2-E6CC-4262-98D9-5A781F51D386)