Die rasante Entwicklung von Künstlicher Intelligenz (KI) und insbesondere der großen Sprachmodelle (LLMs) hat in den letzten Jahren auch das Gebiet des Software-Engineerings grundlegend verändert. Immer mehr Agenten, die auf solchen Modellen basieren, werden entwickelt, um komplexe Softwareentwicklungsaufgaben zu automatisieren oder zumindest zu unterstützen. Doch trotz dieser Fortschritte stehen Entwickler und Forscher vor zwei großen Herausforderungen: Zum einen fehlt es an hochwertigen und realistischen Trainingsdaten, die echte Entwicklungsprozesse und Interaktionen in Softwareprojekten abbilden. Zum anderen erschweren veraltete und durch Kontamination belastete Benchmarks eine realistische Einschätzung der Leistungsfähigkeit der Modelle. Im Zentrum dieser Problematik steht die Frage, wie man reale Aufgabe und Evaluationsmethoden erzeugen kann, die sowohl vielfältig als auch aktuell sind und dabei reale Zielsetzungen im Software-Engineering abbilden.

SWE-Rebench ist eine neuartige und automatisierte Pipeline, die genau diese Herausforderungen adressiert und für frischen Wind in der Evaluierung von Software-Engineering-Agenten sorgt. Entwickelt von einem Team führender Forscher, ermöglicht sie die kontinuierliche Sammlung interaktiver Software-Engineering-Aufgaben aus vielfältigen GitHub-Repositories. Über 21.000 interaktive, pythonbasierte Aufgaben wurden so bereits extrahiert, was ein mords großes und zugleich nutzerrelevantes Trainings- und Evaluationskorpus zur Verfügung stellt. Das Besondere an SWE-Rebench ist seine Skalierbarkeit und die Fähigkeit, Aufgaben nicht nur zu sammeln, sondern auch den Benchmark stets kontaminationsfrei und somit objektiv zu halten.

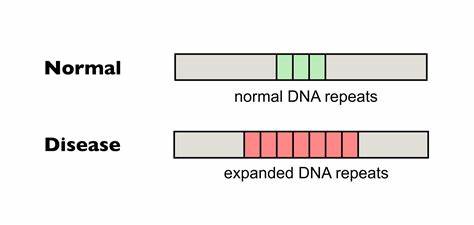

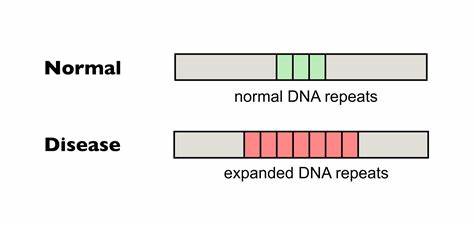

Bei der Entwicklung von LLM-basierten Agenten ist es entscheidend, ihre Leistungsfähigkeit realistisch und unter aktuellen Bedingungen bewerten zu können. Vorhandene Benchmarks wie SWE-Bench Verified sind in diesem Punkt begrenzt, da sie statisch sind und häufig bereits von den trainierten Modellen gesehen wurden, was zu einer Überschätzung der Fähigkeiten führt. Durch die kontinuierliche Erfassung und Integration neuer Aufgaben von SWE-Rebench wird dieses Risiko minimiert. Die Evaluierung kann so momentane Entwicklungen exakt widerspiegeln, und die Vergleichbarkeit zwischen verschiedenen Modellen wird erheblich verbessert. Zusätzlich zum Umfang und der Frische der Daten berücksichtigt SWE-Rebench auch die Interaktivität, also die Fähigkeit der Agenten, nicht nur statische Codeausschnitte zu bearbeiten, sondern als Teil eines dynamischen Entwicklungsprozesses mit der Umgebung zu kommunizieren, Code auszuführen und aufgrund dieser Rückmeldungen ihr Verhalten anzupassen.

Solche realistischen Szenarien sind unerlässlich, um den Nutzen von KI im Software-Engineering praxisnah zu erforschen und zu fördern. Die Erfolge von SWE-Rebench lassen sich auch konkret in den gemessenen Resultaten ablesen. So konnte durch den Vergleich verschiedener Large Language Models (LLMs) auf der neuen Benchmark gezeigt werden, dass viele bisher veröffentlichte Leistungswerte durch Datenkontamination verzerrt sind. Das bedeutet, dass einige Modelle nicht so gut sind, wie es oberflächliche Messwerte vermuten lassen. SWE-Rebench sorgt daher für eine ehrlichere und transparentere Evaluationsbasis und liefert dadurch wichtige Erkenntnisse für weitere Forschungs- und Entwicklungsarbeit.

Die automatisierte Pipeline von SWE-Rebench funktioniert durch die Nutzung moderner Techniken für die Analyse und Extraktion von relevanten Aufgaben in Repositorys. Sie berücksichtigt dabei die Interaktion mit z.B. Python-Code und den damit verbundenen Entwicklungswerkzeugen. Das Ergebnis ist eine kontinuierlich wachsende Kollektion von herausfordernden und praxisnahen Aufgaben, welche die Vielfalt und Komplexität realer Softwareprojekte widerspiegeln.

Für Entwickler von KI-Systemen bietet SWE-Rebench aufgrund dieser großen Datengrundlage die Möglichkeit, ihre Agenten mit verstärkendem Lernen (Reinforcement Learning) zu trainieren und somit gezielt Verhaltensweisen zu optimieren, die in tatsächlichen Entwicklungsumgebungen gefragt sind. Die Öffentlichkeitsarbeit rund um SWE-Rebench zeigt auch, wie wichtig es ist, Datensammlungen und Benchmarks transparent und allgemein zugänglich zu gestalten. Die Repositorys mit den Aufgaben stehen öffentlich zur Verfügung, diverse Leaderboards ermöglichen den direkten Vergleich von Modellen, was die Forschungsgemeinschaft stimuliert und den Fortschritt beschleunigt. Die Kombination aus einer langfristig angelegten Infrastruktur, einer intelligenten Methodik zur Sicherstellung der Datengüte und der Ausrichtung auf realitätsnahe Szenarien macht SWE-Rebench zu einer Schlüsselinnovation im Bereich des KI-gestützten Software-Engineerings. Im globalen Wettbewerb um die besten Agenten zur Automatisierung von Programmieraufgaben könnten die hier gewonnenen Standards und Werkzeuge eine Vorreiterrolle spielen.

Für Unternehmen, die KI-Technologien in die eigene Softwareentwicklung integrieren möchten, bietet SWE-Rebench eine wertvolle Grundlage, um Werkzeuge unter realistischen Bedingungen zu validieren und gezielt weiterzuentwickeln. Insgesamt stellt SWE-Rebench einen bedeutenden Fortschritt dar, nicht nur wegen der quantitativen Größenordnung an interaktiven Aufgaben, sondern vor allem durch den Fokus auf ganzheitliche und zugleich kontaminationsfreie Evaluierung. Die Forschung profitiert von einer realistischeren Einschätzung der Leistungsfähigkeit von Agenten und kann darauf aufbauend passgenaue Verbesserungen entwickeln. Anwender wiederum erhalten aussagekräftigere Benchmarks, die Entscheidungen beim Einsatz von KI in der Softwareentwicklung fundierter machen. Zu den größten Vorteilen von SWE-Rebench gehört seine Fähigkeit, sowohl das Training als auch die Evaluierung unmittelbar mit der Vielfalt und Dynamik realer Softwareprojekte zu verbinden.

Dies steht im starken Kontrast zu früheren Datensätzen, die häufig stark eingeschränkt, manuellen Kuratierungsprozessen unterworfen oder begrenzt auf einzelne Aspekte wie reine Einzelschritt-Codegenerierung waren. Die Zukunft von KI-gestütztem Software-Engineering wird entscheidend von solchen innovativen Ressourcen geprägt sein, die eine Brücke zwischen theoretischer Forschung und praktischer Anwendung schlagen. Dabei bleibt SWE-Rebench ein aktives Projekt, das kontinuierlich weiterentwickelt wird und weiterwächst. Es ist zu erwarten, dass mit der Zeit weitere Programmiersprachen, komplexere Interaktionsformen und neue Bewertungskriterien integriert werden, um den Wandel im Software-Engineering bestmöglich abzubilden. Nicht zuletzt zeigt der Ansatz von SWE-Rebench auch, wie wichtig es ist, beim Einsatz von KI-Technologie ethische und methodische Aspekte wie Datengüte, Objektivität und Transparenz zu wahren.

Nur so können nachhaltige Fortschritte erzielt werden, die langfristig innovative und verlässliche Software-Engineering-Agenten hervorbringen. Zusammenfassend lässt sich sagen, dass SWE-Rebench eine neue Ära im Bereich der KI-gestützten Softwareentwicklung einläutet, indem es realistische, interaktive Aufgaben in großem Umfang bereitstellt und damit eine valide sowie kontaminationsfreie Evaluation ermöglicht. Diese Grundlage wird Forschern wie Praktikern gleichermaßen helfen, die Potenziale von LLMs und ähnlichen Technologien im Software-Engineering noch effektiver auszuschöpfen und die automatisierte Programmierung auf ein neues Level zu heben.