Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) revolutioniert nicht nur den Bereich der allgemeinen Textverarbeitung, sondern hält zunehmend auch Einzug in die chemischen Wissenschaften. Während früher das Fachwissen und die Intuition von Chemikern unersetzlich schienen, offenbart sich heute eine spannende Debatte darüber, inwiefern LLMs die Expertise von erfahrenen Wissenschaftlern ergänzen oder gar übertreffen können. Dies wirft grundsätzliche Fragen zur Rolle von künstlicher Intelligenz in der Chemie auf – sowohl in der Forschung als auch in der Ausbildung. Große Sprachmodelle sind darauf trainiert, menschliche Sprache zu verstehen und zu generieren, wodurch sie auf eine breite Palette von Aufgaben zugreifen können, ohne speziell dafür programmiert worden zu sein. Schon jetzt zeigen führende Modelle, dass sie in der Lage sind, komplexe Prüfungen wie medizinische Lizenzprüfungen zu bestehen.

In der Chemie ermöglichen LLMs etwa die Vorhersage von Moleküleigenschaften, Reaktionsoptimierungen oder sogar die autonome Planung von Syntheseexperimenten durch Integration externer Tools wie Websuche und Analysewerkzeugen. Die Chemie als Wissenschaftsdisziplin zeichnet sich durch eine enorme Vielfalt komplexer und interdisziplinärer Aufgaben aus. Viele dieser Aufgaben erfordern nicht nur Faktenwissen, sondern tiefgehende logische Schlussfolgerungen und chemische Intuition, die traditionell bei humanen Forschern liegen. Gerade deshalb war die Frage, wie gut LLMs tatsächlich im Vergleich zu menschlichen Chemikern abschneiden, bisher schwer messbar. Das Fehlen geeigneter Benchmarking-Methoden und umfassender Evaluierungen erschwerte eine systematische Bewertung.

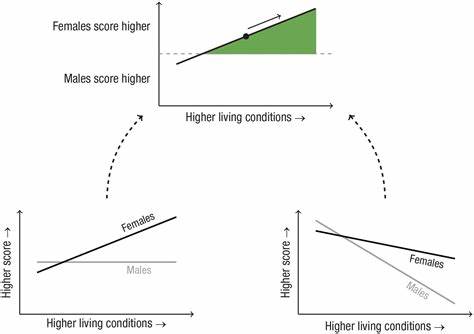

Mit der Einführung des ChemBench-Frameworks wird eine neue Benchmark geschaffen, die speziell für die chemischen Wissenschaften konzipiert ist und über 2700 Frage-Antwort-Paare aus einem breiten Spektrum chemischer Themen abdeckt. Dabei werden verschiedenste Bereiche vom Grundlagenwissen bis zur komplexen Problemlösung einbezogen, was vielfältige Denkfähigkeiten wie Wissenserwerb, logisches Schließen, Rechnungen und Intuition abfragt. Diese Vielfalt macht ChemBench zu einem robusten Maßstab, um die Fähigkeiten moderner LLMs zu prüfen und mit menschlichen Experten zu vergleichen. Die Analyse von Ergebnissen zeigt überraschende Befunde. Einige der besten Modelle übertreffen im Durchschnitt sogar die Leistung erfahrener Chemiker, die an der Studie teilnahmen.

Dabei zeigte sich besonders, dass die KI-Systeme bei vielen typischen Lehrbuchfragen oder standardisierten Testaufgaben hervorragend antworten können. Dies ist vor allem auf ihr breites Training mit riesigen Textmengen zurückzuführen, in denen Themen aus der Chemie umfangreich behandelt werden. Gleichzeitig gibt es aber deutlich erkennbare Schwächen der Modelle. Besonders Aufgaben, die tiefere chemische Schlussfolgerungen oder das Arbeiten mit speziellen Darstellungen chemischer Strukturen erfordern, stellen eine Herausforderung dar. Beispielsweise scheinen LLMs Schwierigkeiten zu haben, die Anzahl der verschiedenen Signale in einem Kernspinresonanzspektrum (NMR) korrekt zu bestimmen, was ein komplexes Verständnis von Molekülgeometrie und Symmetrie voraussetzt.

Ein weiterer interessanter Aspekt ist die Fähigkeit der Modelle, ihre eigene Zuverlässigkeit einzuschätzen. Idealerweise sollten Modelle signalisieren können, wenn sie unsicher oder eher falsch liegen. Untersuchungen zeigen jedoch, dass viele führende LLMs keine verlässlichen Unsicherheitsabschätzungen liefern und in manchen Fällen sogar übermäßig zuversichtlich in ihren Antworten sind. Dies birgt Risiken, vor allem wenn Nutzer – etwa Studierende oder Anwender außerhalb des Fachgebiets – die Auskünfte unkritisch übernehmen. Die Forschung betont auch den heterogenen Fortschritt innerhalb verschiedener chemischer Fachbereiche.

Während die allgemeine und technische Chemie in der Regel solide Ergebnisse liefern, bleiben insbesondere Felder wie die Toxikologie, chemische Sicherheit und analytische Chemie problematisch. Das spiegelt sich darin wider, dass die Modelle bestimmte Fragen nur unzureichend beantworten und spezielles Domänenwissen oder menschliche Erfahrung nach wie vor eine große Rolle spielen. Die Tatsache, dass LLMs bei der Bearbeitung von Fragen, die Intuition oder individuelle Präferenzen erfordern – zum Beispiel in der frühen Phase der Wirkstoffentwicklung – häufig nur zufällige Leistungen erzielen, zeigt, dass solche Modelle zwar schon viel gelernt haben, aber nicht die gleichen tieferen Wertungsmechanismen besitzen wie erfahrene Chemiker. Die Studie weist auch auf die Bedeutung besserer Trainingsdaten hin. Während reine Textquellen, wie wissenschaftliche Publikationen, für Grundlagenwissen hilfreich sind, benötigen LLMs für viele praktische Fragen den Zugriff auf spezialisierte Chemiedatenbanken.

Diese könnten den Modellen ermöglichen, tiefergehende Informationen zuverlässig abzurufen und damit besser in der Lage zu sein, Fragen zu beantworten, die über reines Faktenwissen hinausgehen. Für die chemische Ausbildung hat der Aufschwung von LLMs weitreichende Implikationen. Da Modelle heute viele Routineaufgaben, zum Beispiel das Abrufen von Fakten oder das Lösen standardisierter Probleme, schneller und oft auch zuverlässiger erfüllen können als Menschen, muss sich die Didaktik verändern. Der Fokus sollte stärker auf kritisches Denken, komplexe Problemlösung und kreative Forschungsarbeit gelegt werden. Die Art und Weise, wie Prüfungen gestaltet werden, und die Kompetenzen, die vermittelt werden, sollten neu diskutiert werden, da reine Faktenabfrage zunehmend durch KI-Instrumente ersetzt wird.

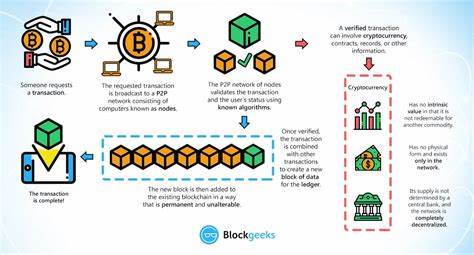

Zudem unterstreicht die Forschung die Notwendigkeit, den Einsatz von LLMs verantwortungsvoll zu gestalten. Die Möglichkeit, dass falsche oder übermäßig zuversichtliche Antworten zu sicherheitskritischen Fehlentscheidungen führen können, fordert sorgfältiges Monitoring und die Entwicklung von Modellen mit besserer Unsicherheitsabschätzung. Auch die Integration in „Copilot“-Systeme, die Wissenschaftler bei ihrer täglichen Arbeit unterstützen sollen, muss gut durchdacht werden, um Fehlinterpretationen zu vermeiden. Langfristig eröffnen die Fortschritte in der Kombination von LLMs mit spezialisierten chemischen Datenbanken und externen Tools wie Simulationen oder automatischen Experimentierrobotern neue Horizonte. Die Vorstellung von virtuellen Assistenten, die rund um die Uhr auf den gesamten Wissensschatz der Chemie zugreifen und intelligente Vorschläge für Synthesen oder Materialentwicklungen geben, kommt zunehmend in Reichweite.

Dies könnte Forschungsprozesse erheblich beschleunigen und die Innovationszyklen verkürzen. Die ChemBench-Benchmarking-Plattform stellt dabei ein wichtiges Instrument dar, um die Verbesserung der KI-Modelle systematisch zu verfolgen und sicherzustellen, dass die eingesetzten Systeme den Anforderungen der wissenschaftlichen Praxis gerecht werden. da sie eine möglichst realistische und detaillierte Einschätzung der tatsächlichen Fähigkeiten erlaubt und Schwachstellen offenlegt. Die Zusammenarbeit von KI-Forschern, Chemikern und Bildungsexperten wird entscheidend sein, um die Potenziale der Technik zu maximieren und Risiken zu minimieren. Ebenso wichtig ist der offene Austausch von Daten, Code und Evaluationsmethoden, um eine transparentere und reproduzierbare Entwicklung innovativer Werkzeuge zu fördern.

Zusammengefasst zeigen aktuelle Untersuchungen, dass große Sprachmodelle in der Chemie bereits menschliche Expertenkompetenz in vielen Bereichen erreichen oder übertreffen können. Dennoch bleiben fundamentale Herausforderungen bestehen, insbesondere bei der Verlässlichkeit, der komplexen chemischen Schlussfolgerung und der Präferenzfindung. Dies erfordert sowohl weitere Forschungsanstrengungen als auch eine neue Betrachtungsweise, wie Chemie gelehrt und praktiziert wird. Die Zukunft könnte durch ein hybrides Zusammenspiel von menschlicher Kreativität und KI-gestützter Rechenkraft gekennzeichnet sein – eine Entwicklung, auf die sich Fachleute und Lernende gleichermaßen einstellen müssen.