Die chemische Wissenschaft gilt als eine der komplexesten Disziplinen der Naturwissenschaften, in der es nicht nur um das Wissen über Moleküle und Reaktionen geht, sondern auch um die Fähigkeit zu komplexem Denken, Schlussfolgern und Intuition. Mit dem Aufkommen großer Sprachmodelle (Large Language Models, LLMs) hat sich ein vollkommen neues Kapitel aufgeschlagen, das die Art und Weise, wie chemisches Wissen generiert, verarbeitet und angewandt wird, grundlegend verändern könnte. In den letzten Jahren haben LLMs, basierend auf neuronalen Netzwerken und trainiert auf riesigen Mengen an Textdaten, erstaunliche Fortschritte gezeigt. Sie sind in der Lage, Sprache nicht nur zu verstehen, sondern auch kreativ zu erzeugen, komplexe Fragen zu beantworten und sogar wissenschaftliche Probleme zu lösen, die ursprünglich als Domäne menschlicher Expertise galten. Im Vergleich zu klassischen maschinellen Lernmethoden, die oft auf spezifische Ziele oder Datenformate zugeschnitten sind, bieten LLMs eine Flexibilität, die vielfältige Anwendungen in der Chemie und Materialwissenschaft ermöglicht.

Doch wie steht es wirklich um die chemischen Kenntnis- und Denkfähigkeiten dieser Modelle im Vergleich zu erfahrenen Chemikern? Können Maschinen Wissen wirklich „verstehen“ oder nur imitieren? Und welche Auswirkungen hat das auf Forschung, Lehre und Sicherheit in der Chemie? Ein wegweisender Rahmen zur Bewertung dieser Fragen wurde vor Kurzem mit dem ChemBench vorgestellt, einem speziell entwickelten Benchmarking-Tool, das über 2700 Frage-Antwort-Paare aus Bereichen der Chemie umfasst und die Leistung von großen Sprachmodellen systematisch mit der von menschlichen Chemieexperten vergleicht. Dabei zeigte sich, dass die besten Modelle oft die durchschnittlichen Chemiker in puncto korrekter Antworten übertreffen – eine Erkenntnis, die das Potential und zugleich die Grenzen der KI-Technologie illustriert. Die Stärke der LLMs liegt vor allem in ihrer Fähigkeit, große Textmengen zu verarbeiten und Muster zu erkennen. Gerade in der Chemie, wo ein Großteil des Wissens in wissenschaftlichen Veröffentlichungen, Lehrbüchern und Datenbanken textuell vorliegt, ermöglichen LLMs einen schnellen Zugriff auf relevantes Wissen. Dies eröffnet beispielsweise Chancen für sogenannte Chemie-Copilot-Systeme, die Forscher bei Experimenten, Literaturrecherche oder sogar bei der Generierung neuer Hypothesen unterstützen.

Eine zentrale Herausforderung bleibt jedoch, wie gut die Modelle tatsächlich „verstehen“, was sie ausgeben – ein Problem, das sich in der teils fehlenden Fähigkeit zeigt, ihre eigenen Unsicherheiten zu erkennen. Viele Modelle neigen dazu, selbstbewusst falsche Antworten zu geben, was gerade bei sicherheitsrelevanten Themen oder der Bewertung chemischer Risiken problematisch ist. Eine weitere Erkenntnis aus dem ChemBench-Projekt betrifft die Differenzen zwischen der Leistung bei unterschiedlichen Chemiethemen. Während Modelle beispielsweise in allgemeinen und technischen Chemiefeldern gut abschneiden, zeigen sich Schwächen in spezialisierten Bereichen wie der analytischen Chemie oder der Toxikologie. Besonders die Fähigkeit, komplexere chemische Strukturen wie Moleküle anhand ihres SMILES-Codes zu analysieren und daraus etwa die Anzahl von NMR-Signalen vorherzusagen, stellt eine Herausforderung dar, die sogar viele menschliche Experten vor Schwierigkeiten stellt.

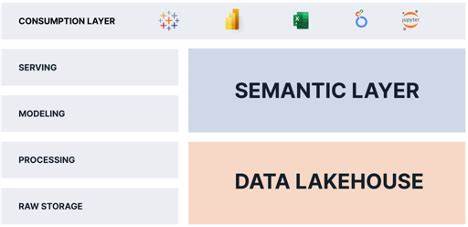

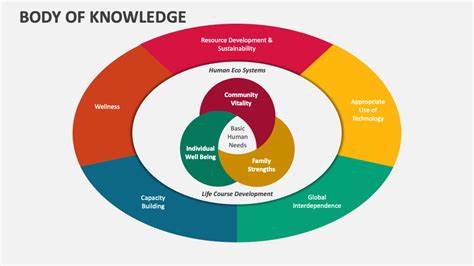

Dieses Defizit weist darauf hin, dass LLMs oft weniger durch echtes, strukturelles Verständnis als vielmehr durch die Nähe zu Trainingsdaten motiviert agieren – sie lernen also nicht „nachzudenken“, sondern assoziieren vorhandenes Wissen. Die Integration von externen Chemiedatenbanken und Tools, wie etwa PubChem oder spezialisierte Sicherheitsdatenbanken, könnte hier Abhilfe schaffen und die Modelle gezielter mit relevanten Informationen versorgen. Solche hybriden Systeme, die LLMs als Kern mit fachlicher Datenbankanbindung kombinieren, könnten zukünftig nicht nur zuverlässigere Antworten liefern, sondern auch als vertrauenswürdige Hilfsmittel im Labor dienen. Dabei wird es essenziell sein, neben der reinen Wissensvermittlung auch die Argumentations- und Entscheidungsfähigkeit der Modelle zu stärken, damit diese tatsächlich als kompetente Assistenten fungieren können. Im Vergleich zeigt sich auch, dass menschliche Chemiker zwar bei einzelnen Fragestellungen überlegen sind, vor allem wenn tiefgreifendes Spezialwissen und kreative Problemlösung gefragt sind, LLMs jedoch besonders bei schnellem Faktenabruf und dem Lösen von Routineaufgaben punkten.

Ein weiterer beachtenswerter Punkt ist, dass LLMs aufgrund ihres Trainings auf umfangreichen Datenmengen inzwischen sogar in der Lage sind, auf Examensfragen zu bestehen, die für Menschen eine mühsame Vorbereitung erfordern. Dies stellt Bildungseinrichtungen vor die Herausforderung, Lehr- und Prüfungsformate anzupassen. Rotes Auswendiglernen wird zunehmend obsolet, während kritisches Denken und die Entwicklung von Intuition wichtiger werden. Neben fachlichen Aspekten gibt es auch ethische und sicherheitstechnische Fragen, die mit der Nutzung von LLMs in chemischen Anwendungen verbunden sind. Während die Modelle helfen können, Abläufe zu optimieren und Wissen breiter verfügbar zu machen, besteht auch das Risiko eines Missbrauchs, etwa bei der Entwicklung gefährlicher Substanzen.

Die Chemie-Community sowie Entwickler von KI-Systemen stehen deshalb in der Verantwortung, klare Richtlinien und Kontrollmechanismen zu etablieren, um schädliche Nutzung einzudämmen. Zusammenfassend lässt sich sagen, dass große Sprachmodelle das Potential besitzen, den wissenschaftlichen Alltag in der Chemie grundlegend zu verändern. Sie ergänzen das Wissen von Experten, übernehmen monotonere Aufgaben und eröffnen neue Möglichkeiten zur Beschleunigung von Forschung und Entwicklung. Trotz ihrer teilweise beeindruckenden Leistungen sind die Modelle jedoch keine vollwertigen Ersatzlösungen für menschliche Expertise – sie haben nach wie vor Lücken, insbesondere bei komplexer Argumentation und Unsicherheitsabschätzung. Um das volle Potential auszuschöpfen, sind weitere Forschungen notwendig, die auf eine bessere Integration von strukturiertem Fachwissen, verbessertes Verständnis molekularer Strukturen und eine transparente Einschätzung von Unsicherheiten setzen.