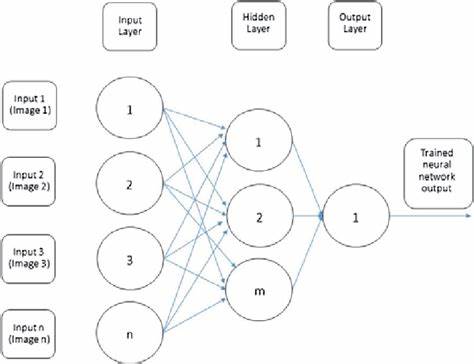

Die Entwicklung großer Sprachmodelle, bekannt als Large Language Models (LLMs), hat in den letzten Jahren die Landschaft der Künstlichen Intelligenz revolutioniert. Was einst als akademisches Forschungsfeld begann, wird heute von Unternehmen, Forschungseinrichtungen und Start-ups weltweit genutzt, um intelligente Anwendungen zu entwickeln, die unser tägliches Leben und Arbeiten tiefgreifend verändern. Doch was steckt genau hinter dem Aufstieg der LLMs, welche Herausforderungen begleiten diese Technologien und welche Trends dominieren gerade? Ein genauer Blick auf die Entwicklungen zeigt die Kraft, aber auch die Komplexität dieser innovativen Modelle. LLMs basieren auf tiefen neuronalen Netzwerken, die riesige Mengen an Textdaten analysieren und daraus Muster erkennen. Dies befähigt sie, menschenähnliche Texte zu generieren, Aufgaben zu übersetzen, Fragen zu beantworten oder komplexe Zusammenhänge zu erklären.

OpenAI galt lange Zeit als Vorreiter, doch inzwischen konkurrieren zahlreiche Unternehmen um die beste Technologie, was zu einer rasanten Beschleunigung in Forschung und Produktentwicklung führt. Ein zentrales Thema in der Diskussion um LLMs ist der Wettbewerb zwischen offenen und proprietären Modellen. Während OpenAI seine Modelle wie GPT vor allem als kommerzielle Lösungen anbietet, gewinnt die Bewegung für offene Modelle zunehmend an Bedeutung. Diese „Open Weight AI“-Modelle bieten Transparenz und erlauben Anpassungen durch die Entwicklergemeinschaft, was wiederum Innovationen fördert. Gleichzeitig stellt der offene Zugang auch Herausforderungen in Sachen Sicherheit und Missbrauchsprävention dar.

Die Motivation, spezialisierte Modelle zu entwickeln, entspringt dem Bedürfnis, die Leistung und Effizienz zu steigern. Allgemeine Sprachmodelle sind mächtig, aber oft große Ressourcenfresser. Spezialisierte LLMs, die auf bestimmte Branchen oder Aufgaben zugeschnitten sind, erlauben es, mit weniger Rechenkapazität präzisere Ergebnisse zu erzielen. Dies ist etwa im Gesundheitswesen oder juristischen Bereich von enormer Bedeutung, wo exakte und kontextbezogene Antworten gefragt sind. Ein weiterer relevanter Aspekt ist der Einsatz von Rechenleistung vor und nach dem Training.

Pre-Training benötigt immense Infrastruktur und Energie, da Modelle mit Milliarden von Parametern über Monate hinweg trainiert werden. Im Vergleich dazu ermöglicht das sogenannte Fine-Tuning (Nachtraining) auf spezifische Anwendungsfälle eine effizientere Nutzung der Ressourcen und eine Anpassung an individuelle Anforderungen. Unternehmen investieren daher stark in optimierte Hardwarelösungen und innovative Algorithmen, um die Effizienz zu verbessern und nachhaltiger zu arbeiten. Die Frage, ob OpenAI mit seinen Angeboten den Markt dominieren wird, bleibt aktuell unter Forschern und Industrieexperten stark diskutiert. Die enorme finanzielle und technische Ausstattung von OpenAI ist ein Vorteil, doch der Innovationsdruck durch offene Modelle und neue Player erhöht die Dynamik im Feld.

Das Rennen um die besten und zugänglichsten LLM-Agenturen ist somit in vollem Gange. Parallel zu technologischen Entwicklungen verändert sich auch die Auffassung davon, wie KI-Produkte gestaltet werden. Immer mehr Erkenntnisse aus der Praxis zeigen, dass reine Nutzung von LLMs nicht automatisch zu einzigartigen oder nachhaltigen Produkten führt. Produktentwickler sind gefordert, KI sinnvoll zu integrieren, Nutzerdaten zu schützen und echten Mehrwert zu schaffen. Differenzierung im Markt wird zunehmend durch kluge Kombination von KI, Benutzererfahrung und domänenspezifischem Wissen erzielt.

Die Infrastruktur hinter LLMs ist ein weiterer entscheidender Faktor. Neben der Menge der verfügbaren Daten entscheidet vor allem die Qualität und Organisation der Rechenzentren sowie die Skalierbarkeit der Systeme über den Erfolg. Cloud-Dienste und spezialisierte KI-Hardware eröffnen Möglichkeiten, die vor wenigen Jahren noch undenkbar waren. Dies ermöglicht Anwendungen von Sprachmodellen in Echtzeit und in bisher nicht gekannter Breite. Neben der wirtschaftlichen Perspektive gibt es auch ethische und gesellschaftliche Fragen, die parallel zur technischen Entwicklung diskutiert werden.

Der verantwortungsvolle Einsatz von LLMs, Schutz vor Desinformation, Wahrung der Privatsphäre und der Einfluss auf Arbeitsmärkte stehen im Fokus öffentlicher Debatten. Transparenz und Regulierung gewinnen hier an Bedeutung, um die Potenziale von LLMs auszuschöpfen und Risiken zu minimieren. Langfristig gesehen wird die Kombination aus spezialisierten LLMs, kontinuierlicher Verbesserung der Trainingsprozesse und einem wachsenden Ökosystem von Anwendungen die KI-Landschaft nachhaltig prägen. Unternehmen, die frühzeitig auf diese Trends reagieren und eigene Kompetenzen aufbauen, werden in der Lage sein, innovative Produkte zu entwickeln und Wettbewerbsvorteile zu sichern. Die Reise der LLMs hat gerade erst begonnen.

Mit der zunehmenden Verfügbarkeit leistungsfähiger Modelle, wachsendem Interesse an Open-Source-Alternativen und immer breiteren Anwendungsfeldern dürfte die Rolle der großen Sprachmodelle in den kommenden Jahren noch bedeutender werden. Sie sind nicht nur ein Werkzeug für die Automatisierung und Vereinfachung komplexer Aufgaben, sondern auch ein Motor für neue Geschäftsmodelle und technologische Durchbrüche in der Künstlichen Intelligenz.