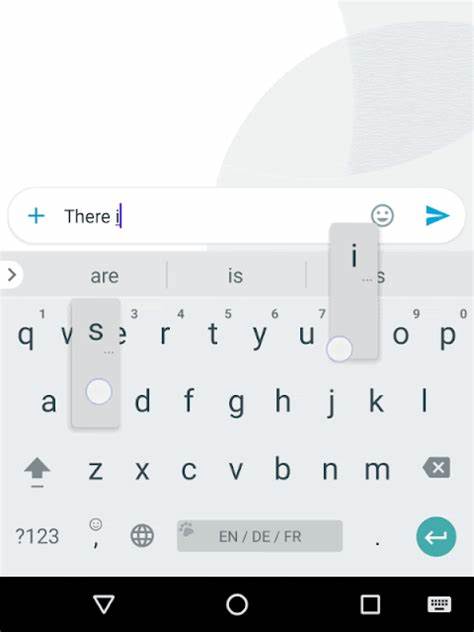

Das Tippen auf mobilen Geräten ist heute ein zentraler Bestandteil unseres digitalen Alltags. Ob beim Verfassen von Nachrichten, E-Mails oder Beiträgen in sozialen Netzwerken – Millionen Menschen nutzen täglich virtuelle Tastaturen. Dennoch ist das Tippen auf Touchscreens oft deutlich langsamer und fehleranfälliger als auf herkömmlichen physischen Tastaturen. Die durchschnittliche Geschwindigkeit eines Nutzers ist etwa 35 Prozent geringer. Vor diesem Hintergrund hat Google Gboard kontinuierlich weiterentwickelt, eine intelligente und vielseitige Tastaturanwendung, die durch den Einsatz von maschineller Intelligenz das Tipp-Erlebnis nachhaltig verbessert und die Eingabe deutlich effizienter gestaltet.

Ein Blick hinter die Kulissen zeigt, welche Technologien und Algorithmen diese Fortschritte möglich machen. Dabei spielt die Verbindung von Erkenntnissen aus der Sprach- und Mustererkennung eine entscheidende Rolle. Die Idee, dass die Art und Weise, wie eine Mobilgerät-Tastatur Berührungen in Text übersetzt, Ähnlichkeiten zur Umwandlung von Sprache in Text aufweist, war Ausgangspunkt für eine innovative Herangehensweise. Google nutzte seine Erfahrung aus der Spracherkennung, um robuste Modelle zu entwickeln, die räumliche Eingaben auf der Tastatur präzise interpretieren. Diese sogenannten neuronalen räumlichen Modelle verwenden komplexe Algorithmen, um unschärfere oder fehlerhafte Tippbewegungen zu korrigieren und das tatsächlich beabsichtigte Wort zu erkennen.

Typische Fehler beim mobilen Tippen entstehen nicht nur durch sogenannte "Fat Fingers", also wenn Nutzer mehrere nahe beieinander liegende Tasten berühren, sondern auch durch kognitive und motorische Abweichungen, die zu Vertauschungen, Auslassungen oder Einfügungen von Zeichen führen. Die Herausforderung bestand darin, diese Fehlerquellen zu identifizieren und auf der Ebene einzelner Zeichen zu modellieren, damit das System die Eingaben vorausschauend interpretieren kann. Früher setzte Gboard hierfür einfache Gaussian-Modelle ein, die Wahrscheinlichkeiten für das Treffen benachbarter Tasten berechneten. Zusätzlich gab es regelbasierte Ansätze zur Erkennung kognitiver Tippfehler. Diese Methoden waren verständlich, aber limitiert, weil sie keine direkte Optimierung auf die Qualität der Tippvorhersage erlaubten.

Aus dem Bereich der Spracherkennung stammt das leistungsfähige Konzept des Long Short-Term Memory Netzwerks (LSTM), eine spezielle Form von rekurrenten neuronalen Netzwerken, die besonders gut Probleme mit Zeitreihen und Sequenzen lösen können. Google ersetzte daher die alten Modelle mit einem einzigen, hochoptimierten LSTM-Modell, das mit einer Verbindungskonzept-basierten zeitlichen Klassifizierung (Connectionist Temporal Classification, CTC) trainiert wurde. Dieses Modell ist in der Lage, komplexe Abfolgen von Berührungspunkten auf dem Bildschirm effizient und akkurat zu interpretieren und somit Fehler beim Tippen stark zu reduzieren. Das Training eines solchen Modells stellte eine immense Herausforderung dar, da es keine mühsam transkribierten Datensätze für Tastatureingaben gibt, wie es sie beispielsweise für Audio-Transkriptionen gibt. Stattdessen nutzte das Team semi-supervisiertes Lernen basierend auf realen Benutzerinteraktionen: Automatisch rückgängig gemachte Korrekturen und ausgewählte Vorschläge dienten als negative beziehungsweise positive Signale, um Trainings- und Testdaten zu generieren.

Durch die Kombination von Techniken aus der Spracherkennung und modernem maschinellen Lernen wurden die neuronalen Modelle so optimiert, dass sie auf mobilen Geräten flüssig und schnell laufen. Die Modelle wurden dabei nicht nur zehnmal kleiner, sondern auch sechsmal schneller, was sie energieeffizient und praktisch für den Alltag machte. Gleichzeitig konnte die Fehlerquote bei Autokorrekturen um rund 15 Prozent verringert werden, und Fehlinterpretationen von Gleitbewegungen („Glide Typing“) sanken um etwa 10 Prozent auf Testdatensätzen, die offline ausgewertet wurden. Doch die räumlichen Modelle allein können nicht alle Aspekte des Tippens abdecken, denn Sprache verfügt über vielfältige lexikalische und grammatikalische Regeln. Wörter haben eine bestimmte Wahrscheinlichkeit, in einem Satz aufzutreten, und die Reihenfolge der Wörter folgt oft festen Mustern.

Um diese komplexen Zusammenhänge zu erfassen, setzt Gboard Finite-State Transducers (FST) ein. Diese mathematischen Modelle stammen aus der Sprachverarbeitung und bieten die Möglichkeit, Wahrscheinlichkeitsmodelle für Wörter, Phrasen und Kombinationen formal abzubilden. Ein wichtiges Einsatzgebiet ist die effektive Darstellung von Lexika, also dem Vorrat an Wörtern einer Sprache sowie von Wahrscheinlichkeitsmodellen, die bestimmen, wie wahrscheinlich es ist, dass ein bestimmtes Wort nach einem anderen folgt (n-Gramm-Modelle). Über die FST können komplexe Tastatureingabemuster mit diesen Sprachmodellen verknüpft und so die Wahrscheinlichkeit verschiedener Wortfolgen bewertet werden. Das erlaubt eine wesentlich intelligentere Auswahl von Vorschlägen und korrigiert nicht nur buchstabenbezogene Fehler sondern auch inhaltliche Fehler oder ungewöhnliche Wortfolgen.

Die mathematische Strenge von Finite-State Transducers verleiht dem Gboard-Decoder dabei auch die nötige Flexibilität. So ist es beispielsweise möglich, dass Nutzer Wörter ohne explizites Tippen der Leertaste eingeben können, indem Leerraumübergänge in den Modellen optional definiert sind. Ebenso sind alternative Schreibweisen oder wortbildende Varianten einfach in die Modelle einbaubar. Für Sprachen mit komplexeren Schriftsystemen und Schriften, die auf lateinische Buchstaben transliteriert werden, hat Google spezielle Transliterationsmodelle entwickelt. In Indien erlaubt Google mit Gboard Nutzern seit einiger Zeit, Wörter in 22 offiziellen indischen Sprachen per transliteriertem Tastaturlayout einzugeben.

Dabei wird ein lateinisches Tastatur-Layout verwendet, das automatisch in die jeweilige Schriftsprache umgewandelt wird. So können Nutzer beispielsweise Hindi über Lateinbuchstaben eingeben, und das System wandelt die Eingabe in Devanagari-Zeichen um. Dieses Konzept ist auch bei der chinesischen Pinyin-Tastatur bekannt, die aus einer phonetischen Umschrift chinesische Schriftzeichen generiert. Die Herausforderung bei der Transliteration besteht darin, dass viele Sprachen verschiedene legitime Schreibweisen für denselben Begriff haben. Die Modelle von Gboard berücksichtigen diese Unsicherheiten und adaptieren sich entsprechend flexibel.

Die generalisierte Natur von Finite-State Transducers erlaubt es, die zuvor entwickelten Funktionen wie Wortvervollständigungen oder Gleitbewegungen problemlos auf diese transliterierten Eingaben anzuwenden. Durch die Kombination von neuronalen Modellen für räumliche Erkennung, robusten FST-basierten Sprachmodellen und flexiblen Transliterationsmechanismen ist Gboard heute in der Lage, eine Vielzahl von Eingabeszenarien effizient und intuitiv zu bedienen. Zudem wurden durch diese Fortschritte entscheidend die Latenzzeiten reduziert, sodass Eingaben fast in Echtzeit verarbeitet werden, was für den Nutzer spürbar das Tippgefühl verbessert. Trotz aller Fortschritte gibt es weiterhin Herausforderungen. Die automatische Texterkennung ist weder perfekt, noch wird sie auf absehbare Zeit vollständig fehlerfrei arbeiten.

Gelegentlich erscheinen noch Vorschläge, die nicht ganz passend sind oder Gleitgesten werden missinterpretiert. Doch der Wechsel zu stärker algorithmisch intelligenten Methoden eröffnet einen weiten Spielraum, um das Tipp-Erlebnis immer weiter zu verbessern und an die Bedürfnisse einer globalen Nutzerbasis anzupassen. Die Entwicklungen im Bereich maschineller Intelligenz sind für Produkte wie Gboard ein Spielplatz innovativer Forschung und Anwendung. Die Kombination von fundiertem Wissen aus Spracherkennung, natürlicher Sprachverarbeitung und maschinellem Lernen sorgt dafür, dass Gboard ständig neue Funktionen erhält und die Eingabe auf mobilen Geräten dadurch sowohl schneller als auch angenehmer wird. Schließlich ermöglicht das offene Framework von Gboard auch die Forschungsgemeinschaft, mit eigenen Beiträgen und Projekten diese Technologien weiterzuentwickeln und so auch in Zukunft neue Standards für Tastatur- und Eingabetechnologien zu setzen.

Zusammenfassend wurde mit Gboard eine Tastatur geschaffen, die weit über ein herkömmliches Eingabegerät hinausgeht und maßgeblich durch maschinelle Intelligenz geprägt ist. Von neuronalen räumlichen Modellen für präzise Tippinterpretationen über Finite-State Transducer basierte Sprachmodelle bis hin zu vollständiger Multilingualität und Transliteration – das innovative System stellt einen Meilenstein im mobilen Computing dar, der die Nutzung von Smartphones und Tablets einfacher, schneller und intuitiver macht. Welche weiteren Innovationen uns in Zukunft erwarten, bleibt spannend, doch eines ist sicher: Die Verbindung von maschinellem Lernen und Tastaturtechnologie wird das Schreiben auf mobilen Geräten noch lange prägen.