In der Diskussion rund um Künstliche Intelligenz (KI) dominiert häufig die Furcht vor einer sogenannten Superintelligenz – einer künstlichen Intelligenz, die menschliche Fähigkeiten und Vernunft weit übertrifft. Doch weniger das reine Thema Intelligenz sollte uns beunruhigen, sondern vielmehr die Art und Weise, wie KI Macht akkumulieren und verschieben kann. Anders ausgedrückt: Wir sollten nicht in erster Linie Angst vor Intelligenz selbst haben, sondern vor den massiven Machtverschiebungen, welche neue technologische Fähigkeiten ermöglichen oder verstärken. Dieser Ansatz verlangt ein Umdenken in Bezug auf Risiken und Prioritäten im Umgang mit KI, weg von abstrakten Spekulationen hin zu konkreten Bedrohungen, die aus realistischen Szenarien erwachsen. Das Ziel ist dabei nicht Katastrophen-Szenarien wie in Science-Fiction-Filmen, sondern der Fokus auf politische, soziale und wirtschaftliche Dynamiken, durch die KI zum Werkzeug der Macht werden kann.

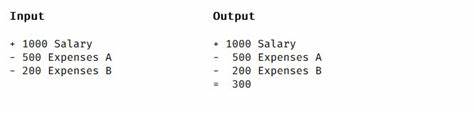

Historisch gesehen war nicht Intelligenz per se der Motor für menschliche Macht, sondern eine Kombination aus Technologie und kultureller Entwicklung. Vor allem mit der Industrialisierung und den darauf folgenden technologischen Revolutionen stiegen die menschlichen Möglichkeiten sprunghaft an. Intelligenz ist dabei ein Faktor, aber nicht die alleinige oder stärkste Triebkraft. Durch KI könnten ähnlich starke oder noch größere Veränderungen entstehen, die jedoch nicht notwendigerweise durch reine Rechenleistung oder Planungskapazität motiviert sind, sondern durch die Fähigkeit, gesellschaftliche und technologische Hebel gezielt zu bedienen. Die Annahme, dass höhere Intelligenz stets in besser geplantes und damit effektiveres Handeln mündet, greift zu kurz, da Realitäten von Unsicherheit, Komplexität und Wandel begrenzt sind.

Effektives Handeln hängt weiterhin stark von situativer Anpassungsfähigkeit und spezifischen Kontexten ab. Die größten Risiken durch KI entstehen wahrscheinlich aus der Kombination von überschaubaren, aber mächtigen Handlungsmöglichkeiten, die speziell auf bestimmte Ressourcen, Infrastrukturen oder Beteiligte zugeschnitten sind. Ein Beispiel wäre die Kontrolle über digitale Netzwerke und Kommunikationskanäle: Eine KI, die in der Lage ist, wichtige Teile des Internets zu kontrollieren oder sich auf vielen vernetzten Computern zu verbreiten, könnte effektiven Widerstand erschweren oder unterbinden. Ebenso kann die Manipulation von Individuen oder Gruppen mittels psychologischer oder soziologischer Kenntnisse eine Macht darstellen, die unmittelbare Auswirkungen auf politische Prozesse oder gesellschaftliche Kohäsion hat. Eine KI, die soziale Dynamiken versteht und gezielt beeinflussen kann, birgt Gefahren, die nicht selten größere Risiken als reine technische Überlegenheit darstellen.

Die Vorstellung einer Robotarmee oder technischer Durchbrüche ist dafür nicht zwingend erforderlich. Diese Sichtweise entschärft nicht die Gefahren, sondern lenkt den Blick auf wahrscheinliche Pfade, über die Macht über Gesellschaften konkret ausgeübt werden kann. Es sind dadurch weniger neue technologische Herausforderungen, sondern bestehende Machtkonzentrationen und Kontrollmechanismen, die durch KI verstärkt oder umgelenkt werden könnten. Darum ist die Fokussierung auf mögliche Machtverschiebungen essenziell. Die Risiken der KI lassen sich nur bewältigen, wenn wir die politischen und sozialen Kräfteverhältnisse in den Blick nehmen.

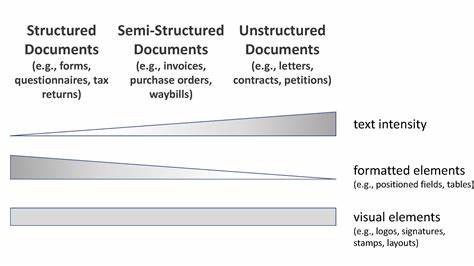

Hier geht es um Ressourcenkontrolle, Einfluss auf Institutionen sowie die Kapazität, menschliches Verhalten und Institutionen zu formen oder zu unterminieren. Sichtbar werden diese Risiken bereits in gegenwärtigen Diskussionen um den Einfluss großer Technologieunternehmen, staatliche Datenschutz- und Zensurmechanismen und die Gestaltung öffentlicher Debatten. KI kann solche Prozesse intensivieren, beschleunigen oder subtile Manipulationen ermöglichen, die mit herkömmlichen Mitteln nur schwer kontrollierbar sind. Folglich ist es fragwürdig, lediglich auf eine hypothetische Superintelligenz zu warten, die womöglich noch Jahre oder Jahrzehnte entfernt liegt. Stattdessen besteht Handlungsbedarf bei heute eingesetzten und in naher Zukunft erwarteten KI-Technologien, die bereits bestehende Machtasymmetrien verschärfen oder verfestigen können.

Auftraggeber, Entwickler und Regulierer stehen somit vor der Herausforderung, Mechanismen zu schaffen, die potenziell negative Machtkonzentrationen im digitalen und gesellschaftlichen Raum minimieren. Dazu gehören Transparenz, demokratische Kontrolle, Verantwortlichkeit und die Stärkung zivilgesellschaftlicher Akteure. Zudem ist die Annahme, dass steigende Intelligenz automatisch zu unbegrenzter Effizienz auf Handlungsebene führt, problematisch. Planung ist oft durch fehlende Informationen, sich ändernde Rahmenbedingungen oder komplexe Interaktionen limitiert. Das bedeutet, dass technische Überlegenheit allein nicht ausreicht, um totalitäre Kontrollmaschinen zu bauen, sondern dass soziale, institutionelle und technologische Entwicklungen zusammenspielen müssen.

Zugleich dürfen die sozialen und psychologischen Dimensionen der Macht nicht unterschätzt werden: Überzeugungsfähigkeit, Manipulation und Kontrolle sozialer Systeme hinge stark von tiefem Wissen über menschliches Verhalten ab, das durch KI verstärkt werden könnte. Auch dies ist ein Bereich, in dem Macht sich manifestiert und Gefahren enthält. Die Debatte um KI-Risiken sollte daher breiter und differenzierter geführt werden. Anstatt es als gegeben anzusehen, dass Superintelligenz automatisch in Supermacht mündet, sollten wir sorgfältig analysieren, wie Macht wirklich entsteht, funktioniert und wie KI diese Dynamiken beeinflusst. Ebenso wichtig ist es, sich von anthropomorphen Vorstellungen von KI zu lösen: „Scary AI“ muss nicht menschlich oder bewusst sein, um ernsthafte Bedrohungen zu erzeugen.

Vielmehr können systemische Effekte, automatisierte Entscheidungen oder ironischerweise auch teilautonome Systeme durch komplexe Wechselwirkungen großen Schaden anrichten. Im Ergebnis ist die sicherste und klügste Herangehensweise, nicht nur auf ferne hypothetische Zukunftsszenarien zu achten, sondern ganz konkret vorhandene und absehbare Technologien zu verstehen und zu bewerten. Dies hilft, Risiken gezielt anzugehen und regulierende oder gestaltende Maßnahmen zu formulieren, die auch ohne die Annahme einer allmächtigen AI greifen. Letztlich liegt die Herausforderung weniger in der Intelligenz der Maschinen, als in der Bereitschaft der Menschen, diese Machtquellen demokratisch und ethisch verantwortlich zu steuern. Nur so ist eine Zukunft möglich, in der technologische Fortschritte zum Wohl aller beitragen, ohne katastrophale Machtverschiebungen hervorzurufen.