Die Entscheidung, eine bestehende Datenbankarchitektur zu wechseln, fällt in der Regel nicht leicht. Besonders wenn es um die Migration von verteilten Systemen wie CockroachDB hin zu traditionellen relationalen Datenbanken wie PostgreSQL geht, spielen zahlreiche technische, finanzielle und organisatorische Aspekte eine wichtige Rolle. Die fließende Entwicklung im Bereich Datenbanksysteme sowie der konkrete Praxisbezug haben Motion, ein junges Unternehmen, dazu bewogen, diesen Schritt zu gehen – mit spannenden Erkenntnissen und hilfreichen Erfahrungen, die sich hervorragend als Orientierung für andere Unternehmen eignen. Seit Anfang 2022 nutzte Motion CockroachDB als Datenbanksystem. Die Vorteile der Plattform lagen vor allem in der unkomplizierten horizontalen Skalierung und der nahtlosen Unterstützung für Multi-Region-Setups, ein oft geforderter Aspekt im Zuge der europäischen Datenschutzgrundverordnung (DSGVO).

Ebenfalls punktete CockroachDB mit hoher Verfügbarkeit und einem SQL-kompatiblen Interface, das den Einstieg erleichterte. Doch mit dem Wachstum des Unternehmens stiegen auch die Kosten und die Komplexität der Betriebsführung. Bis zum Jahr 2024 erreichte die Abrechnung für CockroachDB ein Niveau von mittleren sechsstelligen Beträgen – eine Größenordnung, die viele Unternehmen zum Umdenken bewegt. Interessanterweise hatten die Kunden von Motion noch keine explizite Anforderung an Datenlokalisierung gestellt und die Nutzung erfolgte in einer einzigen Region mit relativ einfachen, transaktionalen Anfragen. Die Frage stand also im Raum, ob der Betrieb einer verteilten Datenbank in diesem Fall noch sinnvoll ist oder ob die Kosten-Nutzen-Bilanz nicht eine andere Datenbank bevorzugen würde.

Die Herausforderung mit CockroachDB zeigte sich vor allem bei der Anwendung von Migrationen. Das eingesetzte Object-Relational Mapping Tool (ORM) Prisma reagierte immer häufiger mit Timeouts beim Versuch, Migrationen durchzuführen. Die Folge war ein erheblicher Mehraufwand an manuellen Eingriffen direkt in CockroachDB, wobei Migrationen sequentiell und mit viel Aufwand durchgeführt wurden, um eine blockierte Anwendung zu verhindern. Oft waren Deployments für mehrere Stunden blockiert und eine reibungslose Update-Prozedur wurde stark behindert. Ein großer Vorteil war, dass das Team dank des ORMs relativ unkompliziert einen direkten Vergleich der Migrationen zwischen CockroachDB und PostgreSQL testen konnte.

Ein anwendungsnahes Beispiel zeigte deutlich, dass die gleiche Migration auf PostgreSQL innerhalb von nur zehn Sekunden durchgeführt werden konnte, während CockroachDB regelmäßig minutenlange Timeouts und Fehler verursachte. Die Operationen wurden unter Zeitdruck schnell zu einem Risiko, etwa wenn Entwickler aus Angst vor systemweiten Sperren begannen, Geschäftslogik ohne DB-Migrationen zu implementieren – was langfristig zu technischem Schuldenaufbau führte. Auch das Upgrade auf neuere Versionen von CockroachDB wurde durch die stetigen Migrationstimeouts erschwert. Die Firma blieb auf einer veralteten Version 22 sitzen, was die Reaktionszeiten im Support verschlechterte und die Innovationsfähigkeit begrenzte. Letztlich entschied man sich, diesen Zustand zu akzeptieren und stattdessen einen vollständigen Wechsel zu PostgreSQL vorzunehmen.

Die Probleme beschränkten sich nicht nur auf Migrationen. Auch ETL-Jobs (Extract, Transform, Load) waren von Timeouts betroffen. Airbyte, als einziger verfügbarer Connector für CockroachDB, befand sich 2024 noch im Alpha-Stadium und litt unter gravierenden Speicherlecks, was regelmäßige Ausfälle verursachte. Die Folge waren ausgelöste Alarmmeldungen und manueller Aufwand, der nicht skalierbar war. Zudem zeigten Performancemessungen, dass die Verarbeitung selbst bei erfolgreichem Durchlauf sehr langsam ablief.

Für Unternehmen, die auf stabil laufende Datenpipelines angewiesen sind, ein klares Warnsignal. Interessant war die Gegenüberstellung der Performance bei Abfragen. Manche Queries führten CockroachDB schneller aus – dank eines leistungsfähigen Optimierers, der bestimmte Aggregationen effizienter durchführen konnte. Doch dies war eher die Ausnahme als die Regel. In vielen Szenarien zeigte PostgreSQL auf den realen, komplexen Anfragen von Motion die deutlich bessere Performance.

Ein Beispiel verdeutlichte, dass manche Abfragen auf PostgreSQL bis zu zwanzigmal schneller liefen als auf CockroachDB. Der Grund dafür lag unter anderem in der Art und Weise, wie das ORM Prisma komplexe SQL-Statements generierte. Bei CockroachDB sorgten verschachtelte Joins, mehrere bedingte Filter sowie teilweise unsaubere Konstruktionen wie „AND 1=1“ für einen übermäßigen Full-Table-Scan. Dies führte zu einer unnötigen Belastung des verteilten Systems und langen Latenzen, während PostgreSQL diesen Scanfaktor vermeiden konnte. Auch im Bereich der Benutzerfreundlichkeit zeigten sich mit CockroachDB immer wieder kleine Hindernisse.

Die Sichtbarkeit und das Monitoring von Indizes etwa war trügerisch, da regelmäßig vermeintlich ungenutzte Indizes angezeigt wurden, die in Wirklichkeit aktiv verwendet wurden. Dies führte bei Entwicklern manchmal zu falschen Entscheidungen mit potenziell negativen Folgen für die Abfrageperformance. Darüber hinaus war das Abbrechen laufender Abfragen in der CockroachDB-Umgebung komplizierter als in PostgreSQL. Das Verteilen der Anfragen auf mehrere Nodes im Cluster erforderte ein komplexes Eingreifen über die Cockroach-Konsole – mit ungewissem Ausgang, da nicht immer alle Teilprozesse zuverlässig beendet wurden. Der Support von CockroachDB erwies sich für Motion als nur bedingt hilfreich.

Der Zugriff auf das Support-Portal gestaltete sich umständlich, weil es eine separate Authentifizierung erforderte und bekannte Informationen immer wieder neu eingegeben werden mussten. Im kritischen Moment, als ein Bug den Betrieb beeinträchtigte, war die Reaktionszeit von etwa einer Woche zu lang. Ein zusätzlicher Schmerzpunkt waren die häufigen Verbindungsprobleme, die sich als sporadische und schwer vorhersehbare DNS-Fehler bei der Kommunikation mit CockroachDB äußerten. Diese Probleme traten in allen Umgebungen von Motion auf – von der Continuous Integration bis zu lokalen Tools – und konnten nie vollständig gelöst werden. PostgreSQL hingegen zeigte sich in diesem Punkt als stabil und zuverlässig.

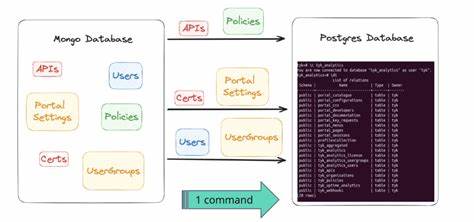

Die Migration selbst stellte eine besondere Herausforderung dar. Mit einer Datenmenge von cirka 100 Millionen Datensätzen in der größten Tabelle wurde ein zuverlässiges Tool für den Datenexport dringend benötigt. Da keine ausgereiften ETL-Lösungen für CockroachDB verfügbar waren, entschied sich der Entwickler, ein eigenes Skript mit der damals aufstrebenden Plattform Bun zu schreiben. Dieses Skript zerlegte die Datenbank in ihre Tabellen, exportierte die Inhalte als CSV-Dateien und importierte die Daten parallel und gestreamt wieder in PostgreSQL. Während der Tests zeigte sich jedoch, dass CockroachDB bei typen wie JSON oder Arrays eine leicht unterschiedliche Byte-Kodierung verwendete.

Darauf musste reagiert werden, um Datenqualität und Anwendungsfunktionalität zu gewährleisten. Es folgte die Implementierung einer umfänglichen CSV-Parsingschicht, die diese Unterschiede aufhob, ohne die Sichtbarkeit für die Anwender zu verändern. Am Tag der eigentlichen Migration wurde die größte verfügbare virtuelle Maschine bei Google Cloud Platform genutzt, um den Importprozess zu beschleunigen. Schließlich wurden alle Maßnahmen sorgfältig geplant, indem Motion in den Wartungsmodus versetzt wurde und der Datenimport ohne Unterbrechung durchgelaufen ist. Der gesamte Prozess dauerte weniger als 15 Minuten – eine beachtliche Leistung bei der immensen Datenmenge.

Post-Migration zeigte sich schnell der Mehrwert: Die aggregierten Latenzen sämtlicher Anfragen sanken um ein Drittel und dank des nachhaltigen PostgreSQL-Ökosystems konnten innerhalb kürzester Zeit weitere Leistungsoptimierungen vorgenommen werden. Tools wie PGAnalyze halfen dabei, nicht optimierte Anfragen aufzudecken und zu verbessern. Finanziell bedeutete der Wechsel für Motion eine Einsparung von mehr als 110.000 US-Dollar pro Jahr, eine Summe, die sich angesichts des zu erwartenden Wachstums noch vervielfachen dürfte. Aus den Erfahrungen lassen sich zentrale Erkenntnisse ableiten.

Zunächst ist der Einsatz einer verteilten Datenbank wie CockroachDB nur dann wirklich sinnvoll, wenn ein Mehrwert – etwa durch zwingende Multi-Region-Anforderungen oder stark ausgebaute Skalierungsszenarien – gegeben ist. Für viele Transaktionsanwendungen mit regionaler Nutzung kann PostgreSQL eine effizientere, stabilere und kostengünstigere Alternative bieten. Die Bedeutung eines durchdachten Migrationsprozesses, der neben Datentransfer auch Kompatibilitäts- und Performanceaspekte adressiert, kann nicht hoch genug eingeschätzt werden. Die Kombination eines flexiblen ORMs und moderner Scripting-Tools ermöglicht heute relativ unkomplizierte Wechsel zwischen Datenbanksystemen, die noch vor wenigen Jahren als “große Baustellen” galten. Nicht zuletzt zeigt Motion eindrucksvoll, dass ein durchdachter Wechsel auch mit minimaler Ausfallzeit und ohne Datenverluste erfolgen kann – ein wichtiges Argument für Unternehmen und Entwickler, die sich bisher vor einem Wechsel gescheut haben.

Die erzielten Kostenvorteile und die verbesserte Performance zahlen sich dabei schnell aus und schaffen Spielräume für weiteres Wachstum und Innovation. Unternehmen, die vor einer ähnlichen Entscheidung stehen, sollten die technischen Vor- und Nachteile ihrer gewählten Datenbanken genau abwägen, Migrationstools frühzeitig evaluieren und vor allem die langfristigen Kosten- und Wartungsaspekte berücksichtigen. Zudem ist kontinuierliches Monitoring und Performance-Tuning nach dem Wechsel essentiell, um optimale Ergebnisse auf der neuen Plattform sicherzustellen. PostgreSQL zeigt sich im aktuellen Vergleich als erwachsene, performante und entwicklerfreundliche Lösung mit umfangreichem Ökosystem, das viele Stolpersteine in der Anwendung und Wartung umlaufen beziehungsweise lösen kann. Für viele Use Cases, insbesondere wenn keine geografisch verteilte Datenhaltung zwingend erforderlich ist, bietet sich daher ein Umstieg auf PostgreSQL als erfolgversprechende Strategie an.

Der Erfahrungsbericht von Motion schafft hier wertvolle Orientierung, veranschaulicht typische Stolpersteine und macht Mut, den Umstieg mutig aber wohlüberlegt anzugehen. Die Möglichkeit, Migrationen agil und pragmatisch durchzuführen – zum Beispiel durch selbst entwickelte ETL-Pipelines – zeigt die Reife heutiger Toollandschaften und ermöglicht einen fließenden Übergang ohne den gewohnten Produktionsalltag auszubremsen. Zusammenfassend ist der Wechsel von CockroachDB zu PostgreSQL ein praxisnahes Beispiel dafür, wie Unternehmen datenbankseitig effizienter, günstiger und robuster aufgestellt sein können. Er zeigt, dass technische Innovation und Kosteneffizienz durch sorgfältige Evaluierung, Planung und Umsetzung keine Gegensätze sind, sondern sich bestens ergänzen.