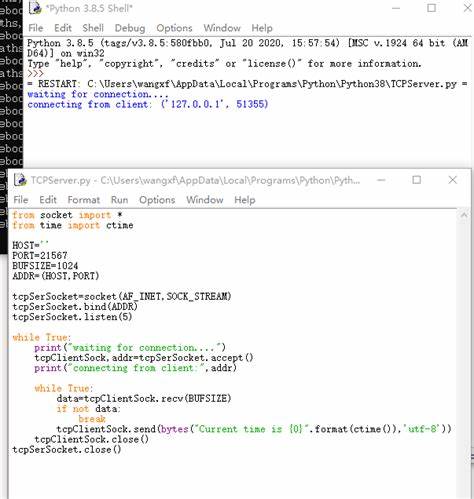

Die immer komplexer werdenden Softwareanwendungen und die steigende Nachfrage nach fehlerfreien Programmen stellen Entwickler vor neue Herausforderungen. Traditionelle Ansätze der automatischen Programmreparatur stoßen dabei häufig an ihre Grenzen, da sie Programme als diskrete Mengen von Symbolen betrachten und so nur begrenzt auf das tatsächliche Verhalten des Codes eingehen können. Ein wegweisender Paradigmenwechsel zeichnet sich nun ab: Die gradientenbasierte Programmreparatur (Gradient-Based Program Repair, GBPR), die Programmbugs nicht mehr in einem symbolischen, sondern in einem kontinuierlichen, differenzierbaren Raum behandelt. Dieser innovative Ansatz verspricht, Fehler viel zielgerichteter und effizienter zu beheben und eröffnet damit eine neue Ära der Softwarequalitätssicherung. Im Kern basiert die gradientenbasierte Programmreparatur auf der Idee, symbolische Programme in numerische Darstellungen zu übersetzen, die sich kontinuierlich und differenzierbar verändern lassen.

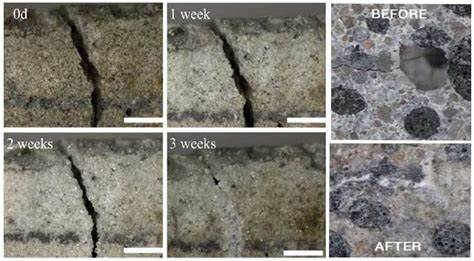

Dadurch wird aus der klassischen, diskreten Suche nach der korrekten Lösung eine Optimierungsaufgabe in einem kontinuierlichen Raum. Die Programme werden quasi in Vektoren oder Matrizen übertragen, deren Elemente mithilfe von Gradientenverfahren systematisch angepasst werden können, um Fehler zu korrigieren. Dies ermöglicht erstmals einen direkten Bezug zwischen Programmänderungen und deren Auswirkungen auf das Programmverhalten, eine Verbindung, die zuvor kaum in automatisierter Form nutzbar war. Die Vorteile dieser neuen Methode sind vielfältig. Während herkömmliche automatisierte Programmreparaturen oft auf heuristischen Suchalgorithmen oder symbolischer Manipulation basieren, erlaubt die Differenzierbarkeit des numerischen Programmraums eine zielgerichtete und mathematisch fundierte Verbesserung von fehlerhaftem Code.

Gradientbasierte Optimierungsverfahren steuern die Anpassungen direkt auf die Minimierung von Fehlermetriken hin, etwa durch die Reduktion von Testfehlern oder unerwünschten Laufzeitverhalten. Dadurch werden Reparaturprozesse nicht nur schneller, sondern auch robuster und zuverlässiger, insbesondere bei komplexen oder schwer greifbaren Fehlerarten. Ein bedeutender Meilenstein auf diesem Forschungsgebiet ist die Einführung von RaspBugs, einem umfangreichen Benchmark-Datensatz, der mehr als 1.466 fehlerhafte Programme in der symbolischen Programmiersprache RASP und deren numerische Entsprechungen umfasst. Dieses Korpus ermöglicht es Forschern, die Leistung gradientenbasierter Reparaturmethoden systematisch zu evaluieren und mit bestehenden Ansätzen zu vergleichen.

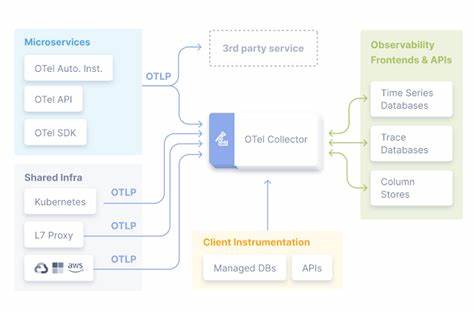

Erste experimentelle Ergebnisse zeigen eindrucksvoll, wie GBPR fehlerhafte Programme erfolgreich durch kontinuierliche Optimierung korrigieren kann, wobei die Reparaturverläufe nachvollziehbar und konvergent bleiben. Die Verbindung von kontinuierlicher Optimierung und Programmverhalten öffnet zudem Türen zu interdisziplinären Synergien. Hier treffen moderne Techniken aus dem maschinellen Lernen, insbesondere Differenzierbarkeit und Gradientenverfahren, auf klassische Herausforderungen der Programmanalyse und Softwaretechnik. Dies ermöglicht etwa, gradiertenbasierte Reparaturen nicht nur bei fest definierten Testfällen, sondern auch in dynamischen Entwicklungskontexten einzusetzen, wo kontinuierliches Feedback und adaptive Anpassungen essentiell sind. Die theoretischen Grundlagen der GBPR basieren auf der Umformulierung der Programmsemantik in differentiable Strukturen.

Anstatt Programme als rein diskrete Aneinanderreihungen von Anweisungen zu betrachten, wird ein Programm zu einem numerischen Objekt, das sich vor dem Hintergrund von Kostenfunktionen, wie Fehlerraten oder Laufzeitverhalten, schrittweise optimieren lässt. Dabei sind Differenzierbarkeit und eine geeignete Wahl des numerischen Programmdesigns entscheidend, um Gradienten berechnen und effektiv nutzen zu können. Die Herausforderung liegt darin, die Programmlogik möglichst genau und gleichzeitig kompakt in diese numerische Form zu übertragen, ohne den Bezug zur ursprünglichen Symbolik zu verlieren. In der Praxis eröffnen sich durch GBPR neue Anwendungen jenseits der bloßen Fehlerkorrektur. So können kontinuierliche Spielräume zur Anpassung von Programmen genutzt werden, um Performance-Optimierungen oder Sicherheitsverbesserungen automatisiert durchzuführen.

Auch die Integration in Entwicklungswerkzeuge erscheint vielversprechend, um Entwickler in Echtzeit mit intelligenten Vorschlägen zu unterstützen und die Softwarequalität entlang des gesamten Lebenszyklus zu verbessern. Trotz der vielversprechenden Potenziale steht die gradientenbasierte Programmreparatur noch am Anfang ihrer Entwicklung. Wichtige Fragen betreffen etwa die Skalierbarkeit auf großformatige und komplexe Softwaresysteme, die Robustheit gegenüber verschiedenen Arten von Bugs und die Vereinbarkeit mit existierenden Programmiersprachen und Frameworks. Zudem erfordert die praktische Nutzung eine besondere Sorgfalt bei der Modellierung der Kostenfunktionen und der Auswahl der numerischen Repräsentation, um sinnvolle und überprüfbare Reparaturen zu gewährleisten. Zukunftsweisende Forschungsrichtungen konzentrieren sich darauf, GBPR mit fortgeschrittenen Techniken des maschinellen Lernens zu kombinieren, um automatisierte Reparatursysteme zu konstruieren, die aus Daten lernen und sich selbst verbessern können.

Zudem könnten hybridansätze entstehen, die symbolische und kontinuierliche Suchverfahren verbinden, um das Beste aus beiden Welten zu vereinen. Ein weiterer spannender Ansatz ist die Nutzung differentieller Programmierung, bei der Programme nicht nur in ihrer Repräsentation differentiabel sind, sondern auch in ihrem Ausführungsverhalten, was neue Formen der Programmoptimierung und -analyse ermöglicht. Für Unternehmen und Entwickler bringt die Entwicklung von GBPR einen echten Mehrwert. Die Möglichkeit, fehlerhafte Programme automatisiert und mit mathematischer Präzision zu verbessern, reduziert den Aufwand bei der Fehlersuche und -behebung erheblich. Gleichzeitig wird die Fehlerquote in der produktiven Software gesenkt, was Ausfallzeiten und Kosten minimiert.