Die Leistungsfähigkeit von Speichersystemen spielt heute eine entscheidende Rolle für die effiziente Arbeitsweise von datenintensiven Anwendungen und Datenbanken. Insbesondere die Geschwindigkeit, mit der Schreibvorgänge durchgeführt werden, kann in vielen Szenarien zum Engpass werden. Eine der wesentlichen Methoden, die Integrität und Dauerhaftigkeit von Schreibvorgängen zu gewährleisten, ist die Nutzung des Systemaufrufs fsync. Doch wie gut lässt sich die IOPS-Leistung eines einzelnen Speichermediums allein anhand der Werte von fsync bestimmen? In modernen Datenbanksystemen spielt fsync eine zentrale Rolle für die Sicherstellung, dass Daten tatsächlich auch physisch auf dem Speichermedium angekommen sind, bevor ein Transaktionsabschluss bestätigt wird. Dabei wirkt sich fsync direkt auf die Latenzzeit eines Schreibvorgangs aus, da es zwingend auf die physische Bestätigung des Schreibvorgangs wartet.

Diese Wartezeit gestaltet sich oft als der dominante Latenzanteil bei Schreibprozessen. Daraus lässt sich die Vermutung ableiten, dass die maximale Häufigkeit, mit der fsync aufgerufen werden kann, einen signifikanten Einfluss auf die Gesamttransaktionsrate eines Systems hat. Wenn wir uns die Messung von IOPS anschauen, ist klar, dass diese Kennzahl angibt, wie viele einzelne Ein- und Ausgabeoperationen pro Sekunde ein Speichermedium bewältigen kann. Das heißt: Theoretisch könnte man glauben, IOPS einfach als Kehrwert der durchschnittlichen fsync-Latenz abzuleiten. Doch die Realität ist weitaus komplexer.

Fsync kann rein sequenziell betrachtet beispielsweise eine Dauer von rund vier Millisekunden pro Operation haben, so wie es bei bestimmten Amazon EBS gp2 Volumes der Fall ist. Das ergibt eine theoretische IOPS-Grenze von ungefähr 250. Dennoch zeigen Tests, dass solche Systeme in der Praxis deutlich höhere Werte erzielen können, was auf interne Parallelisierung oder Aggregation von Schreibvorgängen hindeutet. Die Speicherlösung Amazon EBS bietet mit ihren gp2 Volumes ein interessantes Feld zur Untersuchung. Diese Volumes basieren auf SSD-Technologie und bieten eine skalierbare IOPS-Leistung, die von der Größe des Volumes abhängt.

So startet jedes gp2 Volume mindestens mit 100 IOPS, gefolgt von einem linearen Anstieg von 3 IOPS pro Gigabyte Speicherplatz, bis zu einer Obergrenze von 16.000 IOPS. Zudem existiert eine Burst-Kapazität für Volumes unter 1000 GB, mit der temporär bis zu 3.000 IOPS erzielt werden können. Diese Abstufungen erlauben es, die Leistungsfähigkeit in unterschiedlichen Größenordnungen zu testen und zu vergleichen.

Messungen der fsync-Latenz auf einem 1600 GB großen gp2-Volume zeigen zum Beispiel eine Rekordlatzenz von etwa 4,25 Millisekunden je fsync-Aufruf. Wenn man dies strikt nimmt, könnte man nur etwa 235 fsyncs pro Sekunde abwickeln. Angesichts der erwarteten Kapazität von etwa 4.800 IOPS für diese Volume-Größe ist es offensichtlich, dass Systeme in der Praxis viele fsync-Aufrufe parallel oder durch Zwischenpufferung bündeln, um höhere Leistung zu erreichen. Solche Mechanismen ermöglichen, die Latenz einzelner Operationen zwar nicht direkt zu verringern, aber dennoch insgesamt mehr Schreibvorgänge pro Sekunde durchzuführen.

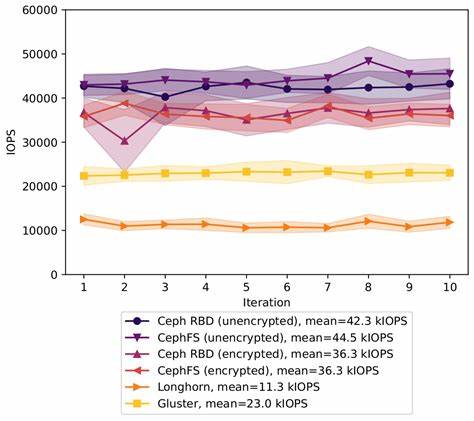

Zur detaillierten Analyse werden häufig Tools wie fio (Flexible I/O Tester) verwendet, die komplexe und realitätsnahe I/O-Workloads simulieren können. Mit einem typischen Szenario von zufälligen 4 KB-Schreibvorgängen und aktiviertem fsync nach jedem Schreibvorgang können realistische Anwendungssituationen nachgestellt werden. Hier zeigt sich, dass bei einem iodepth (der Anzahl an parallelen I/O-Anfragen) von eins, fsync-Latenzen im Bereich von knapp 4 Millisekunden und IOPS von etwa 250 realistisch sind. Aber sobald die Anzahl paralleler Anfragen erhöht wird, steigt die IOPS-Leistung fast linear, bis die vom Speicher bereitgestellte Obergrenze nahekommt. Generell bleiben Latenzwerte für niedrigere iodepth-Werte stabil und es können entsprechend mehr Operationen pro Sekunde geschafft werden.

Interessanterweise erhöht sich die Gesamtlatenz erst, wenn das System an seine Leistungsgrenze stößt. Bei Volumes mit höherer Basiskapazität, wie etwa einem 5500 GB gp2-Volume, sind Messungen mit iodepth-Werten von bis zu 400 durchgeführt worden. Dabei zeigt sich die maximale IOPS-Leistung von 16.000. Die Latenz nimmt jedoch kontinuierlich zu, wenn man sich diesem Limit nähert, da der Speicher zunehmend ausgelastet wird und Anfragen verzögert bearbeitet werden müssen.

Diese Messungen bestätigen, dass die reine Betrachtung von fsync-Latenzzeiten für die Abschätzung der maximalen IOPS nicht ausreicht. Moderne Speichersysteme organisieren I/O-Vorgänge oft so, dass mehrere fsync-Operationen gleichzeitig abgewickelt oder gebündelt werden, was eine höhere Gesamtdurchsatzrate ermöglicht. Dies erklärt, warum ein einfaches Umkehren der fsync-Dauer zu einer groben Unterschätzung der wahren IOPS-Fähigkeit führt. Auf den praktischen Einsatz bezogen bedeutet das, dass Systemadministratoren und Entwickler, die Speichersysteme hinsichtlich ihrer eigenen Workloads bewerten möchten, nicht nur auf einzelne fsync-Messungen vertrauen sollten. Vielmehr ist es wichtig, die Systeme mit realen oder realistischen Workloads unter verschiedenen Lastbedingungen zu testen, um die echte Leistung zu bestimmen.

Dabei kann die Kontrolle der iodepth-Parameter wertvolle Erkenntnisse über das Verhalten bei parallelen Zugriffen geben, welches in produktiven Umgebungen häufig vorkommt. Die Bedeutung solcher umfangreichen Leistungsanalysen steigt mit dem Einsatz von Cloud-basierten Speicherdiensten. Gerade hier bieten Hersteller wie Amazon die Möglichkeit, durch variable Volumengrößen und damit verbundene Leistungsstufen flexibel auf unterschiedliche Anforderungen zu reagieren. Die Kenntnis darüber, wie fsync und IOPS miteinander agieren, unterstützt Kunden bei der Wahl der passenden Storage-Konfiguration und beim Verstehen von Leistungsengpässen. Zusammenfassend lässt sich sagen, dass fsync als ein Indikator für die Geschwindigkeit eines einzelnen Schreibvorgangs dient, jedoch keine verlässliche einfache Methode darstellt, um das gesamte IOPS-Potenzial eines Speichermediums abzuschätzen.

Die tatsächlichen IOPS-Ergebnisse basieren auf komplexeren Mechanismen wie Parallelisierung und Puffern, die intern implementiert sind und in der Praxis einen wichtigen Beitrag zur Leistungsverbesserung leisten. Daher sollten Benchmarking-Tools und praxisnahe Tests zur Anwendung kommen, wenn es um fundierte Aussagen zur Leistungsfähigkeit von Speichersystemen geht. Wer sich mit der Performance-Optimierung von datenintensiven Anwendungen auseinandersetzt, kommt an der genauen Kenntnis von IOPS und fsync-Latenzen nicht vorbei. Ein einfaches Pendant von IOPS aus der inversen fsync-Zeit zu errechnen, reicht nicht, um fundierte Entscheidungen treffen zu können. Vielmehr bedarf es umfassender Erkenntnisse und Daten, um Speicherlösungen effizient auszuwählen und zu betreiben.

So eröffnet das Verständnis dieser Zusammenhänge die Möglichkeit, Engpässe frühzeitig zu erkennen und die Basis für eine stabile und schnelle datenverarbeitende Infrastruktur zu schaffen.