In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) wie GPT-3, GPT-4 und ihre Nachfolger das Feld der künstlichen Intelligenz revolutioniert. Ihre Fähigkeit, menschenähnliche Texte zu generieren, hat sowohl in der Wissenschaft als auch in der breiten Öffentlichkeit für großes Aufsehen gesorgt. Ein Kernpunkt der Diskussion rund um LLMs ist die Frage, ob diese Modelle lediglich hochentwickelte Autovervollständiger sind oder ob sie tatsächlich eine tiefere Form von Verständnis und Intelligenz besitzen. Diese Debatte ist nicht nur aus technischer Sicht relevant, sondern berührt auch ethische, gesellschaftliche und philosophische Fragestellungen über das Wesen von Intelligenz und Kreativität. Autovervollständigung ist eine Technologie, die viele Menschen bereits aus ihrem Alltag kennen – sei es beim Schreiben von E-Mails, SMS oder beim Verwenden von Suchmaschinen.

Dabei schlägt eine KI sensible und kontextbezogene Wortvervollständigungen vor, um den Schreibprozess zu beschleunigen und zu vereinfachen. Große Sprachmodelle erweitern dieses Prinzip enorm, indem sie nicht nur einzelne Wörter oder kurze Phrasen vorhersagen, sondern komplexe, kohärente Absätze mit syntaktisch und semantisch sinnvollem Inhalt generieren können. Daraus folgt die Frage: Bedeutet das schon „Verstehen“ oder handelt es sich doch nur um eine ausgefeilte Mustererkennung? Technisch gesehen basieren LLMs auf tiefen neuronalen Netzwerken und einem Training mit riesigen Textkorpora aus dem Internet, Büchern, Artikeln und anderen Quellen. Während des Trainings werden statistische Muster gelernt, die es der KI ermöglichen, aus einem gegebenen Textinput den wahrscheinlichsten Folgetext zu generieren. Dieses Vorgehen ähnelt einer extrem komplexen Autovervollständigung.

Allerdings sind die Muster extrem vielschichtig, umfassen semantische Zusammenhänge, stilistische Merkmale und kontextbezogene Abhängigkeiten. Das Modell kann sogar komplexe Fragestellungen beantworten oder original Inhalte erzeugen, was weit über das reine Vervollständigen von Sätzen hinausgeht. Kritiker argumentieren jedoch, dass LLMs trotz ihrer beeindruckenden Leistungen letztlich keine echte Bedeutung verstehen oder ein Bewusstsein besitzen. Sie liefern zwar plausible und oft beeindruckend glaubwürdige Inhalte, aber diese basieren auf Wahrscheinlichkeiten und nicht auf einem echten Verständnis. Das stützt die Auffassung, dass LLMs glorifizierte Autovervollständigungssysteme sind.

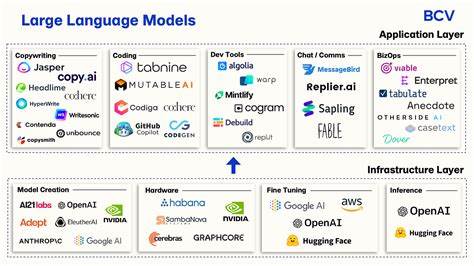

Dieser Standpunkt gewinnt insbesondere in Hinblick auf Fälle an Bedeutung, in denen die Modelle Fehler machen oder inkohärente Informationen generieren, was dazu führt, dass sie „halluzinieren“ – also falsche Fakten präsentieren, die überzeugend klingen. Befürworter hingegen sehen in den Fortschritten und der Anwendungsbreite von großen Sprachmodellen einen Paradigmenwechsel. Sie betonen, dass menschliches Verstehen auch auf der Mustererkennung beruht und dass LLMs durch ihre Fähigkeit, selbstständig Texte zu schreiben, Fragen zu beantworten und kreative Werke zu schaffen, eine Form von Intelligenz aufweisen, die über reine Autovervollständigung hinausgeht. Zudem werden LLMs mittlerweile in komplexen Anwendungsszenarien eingesetzt, die von juristischer Beratung über medizinische Diagnosen bis hin zu kreativen Designprozessen reichen. Ein weiterer Aspekt der Debatte betrifft die ethische Verantwortung im Umgang mit LLMs.

Die Tatsache, dass diese KI-Systeme keine eigenen Entscheidungsmechanismen besitzen und ausschließlich auf Daten basieren, die von Menschen bereitgestellt wurden, wirft Fragen zu Verzerrungen, Manipulation und der Verbreitung von Fehlinformationen auf. Der Grad, in dem ein Modell Fähigkeiten aufweist, die über Autovervollständigung hinausgehen, bestimmt auch, welche Vorsichtsmaßnahmen und Regulierungen notwendig sind, um Missbrauch zu verhindern. Auch die gesellschaftlichen Auswirkungen sind nicht zu unterschätzen. Große Sprachmodelle verändern zahlreiche Berufsbilder, beeinflussen die Art und Weise, wie wir kommunizieren und Informationen verarbeiten. Dabei sind sie gleichzeitig Werkzeuge und Herausforderungen.

Sie sollen die Kreativität und Produktivität steigern, gleichzeitig besteht die Gefahr, dass menschliche Fähigkeiten verkümmern, wenn KI-Systeme zu sehr als Ersatz angesehen werden. Zusammenfassend lässt sich sagen, dass die Frage, ob LLMs mehr als Autovervollständigung sind, komplex und vielschichtig ist. Technisch basieren sie auf einem erweiterten Prinzip der Autovervollständigung, besitzen aber aufgrund ihrer enormen Datenbasis und Architektur die Fähigkeit, kontextreiche und kreative Inhalte zu produzieren. Ob dies als echte Intelligenz oder nur als fortgeschrittene Simulation gewertet wird, hängt von der jeweiligen Definition von Verstehen und Bewusstsein ab. Klar ist, dass LLMs heute weitaus mehr leisten, als wir von herkömmlicher Autovervollständigung gewohnt sind, und sie das Potenzial haben, viele Bereiche unseres Lebens zu verändern.

Die laufende Debatte wird entscheidend dafür sein, wie wir diese Technologien künftig nutzen und regulieren.