In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) wie GPT und zahlreiche Open-Source-Varianten die Aufmerksamkeit von Forschern und der breiten Öffentlichkeit gleichermaßen auf sich gezogen. Ihre beeindruckenden Fähigkeiten in diversen Aufgabenbereichen wie Mathematik, Wissenschaft und Programmierung lassen sie als wegweisende Technologien erscheinen. Doch hinter den imposanten Zahlen und vermeintlichen Fortschritten verbirgt sich eine Herausforderung, die immer deutlicher zu Tage tritt: Die Überbewertung der Denkfähigkeiten dieser Modelle durch das Design der Evaluationsverfahren. Ein neuer Forschungsbeitrag mit dem Titel "Evaluation is All You Need: Strategic Overclaiming of LLM Reasoning Capabilities Through Evaluation Design" beleuchtet genau diesen Sachverhalt und zeigt auf, wie kleine, oft übersehene Variationen im Bewertungsprozess die Leistungsbewertungen großer Sprachmodelle erheblich verzerren können. Diese Erkenntnisse werfen wichtige Fragen über die Verlässlichkeit aktueller Benchmark-Ergebnisse auf und fordern eine grundlegende Neubewertung und Standardisierung der Evaluationsmethoden.

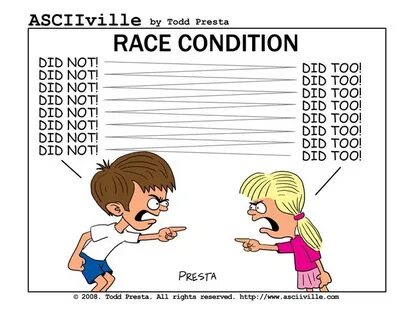

Die Untersuchung konzentriert sich insbesondere auf die sogenannten Deepseek-R1-Distill Modelle, die in der Open-Source-Community für ihre starken Fähigkeiten in Bereichen wie Mathematik, Naturwissenschaften und Programmierung bekannt geworden sind. Gerade diese Modelle werden zunehmend als Maßstab für Fortschritte im Bereich des Sprachverständnisses und der Problemlösung angesehen. Doch die Studie zeigt, dass die Ergebnisse der Benchmark-Tests dieser Modelle starken Schwankungen unterliegen, die dadurch verursacht werden, dass verschiedene Evaluationseinstellungen leicht verändert werden. Solche Veränderungen können schon minimale Anpassungen bei der Auswahl von Datensatzversionen, der Reihenfolge von Antwortoptionen oder der initialen Zufallswerte (Seeds) sein, die häufig kaum Beachtung finden. Doch diese scheinbar kleinen Unterschiede führen zu erheblichen Variationen in den gemessenen Leistungswerten.

Diese empirischen Beobachtungen offenbaren eine Problematik, die bisher in der Diskussion um KI-Modelle wenig Beachtung fand: Die Bewertungsmethoden selbst sind ein entscheidender Faktor, der die Ergebnisse maßgeblich beeinflusst. Das bedeutet, dass die in vielen Studien präsentierten Leistungssteigerungen nicht zwingend auf tatsächlichen Fortschritten in den Modellen basieren, sondern auch durch vorteilhafte Evaluationsbedingungen zustande kommen können. Ein besonders relevantes Beispiel sind Multiple-Choice-Fragen, bei denen die Reihenfolge der Antwortoptionen oder die Platzierung von Instruktionen einen messbaren Einfluss auf die erzielten Punktewerte haben. Diese Faktoren können eine Verschiebung in den Ergebnissen um mehrere Prozentpunkte bewirken – ein signifikantes Ausmaß in der Modellbewertung. Besonders auffällig ist zudem, dass die bereits erwähnten Schwankungen nicht nur bei den Deepseek-R1-Distill Modellen auftreten, sondern auch bei anderen Open-Source-Modellen, die auf ihnen basieren oder von ihnen abgeleitet sind, sowie bei größeren, weniger häufig untersuchten Modellen wie dem QwQ-32B.

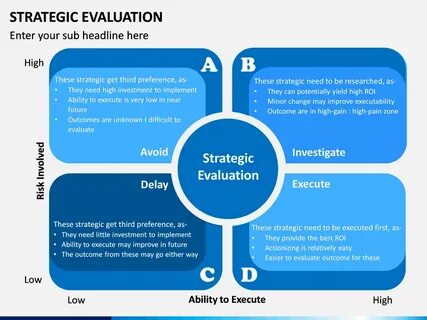

Dies spricht für ein strukturelles Problem, das in der Evaluationspraxis selbst verankert ist. Das Fehlen einer standardisierten und transparenten Evaluationsmethodik führt demnach zu einem Zustand, in dem Vergleiche zwischen Modellen unzuverlässig und schwer reproduzierbar werden. Trotz des starken Interesses an objektiven Leistungsbewertungen ist die Praxis weit davon entfernt, diese Ziele zu erfüllen. Das bedeutet auch, dass Forscher und Entwickler häufig Schwierigkeiten haben, reale Fortschritte von zufälligen Schwankungen oder günstigen Bewertungskonstellationen zu unterscheiden. Vor diesem Hintergrund fordert die Studie deutliche Maßnahmen zur Verbesserung der Evaluationspraxis.

Im Kern plädieren die Autoren für die Einführung von festen Zufallswerten (Seeds), ausführlicher Dokumentation aller Evaluationsparameter sowie die Angabe von statistischen Konfidenzintervallen und Durchschnittswerten anstelle von Spitzenergebnissen. Diese Vorgehensweise soll helfen, mehr Transparenz und Verlässlichkeit in die Benchmark-Ergebnisse zu bringen und somit eine solide Basis für echte Fortschrittsbewertungen zu schaffen. Darüber hinaus sprechen sich die Forscher für die Entwicklung und Anwendung standardisierter Evaluationsframeworks aus, die klare Richtlinien zur Durchführung und Auswertung von Tests geben. Eine offene Offenlegung aller verwendeten Einstellungen soll sicherstellen, dass die Ergebnisse nachvollziehbar und reproduzierbar bleiben – ein unverzichtbarer Schritt für die wissenschaftliche Integrität und langfristige Weiterentwicklung der KI-Technologien. Diese Erkenntnisse haben weitreichende Implikationen für die KI-Community.

Zum einen wird deutlich, wie kritisch der Faktor Evaluationsdesign für die Interpretation von Modellfähigkeiten ist. Ohne einheitliche und rigorose Bewertungsmaßstäbe lässt sich der tatsächliche Fortschritt kaum beurteilen, sodass Unternehmen, Entwickler und Anwender sich stets bewusst sein müssen, dass Leistungsangaben mit Vorsicht zu genießen sind. Zum anderen unterstreicht die Arbeit, dass ein strategisches Übertreiben der Leistungsfähigkeit durch geschicktes, aber möglicherweise nicht bewussterweise manipulierendes Evaluationsdesign nicht nur dem wissenschaftlichen Fortschritt schadet, sondern auch das Vertrauen in KI-Systeme langfristig beeinträchtigen kann. Besonders im Kontext von sicherheitskritischen Anwendungen oder sensiblen Entscheidungsprozessen ist es unabdingbar, dass die Leistungsfähigkeit zuverlässig und nachvollziehbar gemessen wird. Die Untersuchung zeigt, dass neben dem Modell selbst auch der Kontext der Bewertung eine herausragende Rolle für das Ergebnis spielt.

Faktoren wie die Art der Datensätze, Formatierungsdetails oder technische Implementierungen wie Tensor Parallelism sind weniger sichtbar, aber äußerst einflussreich. Diese komplexe Wechselwirkung macht deutlich, wie vielschichtig die Herausforderung ist und wie wichtig eine interdisziplinäre Betrachtung von KI-Entwicklung, Evaluationsmethoden und statistischer Auswertung ist. Zukünftige Forschungen könnten sich auf die Erweiterung und Verbesserung standardisierter Benchmarks konzentrieren, die nicht nur verschiedene Dimensionen der Modelfähigkeit abdecken, sondern auch robust gegenüber geringfügigen Änderungen in den Evaluationsumgebungen sind. Zudem wäre der verstärkte Einsatz von robusten statistischen Methoden und Unschärfenmodellierung sinnvoll, um eine realistischere Einschätzung der Modellleistung zu gewährleisten. Die Arbeit zu strategischem Übertreiben durch Evaluationsdesign trägt daher nicht nur zu einem besseren Verständnis der gegenwärtigen Bewertungsprobleme bei, sondern legt auch einen Grundstein für eine zuverlässigere und verantwortungsvollere Weiterentwicklung großer Sprachmodelle.

Angesichts der wachsenden Bedeutung von LLMs in unterschiedlichsten gesellschaftlichen und wirtschaftlichen Bereichen ist eine kritische und transparente Evaluationspraxis unverzichtbar, um das Potenzial dieser Technologien mit realistischen Erwartungen und fundiertem Vertrauen zu erschließen.