Die rasant fortschreitende Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Art und Weise revolutioniert, wie wir mit Informationen interagieren. Trotz ihrer beeindruckenden Fähigkeiten weisen viele dieser Modelle bis heute ein großes Problem auf: Halluzinationen, also die Erzeugung von falschen oder irreführenden Inhalten, die nicht auf verifizierbaren Fakten beruhen. Dies stellt eine ernsthafte Herausforderung für Unternehmen, Entwickler und Nutzer dar, da unzuverlässige oder falsche Informationen zu Fehlentscheidungen, Vertrauensverlust und sogar rechtlichen Konsequenzen führen können. Vor diesem Hintergrund hat AIMon Labs mit seinem Modell HDM-2 eine offene, auf Kontext und Allgemeinwissen basierende Lösung zur Detektion von Halluzinationen entwickelt, die wegweisend für die Zukunft der KI-Sicherheit ist. Die Bedeutung der Halluzinationserkennung in KI-gestützten Anwendungen kann nicht hoch genug eingeschätzt werden.

In Branchen wie dem Gesundheitswesen, der Finanzwirtschaft oder dem Rechtsbereich ist die Genauigkeit von Informationen von existenzieller Bedeutung. Falsche medizinische Ratschläge, unpräzise Finanzprognosen oder falsche rechtliche Empfehlungen können fatale Folgen haben. Traditionelle Methoden zur Bewertung der Faktentreue in Texten stoßen dabei oft an technische Grenzen: Sie reagieren empfindlich auf die Formulierung der Prompts, führen zu inkonsistenten Bewertungen oder benötigen eine erhebliche Rechenleistung und Zeit. Genau hier setzt das Modell HDM-2 an und bietet eine effiziente, vielseitig einsetzbare und zugleich detaillierte Alternative. HDM-2, entwickelt von AIMon Labs, ist ein modularer, produktionsreifer Evaluator für Halluzinationen, der speziell für den Unternehmenseinsatz konzipiert wurde.

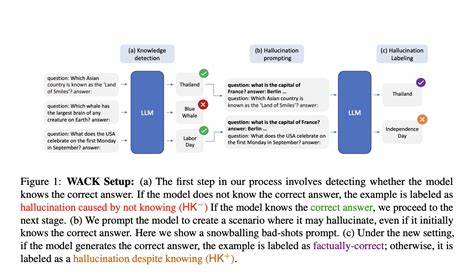

Anders als herkömmliche Ansätze bietet es eine mehrstufige Validierungsmethodik, die sowohl den vorliegenden Kontext als auch allgemein akzeptiertes Wissen berücksichtigt. Dies ermöglicht nicht nur die Prüfung, ob eine erstellte Antwort auf den vorliegenden Informationen basiert, sondern auch, ob sie im Widerspruch zu allgemein bekannten Fakten steht. Dadurch können harmlose Aussagen, die nicht im Kontext stehen, aber dennoch korrekt sind, korrekt erkannt und ausgeklammert werden. Eine der innovativsten Eigenschaften von HDM-2 ist seine Fähigkeit, Halluzinationen auf Phrase-, Token- und Satzebene zu identifizieren und für jedes Wort eine Wahrscheinlichkeitsbewertung für Halluzinationen zu liefern. Diese granulare Analyse unterstützt Entwickler und Unternehmen, problematische Passagen präzise zu erkennen und entsprechend zu korrigieren.

Ein weiterer Pluspunkt ist die bemerkenswerte Geschwindigkeit: Das Modell arbeitet auf einer einzelnen Nvidia L4 GPU innerhalb eines Latenzbudgets von 500 Millisekunden, was insbesondere für agentenbasierte Systeme und interaktive Anwendungen enorm wichtig ist. Der Einsatz von HDM-2 beschränkt sich dabei nicht auf einen einzelnen Bereich, sondern zeigt beeindruckende Generalisierungsfähigkeiten über diverse Domänen hinweg. Branchen wie Finanzen, Gesundheitswesen, Versicherungen oder Recht profitieren gleichermaßen von der präzisen Halluzinationserkennung. Gerade in hoch regulierten Umfeldern, in denen Verifizierbarkeit und Compliance eine große Rolle spielen, vermittelt das Modell mehr Sicherheit und Vertrauen in KI-generierte Inhalte. Die technische Architektur des Modells kombiniert eine taxonomiebasierte Validierung mit einem neuartigen spanbasierten Evaluierungsansatz.

Dies sorgt für eine hohe Präzision bei der Erkennung von Fehlerzeiten und trägt zur besseren Erklärbarkeit der Ergebnisse bei — eine wesentliche Voraussetzung für den Unternehmenseinsatz, wo Entscheidungen nachvollziehbar gestaltet sein müssen. HDM-2 ist deshalb nicht nur als reines Bewertungstool zu verstehen, sondern auch als Instrument, das eine transparente Analyse der KI-Outputqualität ermöglicht. Ein Anwendungsbeispiel illustriert die Stärken von HDM-2 anschaulich: Bei der Überprüfung eines Berichts über klinische Studien eines Krankenhauses im ersten Quartal 2025 werden haltlose Aussagen, wie eine angeblich größte Teilnahme an neurologisch fokussierten Studien mit 500 Patienten (statt der belegten 220 in der Onkologie), mit hoher Wahrscheinlichkeit als Halluzinationen markiert. Gleichzeitig filtert das Modell allgemeingültige Fakten, wie beispielsweise die führende Rolle von Herzkrankheiten bei Todesursachen laut der WHO, korrekt heraus, auch wenn diese im Kontext nicht explizit genannt werden. So bleibt die Balance zwischen Kontext- und Allgemeinwissenserkennung gewahrt.

Für Unternehmen bietet AIMon Labs darüber hinaus eine Enterprise-Version an, die auf die Integration unternehmensspezifischen Wissens spezialisiert ist. Diese Version ermöglicht es, firmeneigene Daten und Informationen in die Bewertung einzubeziehen, wodurch etwa interne Fakten oder branchenspezifische Regularien berücksichtigt werden können, die im allgemeinen Kontext nicht verfügbar sind. Zudem sind in der Enterprise-Variante erweiterte Funktionen wie ausführliche Erklärungen der Ergebnisse sowie verbesserte Genauigkeiten und noch geringere Latenzwerte geplant. Neben der Halluzinationserkennung hat AIMon Labs zudem leistungsstarke Modelle für die Beurteilung der Übereinstimmung mit Prompt- oder Instruktionsvorgaben, Relevanzanalyse in Retrieval-augmented Generation (RAG)-Szenarien und das Reranking von Antworten entwickelt. Diese ergänzenden Werkzeuge unterstützen Entwickler dabei, die Qualität von KI-Ausgaben ganzheitlich zu verbessern und sicherzustellen, dass Modelle nicht nur faktentreu, sondern auch instruktionsgerecht und kontextsensitiv agieren.

Die Nutzerfreundlichkeit von HDM-2 wird durch eine einfache Integration über Python-Pakete und eine offene Quelle sichergestellt. Entwickler können das Modell mit wenigen Zeilen Code importieren und sofort mit der Analyse von KI-Endergebnissen beginnen. Die freie Lizenzierung (Creative Commons BY-NC-SA 4.0) erlaubt es Forschern und Unternehmen, das Modell für nicht-kommerzielle Zwecke ausgiebig zu testen und zu adaptieren. Für kommerzielle oder maßgeschneiderte Einsätze bietet AIMon Labs professionelle Unterstützung und flexible Lizenzierungsmöglichkeiten an.

Die Einführung von HDM-2 markiert einen wichtigen Schritt im Bereich der KI-Sicherheit und vertrauenswürdiger künstlicher Intelligenz. Indem es die Halluzinationserkennung auf ein neues Level hebt, bietet das Modell neue Möglichkeiten, den steigenden Anforderungen an Verlässlichkeit und Transparenz gerecht zu werden. Gerade für Unternehmen, die auf präzise und belastbare Informationen angewiesen sind, stellt es somit ein unverzichtbares Werkzeug im KI-Toolset dar. Technologisch betrachtet basiert HDM-2 auf einem robusten Fundament aus modernsten NLP- und Machine-Learning-Verfahren, die in der Fachwelt bereits Anerkennung finden. Die zugrunde liegende Forschung ist umfassend dokumentiert und frei zugänglich, was nicht nur die Nachvollziehbarkeit der Methoden garantiert, sondern auch eine Community-basierte Weiterentwicklung fördert.

Die offene Entwicklung sorgt dafür, dass das Modell fortlaufend verbessert wird, etwa durch Integration aktueller Datensätze, Optimierungen im Infrastruktur-Handling oder neue Anwendungsfälle. Die Zukunft der KI wird maßgeblich davon abhängen, wie gut wir Fehler und Fehlinformationen automatisiert erkennen und eindämmen können. Modelle wie HDM-2 zeigen, dass die Kombination aus kontextbezogenem Verständnis und Bezug auf gesichertes Allgemeinwissen eine erfolgversprechende Strategie darstellt. Mit zunehmender Verbreitung und Weiterentwicklung solcher Technologien wird die Qualität von KI-generierten Inhalten messbar und nachhaltig steigen, was zugleich Vertrauen bei Nutzern und Entscheidern schafft. Insgesamt bietet das HDM-2 Modell von AIMon Labs eine wegweisende Lösung für die Erkennung von Halluzinationen in Texten großer Sprachmodelle.

Seine offene Verfügbarkeit, die realitätsnahe Leistungsfähigkeit in diversen Domänen sowie die Unterstützung von Einzel- bis Unternehmenseinsatzmöglichkeiten machen es zu einem essentiellen Bestandteil moderner KI-Anwendungen. Gerade in Zeiten, in denen künstliche Intelligenz immer stärker in kritischen Entscheidungsprozessen eingesetzt wird, trägt HDM-2 dazu bei, Risiken zu minimieren und die Integrität der generierten Informationen sicherzustellen. Für Interessierte besteht die Möglichkeit, HDM-2 direkt über das Python-Paket hdm2 zu nutzen, wodurch ein unkomplizierter Einstieg möglich ist. Parallel dazu bietet AIMon Labs umfassende Dokumentationen, Zugriff auf Forschungsdaten und Support über Communities sowie einen Discord-Server an, um den Austausch und das gemeinsame Vorantreiben der Technologie zu fördern. Zusammenfassend lässt sich sagen, dass das offene Halluzinationserkennungsmodell HDM-2 ein bedeutender Fortschritt in der Qualitätssicherung von KI-Texten darstellt.

Es kombiniert wissenschaftliche Fundierung, industrielle Praxisrelevanz und hohe Anwendungsflexibilität zu einem unverzichtbaren Tool, das hilft, die Vertrauenswürdigkeit von KI-Systemen wesentlich zu erhöhen und deren Einsatz in sensiblen Umgebungen zu erleichtern.