Die kontinuierliche Weiterentwicklung von Software stellt Entwickler täglich vor neue Herausforderungen, insbesondere wenn es darum geht, Fehler im Quellcode schnell und effektiv zu beheben. Automatische Programmreparatur (APR) hat sich in den letzten Jahren als vielversprechende Technologie etabliert, um den Aufwand bei der Fehlersuche und -behebung deutlich zu reduzieren. Dabei gewinnt der Einsatz großer Sprachmodelle (Large Language Models, LLMs) zunehmend an Bedeutung, insbesondere jene, die auf Instruktionen abgestimmt wurden, um präzisere und zielgerichtete Ergebnisse zu liefern. Traditionell fußte die automatische Programmreparatur auf der Erzeugung großer Mengen von potenziellen Patches, mit dem Ziel, darunter möglichst fehlerfreie oder zumindest plausible Lösungen zu finden. Dieses Vorgehen war oft ressourcenintensiv, da oftmals Tausende von Ausgabevarianten generiert werden mussten, um einen brauchbaren Reparaturvorschlag zu erhalten.

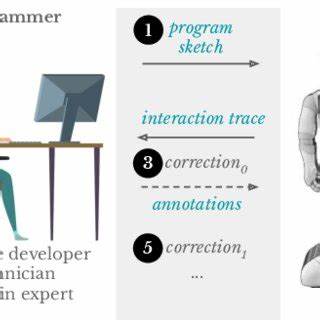

Mit dem Aufkommen von LLMs, die selbstlernende und selbstverbessernde Fähigkeiten besitzen, hat sich dieser Ansatz grundlegend gewandelt. Moderne Modelle können Reparaturvorschläge iterativ verbessern, indem sie Rückmeldungen aus vorangegangenen Reparaturversuchen nutzen, um sich schrittweise einem optimalen Patch anzunähern. Die Balance zwischen der Anzahl generierter Patches und der Anzahl von Iterationen ist ein besonders wichtiger Faktor bei der Gestaltung effektiver APR-Pipelines. Neue Forschungsarbeiten, wie die von Vallecillos Ruiz, Hort und Moonen, zeigen, dass es nicht nur auf viele Iterationsschritte ankommt, sondern auch auf die clevere Kombination mehrerer Ausgaben mit einer ausgewogenen Anzahl von Iterationen. Sie begrenzen die Gesamtzahl der pro Fehler generierten Patches beispielhaft auf zehn, was die Effizienz stark steigert, ohne die Qualität der Reparaturen zu beeinträchtigen.

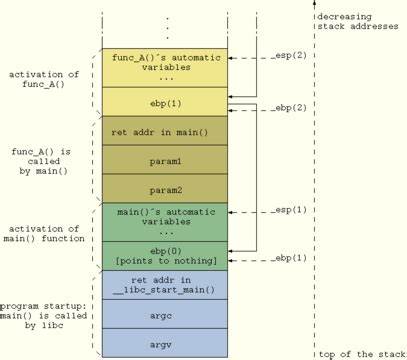

Durch den Einsatz von drei führenden, auf Instruktionen abgestimmten Modellen – DeepSeekCoder-Instruct, Codellama-Instruct und Llama3.1-Instruct – lässt sich zeigen, wie fein justierte LLMs in der Lage sind, die APR-Aufgabe in verschiedenen Szenarien zu meistern. Dabei spielen nicht nur die Modellarchitekturen eine Rolle, sondern auch die Art und Größe der verwendeten Feineinstellungsdatensätze. Die Forschenden haben ihre Modelle mit unterschiedlich großen Datensätzen von 1.000 bis 65.

000 Programmierbeispielen trainiert und dabei Techniken wie Full Fine-Tuning und Low-Rank Adaptation (LoRA) verglichen, um die besten Strategien herauszufinden. Ein überraschendes Ergebnis ist, dass die Verwendung nur eines Bruchteils des verfügbaren Feineinstellungsdatensatzes – unter 1 % – bereits zu erheblichen Verbesserungen führen kann. Konkret zeigen die Ergebnisse eine Steigerung von bis zu 78 % bei der Anzahl plausibler Patches. Das stellt ältere Studien infrage, die nur geringe Erfolge bei klassischen Full Fine-Tuning-Ansätzen berichteten. Gleichzeitig treten bei einer zu intensiven Anpassung Überanpassungseffekte auf, die die Leistungsfähigkeit verringern.

Das verdeutlicht, wie wichtig es ist, Feineinstellungen mit Bedacht zu wählen, um das Optimum zwischen Generalisierung und Spezialisierung zu finden. Ein weiterer zentraler Aspekt ist der Vergleich von iterativen Reparaturstrategien mit der einmaligen Generierung mehrerer Patch-Vorschläge. Die Untersuchung zeigt, dass vor allem Basismodelle, die nicht feingetunt sind, durch iterative Ansätze signifikant profitieren. Durch Feedback-Schleifen können sie Fehler besser analysieren und ihre Vorschläge zielgerichteter anpassen. Die Vorteile dieses Vorgehens sind auf komplexeren Benchmarks besonders ausgeprägt, wo einfache Ausgabevielfalt oft nicht ausreicht, um alle Problemstellen umfassend zu adressieren.

Auch feinjustierte Modelle profitieren von der Iteration, wenn auch in etwas geringerem Maße. Gerade bei schwierigen Bug-Datensätzen erleichtert die Kombination aus Feintuning und iterativer Verfeinerung die Bewältigung komplexer Fehlerbilder. Dies unterstreicht die Bedeutung einer ausgewogenen APR-Strategie, die sowohl Mehrfachausgaben als auch iterative Verbesserungen integriert, um maximale Effektivität zu erreichen. Die Anwendung instruierter Sprachmodelle bei der automatischen Programmreparatur bietet darüber hinaus einen entscheidenden Vorteil: durch die Orientierung an expliziten Anweisungen kann die Generierung von Patches zielgerichteter gesteuert werden. Das führt nicht nur zu besseren Qualitätsmerkmalen der Reparaturen, sondern auch zu einer besseren Nachvollziehbarkeit und Steuerbarkeit des gesamten Prozesses.

Entwickler erhalten dadurch ein Werkzeug, das sich nicht nur an vorgegebene Programmierstandards anpasst, sondern auch eigenständig lernt, wie es auf Feedback reagiert und daraus lernt. Der Einsatz von LoRA-Techniken zur Feineinstellung stellt eine weitere Innovation dar, die Effizienzgewinne bei der Anpassung großer Modelle an APR-Aufgaben ermöglicht. LoRA erlaubt es, die Anzahl der erforderlichen Parameter für das Training stark zu reduzieren, was die Ressourcenanforderungen senkt und somit eine breitere Anwendung in der Praxis begünstigt. Dies ist insbesondere für Unternehmen und Forschungseinrichtungen interessant, die mit beschränkten Hardwarekapazitäten arbeiten. Die Erkenntnisse aus der Untersuchung unterstreichen die Notwendigkeit, APR-Methoden nicht starr nach einer Dimension zu optimieren, sondern flexible Pipelines zu gestalten, die sich an den jeweiligen Kontext anpassen.

Faktoren wie die Komplexität des Bugs, das zur Verfügung stehende Trainingsmaterial, die Leistungsfähigkeit des Basismodells und die Zielvorgaben eines Reparatursystems müssen dabei umfassend berücksichtigt werden. Ausblickend kann die Kombination von instruktionsgetunten LLMs mit iterativen Reparaturstrategien die Softwareentwicklung erheblich beschleunigen und die Qualität von Softwareprodukten erhöhen. Während bisherige APR-Methoden oft nur einzelne Reparaturversuche automatisierten, ermöglichen moderne Modelle eine lernbasierte Selbstoptimierung, die Fehlerbehebung in mehreren Schleifen vorantreibt. Dies führt nicht nur zu einer höheren Plausibilität der generierten Patches, sondern auch zu einer besseren Abdeckung unterschiedlicher Fehlertypen. Die laufende Forschung in diesem Bereich verspricht weitere Verbesserungen, insbesondere wenn sich Modelle noch besser auf spezifische Fehlerarten anpassen lassen und Feedback-Schleifen noch effektiver gestaltet werden.