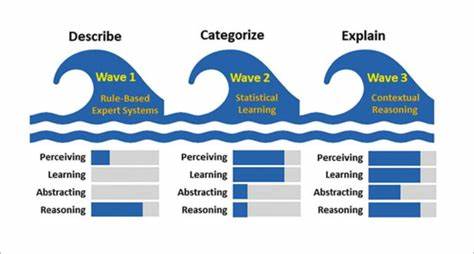

In den letzten Jahren haben große Sprachmodelle (LLMs) wie GPT oder ähnliche neuronale Netzwerke einen tiefgreifenden Einfluss auf viele Branchen ausgeübt. Doch trotz des Hypes und der Vielzahl an Ressourcen, die inzwischen verfügbar sind, stellt der praktische Umgang mit diesen Modellen Entwickler und Unternehmen oft vor erhebliche Herausforderungen. Um diese Hürden zu überwinden, fand der Workshop "AI That Works" in San Francisco statt, bei dem erfahrene Entwickler und Branchenexperten ihr Wissen und ihre Praxiserfahrungen zum Thema LLM-Engineering teilten. Der folgende Artikel fasst die wertvollsten Erkenntnisse und Strategien zusammen, die dabei vorgestellt wurden, und beleuchtet, wie man mit großen Sprachmodellen effizient, robust und kostengünstig arbeiten kann. Ein besonderes Augenmerk liegt dabei auf praktischen Tipps und bewährten Vorgehensweisen, die den Einstieg sowie den produktiven Einsatz von LLMs erleichtern können.

Die Inhalte entstanden in Zusammenarbeit von Experten, die bereits vor dem Durchbruch der KI mit komplexen Problemen umgingen – und somit einen besonders praxisorientierten Blick auf das Thema bieten. Einen der zentralen Problempunkte bei großen Sprachmodellen stellt die Kategorisierung einer Vielzahl von möglichen Labels oder Kategorien dar. Das sogenannte "Attention Drift" Phänomen macht sich dabei schnell bemerkbar: Wenn man einem Modell mehrere tausend Kategorien in einem Prompt präsentiert, verliert es die Fähigkeit, alle gleichmäßig zu gewichten. Die ersten Kategorien bekommen unverhältnismäßig viel Aufmerksamkeit, während viele in der Mitte des Katalogs schlicht übersehen werden. Die Folge sind fehlerhafte oder inkonsistente Klassifikationen.

Abhilfe schafft hier eine Vorfilterung, bei der nur eine überschaubare Anzahl relevanter Kandidaten an das Modell weitergereicht wird. Die Frage, wie man diese Filterung am besten umsetzt, wurde intensiv diskutiert. Unter den getesteten Verfahren wie hierarchische Aufbereitung oder kollektive Entscheidungen des LLMs (LLM Quorum) hat sich das Prinzip der Cosine Similarity Clustering als besonders effektiv erwiesen. Dabei werden alle Kategorien als Vektoren in einem semantischen Raum eingebettet, und durch Ähnlichkeitsmessung mittels Cosine Similarity werden die vielversprechendsten Kandidaten für eine finale Auswahl durch das LLM geshortlistet. Dieses Vorgehen reduziert nicht nur die benötigte Prompt-Größe drastisch, sondern erhöht gleichzeitig die Genauigkeit der Kategorisierung.

Ein weiteres Highlight des Workshops war der Ansatz, klassische lokale Modelle mit LLMs hybrid zu kombinieren. Insbesondere im medizinischen Bereich mit der Klassifikation von Versicherungscodes hat sich ein Prozess etabliert, bei dem ein kleiner, effizienter Modellteil vorab circa 80 Prozent der einfachen Fälle automatisiert abarbeitet. Die verbleibenden 20 Prozent, also die besonders schwierigen und unklaren Fälle, werden dann an ein großes Sprachmodell übergeben. Dieses Verfahren ermöglicht es, Kosten zu sparen und zugleich die Verarbeitungsgeschwindigkeit zu erhöhen, da die aufwändige Nutzung von großen LLMs nur dort erfolgt, wo sie wirklich notwendig ist. Zur stetigen Verbesserung der Klassifikationspipeline ist die Identifikation des sogenannten "Confident Set" wichtig.

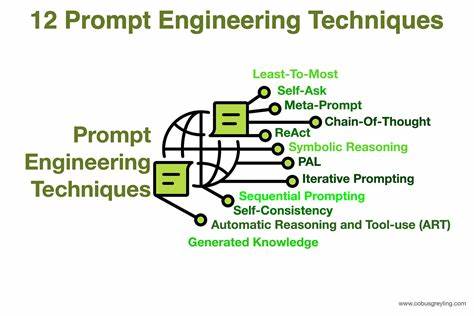

Hierfür sind manuelle Analysen und die Integration von Nutzerfeedback entscheidend. Beispielsweise können in Anwendungen Buttons implementiert sein, die auf Klassifikationsergebnisse reagieren (etwa "Bestellung stornieren"). Diese Interaktionen liefern wertvolle Signale zur Überprüfung der Zuverlässigkeit der Klassifikation. Mit diesen Daten lassen sich Schwellenwerte zur Vertrauenswürdigkeit automatisch anpassen oder lokale Modelle gezielt nachtrainieren, wodurch die Pipeline sich kontinuierlich selbst optimiert. Ein elementarer Bestandteil des erfolgreichen Umgangs mit LLMs ist das sogenannte Prompt-Engineering.

Auch wenn große Sprachmodelle teilweise in der Lage sind, eigenständig Anweisungen zu verfassen, enden solche automatisch generierten Prompts oft in übermäßig langen, allgemeinen Anweisungen, die kaum spezialisiert sind und wertvolle Tokens verschwenden. Die manuelle Erstellung von Prompts ermöglicht es hingegen, domänenspezifisches Wissen gezielt einzubringen und präzise Anleitungen zu formulieren, was sowohl die Genauigkeit erhöht als auch die Kosten reduziert. Dabei hat sich gezeigt, dass es von Vorteil ist, auf simple und prägnante Bezeichner zu setzen. Lange komplexe IDs oder chaotische Schlüssel fressen nicht nur Token, sondern lenken auch das Modell ab, was sich negativ auf die Qualität der Ausgabe auswirkt. Kürzere Bezeichnungen wie "Kategorie1" oder "Option2" helfen sofort dabei, schlankere und effektivere Prompts zu erstellen.

Auch die Art, wie Beispiele in Prompts integriert werden, spielt eine große Rolle. Statt alle Beispiele gesammelt am Anfang zu platzieren, ist es effizienter, jedes Beispiel direkt in den Kontext der zugehörigen Daten zu setzen. Diese Eintrittsstrategie verhindert, dass das Modell durch irrelevanten Kontext scrollen muss und macht sogenannte Few-Shot-Prompts zuverlässiger in ihrer Wirkung. Im Zusammenhang mit Beispielen ist zu beachten, dass diese nicht zu Verfälschungen führen dürfen. Ein Teilnehmer berichtete von einem Fall, in dem ein Modell beim Auftreten eines Patienten mit einer ähnlichen Erkrankung Details aus dem Beispiel reproduzierte, obwohl diese eigentlich nicht relevant waren – eine typische Form von Halluzination.

Deshalb ist es wichtig, sorgfältig zu überprüfen, welche Beispiele man verwendet und darauf zu achten, dass sie das Modell nicht unabsichtlich zu Falschinformationen verleiten. Um das Token-Budget zu schonen, sollte man zudem offensichtliche Informationen nicht explizit mitbeschreiben. In einem Mitarbeiterschema ist es etwa nicht notwendig, ein Feld "Name" lang und breit zu erläutern. Die gelernten Weltkenntnisse der Modelle reichen aus, um solche Grundinformationen zu interpretieren – stattdessen lohnt es sich, das Tokenvolumen für wirklich komplexe oder wichtige Anweisungen vorzubehalten. Die Reihenfolge der Anweisungen im Prompt ist ein weiterer Hebel für bessere Ergebnisse.

Je nach Kontext ist es sinnvoll, Daten vor oder nach den Instruktionen zu stellen. Darüber hinaus können komplexe Aufgaben in Zwischenschritte unterteilt werden, beispielsweise zuerst potenzielle Kategorien auflisten und anschließend die finale Wahl treffen. Dies hilft dem Modell, seinen Denkprozess klarer zu strukturieren und nachvollziehbare Entscheidungen zu treffen. Ein besonders hilfreiches Prinzip aus der Entwicklungspraxis lautet: Zunächst die Funktionsfähigkeit sicherstellen, dann die Richtigkeit verbessern, anschließend die Geschwindigkeit optimieren und zuletzt die Kosten minimieren. Je nach Projektphase kann man dabei auch die Prioritäten anpassen, beispielsweise mit Fokus auf Kosteneffizienz in einem frühen Stadium.

Dieses Vorgehen verhindert, dass man sich zu früh mit Optimierungen beschäftigt, ohne ein sprichwörtliches „rundes“ Produkt zu haben. Unter dem Begriff "Chain of Thought" versteht man die Fähigkeit eines Modells, seine Gedankenschritte transparent nachvollziehbar darzustellen. Im Workshop wurde die Idee von sogenannten <thinking>-Blöcken vorgestellt, die im Prompt einen klaren Bereich definieren, in dem das Modell seine logische Herleitung äußert. Das erleichtert das Debuggen und die Optimierung der Prompt-Struktur erheblich. Außerdem kann man im <thinking>-Block schon Ansätze oder Stichpunkte vorgenerieren, um die Richtung der Überlegungen zu steuern und konsistentere Ergebnisse zu erzielen.

Dennoch gilt es abzuwägen, wann sich das explizite "Chain of Thought" lohnt. Die gelieferte Genauigkeit geht oft mit erhöhten Kosten und längeren Reaktionszeiten einher. Sobald eine stabile Prompt-Architektur vorliegt, empfiehlt es sich, dieses Element zu verkürzen oder ganz zu entfernen – oder für den produktiven Einsatz auf kleinere, günstigere Modelle zu wechseln. Grundsätzlich gilt für Inputs der bekannte Grundsatz "Garbage In, Garbage Out". Unstrukturierte oder unübersichtliche Eingabedaten führen zwangsläufig zu minderwertigen Ausgaben.

Daher sollte man Zeit und Mühe investieren, um Daten vor der Übergabe ans Modell zu säubern, zu normalisieren und einheitlich aufzubereiten. Dieser Schritt steigert dauerhaft die Qualität des Ergebnisses. Der Einsatz von Frameworks wie LangChain oder ähnlichen hat sich als zweischneidiges Schwert erwiesen. Einerseits ermöglichen diese Bibliotheken einen schnellen Start und bieten viele Komfortfunktionen. Andererseits können sie die Flexibilität einschränken, wenn es darum geht, sehr spezifische Aspekte des Prompt-Engineerings, wie feine Steuerung von Aufmerksamkeitsverteilungen oder Tokenbudgets, zu beeinflussen.

Für Projekte, in denen maximale Kontrolle benötigt wird, empfiehlt sich eine direkte, manuelle Handhabung der Prompts. Ein innovativer Ansatz, um Logik und Formatierung der LLM-Ausgaben zu entkoppeln, ist das Konzept von BAML (bounded attribute markup language). Anstatt den Output strikt im Prompt vorzugeben und damit teilweise zu überfrachten, lässt man das Modell zunächst natürliche Texte generieren und übersetzt diese anschließend über eine BAML-Schicht in das gewünschte strukturierte Format. Dieser zweistufige Prozess reduziert Tokenverschwendung und formatbedingte Fehler und erleichtert die spätere Verarbeitung. Zusätzlich bietet BAML eine Testumgebung und ein Unit-Test-Framework, mit dem man Prompts ähnlich wie Software-Code auf Robustheit prüfen kann.

Auf diese Weise lassen sich auch Randfälle abdecken und Fehler früher erkennen, was zu stabileren Anwendungen führt. Ein visueller Token-Analyzer hilft dabei, die tokenintensive Stellen im Prompt sichtbar zu machen und gezielt zu optimieren. Die Architektur von Agenten ist ein weiterer essenzieller Bestandteil erfolgreicher Anwendungsentwicklung mit LLMs. Ein modularer Run-Loop, der zyklisch prüft, ob eine Abbruchbedingung vorliegt, dann eine Aktion vom LLM abruft, diese in deterministischem Code ausführt, den Kontext aktualisiert und anschließend weitermacht, sorgt für klare Trennung der Logik und einfachere Fehlersuche. Dieses Modell ähnelt klassischen Spielschleifen und hat sich als robust bewährt.

Wichtig ist dabei die Nutzung von geschlossenen Aktionslisten (Enums), die alle möglichen Befehle oder Zustände klar definieren. So vermeidet man unklare freie Texteingaben, die schwer zu verarbeiten sind, und vereinfacht die Programmierung des Orchestrators, der auf Basis des Aktionscodes reagiert. Darüber hinaus empfiehlt sich der Aufbau einer Persistenzschicht, die es erlaubt, den Zustand des Agenten zu speichern, bei Bedarf auf Benutzereingaben zu warten und anschließend genau dort weiterzumachen, wo man aufgehört hat. Diese Funktion ist besonders für lang laufende Prozesse oder beim Einbeziehen menschlicher Kontrolle von großer Bedeutung. Ein gut implementiertes Persistenzsystem ermöglicht zudem eine Wiedergabefunktion (Replay), mit der Abläufe nachvollzogen und getestet werden können.

Innovative Modellentwicklungen wie Qwen3 wurden im Workshop hervorgehoben. Besonders die Fähigkeit, interne Denkprozesse (Chain of Thought) per Kommando wie /nothink gezielt zu deaktivieren, erlaubt eine beträchtliche Beschleunigung der Reaktionszeiten. Diese Flexibilität macht Qwen3 und kleinere Geschwistermodelle besonders geeignet für den Einsatz auf moderater Hardware oder in Szenarien, in denen Geschwindigkeit wichtiger als tiefe logische Herleitung ist. Die Wirkung von kleinen Formulierungsänderungen im Prompt auf den Ton und die Ausrichtung der Modellausgabe wurde ebenfalls diskutiert. Freundliche Zusätze wie "you'll do a great job" können subtile Einflussnahmen erzielen, die aber stets durch automatisierte Evaluationen überprüft werden müssen, um ungewollte Nebenwirkungen zu vermeiden.

Zwei eindrucksvolle Demonstrationen rundeten den Workshop ab. Einerseits wurde ein KI-Agent vorgestellt, der Rechnungen aus PDFs – sogar von Smartphone-Fotos im HEIC-Format – ausliest und mithilfe einer Verifikationsschleife die korrekte Addition der Positionen überprüft. Dieser automatisierte Prozess fängt Fehler auf, bevor Rechnungen versandt werden. Andererseits wurde mit browse.dev ein Prototyp gezeigt, der eigenständig Hacker News Seiten durchsucht, Artikel zusammenfasst und die Ergebnisse direkt in Google Docs einfügt.

Dabei kamen auch Herausforderungen wie Eigenheiten der DOM-Struktur ans Licht, die den Bedarf für speziell optimierte Browser-Funktionalitäten unterstreichen. Abschließend wurde der Bereich Sensorfusion in Augmented Reality (AR) mit KI-Modellen erörtert, bei dem schnelle Sensordaten mit langsameren Bildinformationen synchronisiert werden, um Fehler zu minimieren und eine genauere Interpretation zu liefern. Dies übertragbare Prinzipien helfen dabei, Agenten und AI-Anwendungen robuster zu gestalten. Die gezeigten Erkenntnisse und Methoden aus dem Workshop "AI That Works" bieten eine umfassende Grundlage, um die Komplexität großer Sprachmodelle gezielt zu beherrschen und praktische Anwendungen effektiv auszubauen. Die Kombination aus technischem Know-how, strukturiertem Vorgehen und einem klaren Fokus auf Wirtschaftlichkeit macht diese Ansätze für Entwickler und Unternehmen jeder Größe wertvoll.

Wer sich diese Strategien zu Eigen macht, wird LLMs nicht nur als technische Spielerei, sondern als leistungsfähige Werkzeuge erleben, die echte Probleme lösen und nachhaltigen Mehrwert schaffen können.