In einer Ära, in der Künstliche Intelligenz (KI) zunehmend in nahezu allen Lebensbereichen Einzug hält, gewinnt auch die Sicherheit von KI-Systemen immer mehr an Bedeutung. Gerade im Bereich der Cybersicherheit stehen Unternehmen und Sicherheitsforscher vor enormen Herausforderungen, um mit den rasanten Fortschritten der Technologie Schritt zu halten. Eine revolutionäre Methode, die in den letzten Jahren an Bedeutung gewonnen hat, ist das sogenannte AI Red Teaming. In einer jüngst stattgefundenen Live-Q&A-Session haben renommierte Experten das Thema intensiv beleuchtet und spannende Einblicke gegeben, die nicht nur die technische Komplexität, sondern auch den praktischen Nutzen dieser Strategie verdeutlichen. AI Red Teaming beschreibt eine spezialisierte Form des Sicherheitstests, bei dem ein Team – meist bestehend aus ethischen Hackern, Sicherheitsexperten und KI-Spezialisten – gezielt versucht, Schwachstellen in KI-Systemen aufzudecken.

Anders als bei herkömmlichen Penetrationstests, die oft auf klassische IT-Infrastrukturen beschränkt sind, konzentriert sich AI Red Teaming auf die besondere Architektur von künstlichen Intelligenzen samt ihrer Lernmechanismen, Algorithmen und Datenverarbeitung. Ziel ist es, die Systeme nicht nur auf technische Sicherheitsmängel zu überprüfen, sondern auch auf potenzielle Manipulationsmöglichkeiten und Bias, die in der künstlichen Intelligenz versteckt sein können. Während der Live-Q&A kamen verschiedene Aspekte zur Sprache, die diese Form der KI-Sicherheit besonders machen. Die Experten betonten, dass AI Red Teaming essenziell ist, um Vertrauen in automatisierte Systeme zu schaffen, insbesondere da diese im Alltag und in kritischen Infrastrukturen immer stärker verankert sind. Durch das gezielte „Angreifen“ der KI-Systeme sollen reale Szenarien simuliert werden, um Schwachstellen unter authentischen Bedingungen zu identifizieren, bevor Angreifer sie ausnutzen können.

Ein weiterer wichtiger Punkt der Diskussion war die Balance zwischen Automatisierung und menschlicher Expertise. Trotz der Fähigkeit moderner KI-Modelle, große Datenmengen zu verarbeiten und intuitiv zu lernen, besitzen sie auch inhärente Risiken. So können zum Beispiel unerwartete Verhaltensweisen auftreten oder versteckte Sicherheitslücken entstehen, die durch bloße automatisierte Tests nicht entdeckt werden können. Hier kommt das Red Teaming als menschliche Kontrollinstanz ins Spiel. Nur durch die Kombination von maschineller und menschlicher Intelligenz ist es möglich, ein hohes Sicherheitsniveau zu gewährleisten.

Experten hoben außerdem hervor, dass AI Red Teaming weit über das technische Aufspüren von Schwächen hinausgeht und eng mit den ethischen und rechtlichen Rahmenbedingungen verknüpft ist. Denn KI-Systeme, die in Bereichen wie Gesundheitswesen, Finanzdienstleistungen oder autonomem Fahren eingesetzt werden, müssen nicht nur sicher, sondern auch vertrauenswürdig und transparent operieren. Red Teaming hilft dabei, Verzerrungen, Diskriminierung oder unbeabsichtigte Folgen von Algorithmen sichtbar zu machen und dadurch Maßnahmen zu entwickeln, die eine verantwortungsvolle KI-Nutzung fördern. Die Live-Q&A unterstrich auch die Notwendigkeit, AI Red Teaming als fortlaufenden Prozess zu verstehen. KI-Systeme sind dynamisch, sie verändern sich durch neue Daten und Updates ständig weiter, wodurch auch neue Angriffsflächen entstehen können.

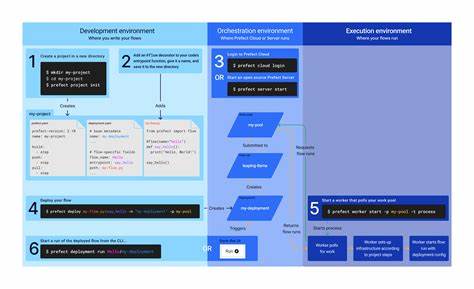

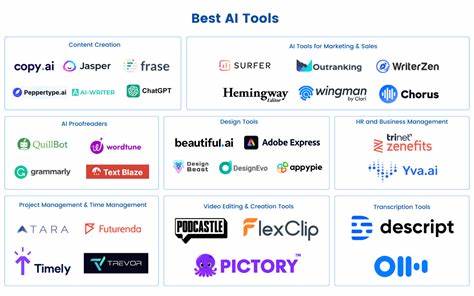

Ein einmaliger Test reicht daher selten aus, um langfristig Sicherheit zu garantieren. Stattdessen müssen Unternehmen und Organisationen kontinuierlich in Sicherheitstests investieren und Red Teaming als integralen Bestandteil ihrer KI-Entwicklungs- und Betriebsprozesse etablieren. Aufschlussreich war zudem die Diskussion über Tools und Technologien, die heute beim AI Red Teaming eingesetzt werden. Diese reichen von simulierten Angriffsplattformen und komplexen Testumgebungen bis hin zu auf KI basierenden Analytik-Werkzeugen, die dabei helfen, das Verhalten der Systeme präzise zu überwachen und Anomalien frühzeitig zu erkennen. Die Hersteller von KI-Systemen arbeiten inzwischen eng mit spezialisierten Sicherheitsteams zusammen, um Schwachstellen zu evaluieren und Schwachstellenberichte zu automatisieren.

Im Rahmen der Q&A wurde auch das zunehmende Interesse von Unternehmen unterschiedlichster Branchen an AI Red Teaming deutlich. Global agierende Finanzinstitute, Technologie-Giganten, aber auch öffentliche Einrichtungen erkennen die Notwendigkeit, ihre KI-Systeme auf Herz und Nieren zu prüfen. Gerade in Zeiten wachsender Cyberbedrohungen und regulatorischer Vorgaben wird AI Red Teaming als maßgeblicher Baustein einer resilienten Sicherheitsstrategie angesehen. Parallel zur technischen und organisatorischen Diskussion wurden auch Herausforderungen benannt, die die Praxis von AI Red Teaming erschweren. Dazu zählen die hohe Komplexität der KI-Modelle, der Bedarf an hochqualifizierten Experten und die Kosten intensiver Sicherheitsprüfungen.

Zudem ist die Sicherstellung der Vertraulichkeit sensibler Daten während der Tests eine anspruchsvolle Aufgabe. Dennoch sehen die Experten diese Herausforderungen als Ansporn, innovative Lösungsansätze zu entwickeln und die Zusammenarbeit zwischen KI-Forschern, Sicherheitsspezialisten und Regulatoren zu intensivieren. Ein faszinierender Aspekt der Q&A war die Perspektive, wie AI Red Teaming sich in den kommenden Jahren weiterentwickeln könnte. Mit fortschreitender Technologie wird auch der Einsatz von KI in der Sicherheit selbst zunehmen. Dies eröffnet die Möglichkeit, dass zukünftige Red Teams durch KI unterstützt werden, um noch tiefergehende Analysen durchzuführen, Angriffe vorherzusagen oder sogar proaktive Schutzmaßnahmen automatisch einzuleiten.

Gleichzeitig muss jedoch die menschliche Kontrolle erhalten bleiben, um ethische und sicherheitstechnische Risiken zu minimieren. Die ausführliche Diskussion in der Live-Q&A hat gezeigt, dass AI Red Teaming heute schon eine unverzichtbare Komponente im Sicherheitsökosystem bildet. Es unterstützt Unternehmen dabei, die Qualität und Sicherheit von KI-Systemen zu steigern, Risiken frühzeitig zu identifizieren und das Vertrauen von Nutzern und Partnern zu stärken. In einer Zeit, in der digitale Bedrohungen immer raffinierter und KI-Technologien immer komplexer werden, ist AI Red Teaming ein zukunftsweisendes Instrument – nicht nur für Sicherheitsexperten, sondern für alle, die mit KI arbeiten oder deren Produkte und Dienstleistungen nutzen. Abschließend lässt sich festhalten, dass AI Red Teaming keine kurzfristige Modeerscheinung ist, sondern ein strategischer und nachhaltiger Ansatz zur Absicherung von KI-Technologien.

Die mehrdimensionale Betrachtung technischer, ethischer und organisatorischer Aspekte macht es zu einem anspruchsvollen, gleichzeitig aber äußerst wirkungsvollen Instrument, das Unternehmen hilft, in einer digitalisierten Welt sicher und verantwortungsvoll zu agieren. Die Erkenntnisse aus der Live-Q&A bieten wertvolle Impulse für Entscheidungsträger, Entwickler und Sicherheitsprofis, die sich intensiv mit der Zukunft der KI-Sicherheit beschäftigen wollen.