Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht und durchdringt mittlerweile zahlreiche Bereiche unseres Lebens und unserer Wirtschaft. Besonders bemerkenswert ist die Entwicklung sogenannter KI-Agenten, die autonom Daten sammeln, verarbeiten und auf Basis vordefinierter Ziele agieren, ohne dass eine dauerhafte menschliche Steuerung notwendig ist. Diese fortschrittlichen Softwareprogramme basieren meist auf großen Sprachmodellen (Large Language Models, LLMs) und sind in der Lage, nicht nur Informationen zu interpretieren, sondern auch externe Werkzeuge und APIs intelligent zu nutzen, um komplexe Aufgaben zu erfüllen. Die Anwendungsfelder reichen vom Kundenservice über Finanzanalysen bis hin zu medizinischer Diagnostik und Patientenüberwachung. Die Integration von KI-Agenten eröffnet somit ein breites Spektrum an Effizienzsteigerungen und neuen Möglichkeiten.

Doch mit diesem Fortschritt wächst auch die Angriffsfläche für Cyberkriminelle und bösartige Akteure, die gezielt diese Technologien manipulieren oder für eigene Zwecke missbrauchen wollen. Die Sicherheitsrisiken bei agentenbasierten KI-Anwendungen sind vielfältig und gehen weit über die klassischen Bedrohungen bei traditionellen LLM-Anwendungen hinaus. KI-Agenten zeichnen sich durch ihre Fähigkeit aus, eigenständig Entscheidungen zu treffen, Funktionen zu planen und gezielt externe Tools einzusetzen. Dieses Zusammenspiel zwischen Sprachmodellen und Werkzeugen kann unter Sicherheitsgesichtspunkten erhebliche Schwachstellen enthalten. Die externe Anbindung an APIs, Datenbanken oder andere Services bedeutet, dass nicht mehr nur die inhärenten Risiken der KI-Modelle, wie zum Beispiel Prompt Injection oder Datenleckagen, relevant sind, sondern auch klassische IT-Schwachstellen wie SQL-Injektionen, Broken Access Control oder Remote Code Execution.

Die Art und Weise, wie KI-Agenten aufgebaut und implementiert werden, ist deshalb von höchster Bedeutung. Untersuchungen und simulierte Angriffe auf Agent-Anwendungen, die mit beliebten Open-Source-Frameworks wie CrewAI und AutoGen realisiert sind, haben gezeigt, dass viele der Schwachstellen nicht unbedingt aus Fehlern in den Frameworks selbst resultieren. Stattdessen entstehen sie häufig durch unsichere Designmuster, fehlerhafte Konfigurationen oder unzureichende Absicherung in der Integration externer Tools. Ein Beispiel dafür ist die ungesicherte Verwendung von Code-Interpretern innerhalb der Agenten, die es Angreifern ermöglichen können, eigenen Code auszuführen und somit die komplette Infrastruktur zu kompromittieren. Zu den Kernbedrohungen, die im Zusammenhang mit KI-Agenten immer wieder auftauchen, gehört die sogenannte Prompt Injection.

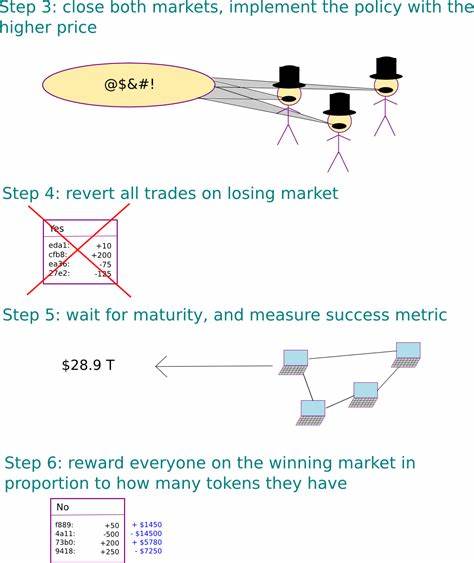

Dabei wird gezielt versucht, bösartige Eingaben in die Kommunikationsschnittstelle des KI-Modells einzuschleusen, um das normale Verhalten zu manipulieren. Solche Angriffsmethoden können zu unerwünschten Ergebnissen führen, wie dem Offenlegen vertraulicher Informationen, dem Ausnutzen von Tools auf unautorisierte Weise oder der Änderung des eigentlichen Agentenziels. Besonders gefährlich sind indirekte Prompt Injections etwa über kompromittierte Webseiten, die der Agent für das Sammeln von Informationen aufsucht – dadurch kann selbst der Gesprächsverlauf eines Nutzers an Angreifer weitergeleitet werden. Ein weiteres ernstzunehmendes Risiko stellt die Fehlkonfiguration der eingebundenen Tools dar. Wenn beispielsweise Eingabeparameter nicht ausreichend validiert oder bereinigt werden, können Angreifer Schwachstellen wie SQL Injection ausnutzen und so Zugang zu sensiblen Datenbanken erhalten.

Ebenso können eine mangelnde Zugriffskontrolle oder unzureichende Sandboxing-Mechanismen es ermöglichen, dass Schadcode direkt in den Host-Systemen ausgeführt wird. In Cloud-Umgebungen ist zudem die Gefahr präsent, dass über Exploits auf Metadata-Services zugegriffen wird, wodurch Angreifer sich Zugriff auf Service-Account-Token und damit auf weiterreichende Infrastrukturrechte verschaffen können. Die Komplexität und der erweiterte Funktionsumfang von KI-Agenten verlangen deshalb eine mehrschichtige Sicherheitsstrategie. Einzelmaßnahmen greifen oft zu kurz, da die Bedrohungen auf verschiedenen Ebenen wirken – von der Eingabeüberprüfung über die Promptgestaltung bis hin zur Kontrolle der Laufzeitumgebung. Eine strikte „Prompt Hardening“ genannte Technik zielt darauf ab, die Vorgaben und Anweisungen an den Agenten so präzise zu fassen, dass unerwünschte oder außerhalb des vorgesehenen Rahmens liegende Anfragen erkannt und blockiert werden.

Ergänzt wird dies durch Content Filtering, das laufzeitnahe Eingaben und Ausgaben überwacht, bösartige Muster erkennt und potenzielle Angriffe frühzeitig abwehrt. Gleichzeitig ist die Absicherung der eingebundenen Tools essenziell. Tool Input Sanitization soll sicherstellen, dass alle Eingaben den erwarteten Formaten und Grenzen entsprechen, um Missbrauch zu verhindern. Regelmäßige Sicherheitsüberprüfungen der jeweiligen Softwarekomponenten mittels statischer und dynamischer Analysemethoden helfen, aktuelle Schwachstellen frühzeitig zu identifizieren und zu beheben. Darüber hinaus ist besonders bei Code-Execution-Engines und Containerumgebungen eine konsequente Sandbox-Isolation essentiell.

Einschränkungen bei Netzwerkzugriffen, Beschränkungen von Systemaufrufen und minimalistische Berechtigungen verhindern, dass Angreifer durch Schadcode größere Schäden verursachen. Die Herausforderungen im Bereich der KI-Agenten-Sicherheit sind also ein Zusammenspiel aus neuen Angriffstechniken, den gewachsenen Angriffsmöglichkeiten durch Tool-Integration und den inhärenten Unsicherheiten von großen Sprachmodellen. Unternehmen und Entwickler müssen diese Aspekte ganzheitlich betrachten und ihre Lösungen mit umfassenden Schutzmechanismen ausstatten. Mit spezialisierten Produkten wie Prisma AIRS bieten Sicherheitsanbieter mittlerweile maßgeschneiderte Laufzeitüberwachungen, die ungewöhnliche Verhaltensweisen von Agenten erkennen und automatisiert Gegenmaßnahmen einleiten können. Ebenso helfen KI-Sicherheitsbewertungen dabei, bestehende Systeme zu analysieren, Schwachstellen zu identifizieren und geeignete Maßnahmenpläne zu entwickeln.

Nur durch ein durchdachtes, vielschichtiges und kontinuierlich gepflegtes Sicherheitskonzept gelingt es, die zahlreichen Vorteile von KI-Agenten auszuschöpfen, ohne das Vertrauen in deren Einsatz zu gefährden. Die technologische Zukunft wird maßgeblich von Agenten bestimmt werden, die eigenständig komplexe Aufgaben erledigen. Ihre Absicherung ist daher ein zentrales Anliegen, um Missbrauch zu verhindern und eine verantwortungsvolle, sichere Nutzung von Künstlicher Intelligenz zu gewährleisten. Abschließend bleibt festzuhalten, dass die rein technologische Weiterentwicklung von KI-Agenten mit einem ebenso intensiven Fokus auf Sicherheitsaspekte einhergehen muss. Das Aufklärungspotential kann durch offen zugängliche Forschungsergebnisse, wie die Analysen und Beispiele zu Angriffsszenarien sowie erreichbaren Code-Repositories, weiter erhöht werden.

So erhalten Entwickelnde konkrete Handlungsempfehlungen und können Best Practices schneller adaptieren. Datenschutz, Resilienz gegenüber Manipulation und Schutz vor Missbrauch bilden die Grundpfeiler einer vertrauenswürdigen KI-Zukunft, die zugleich die Innovationskraft ausschöpft und die Gefahren proaktiv adressiert. Nur so kann die Gesellschaft die Chancen, die intelligente Agenten bieten, sicher und nachhaltig nutzen.